fpdress - Fotolia

Deux cartes et un jeu pour mieux valoriser vos données

Bill Schmarzo, professeur adjoint au Menlo College à Atherton en Californie, et actuel Customer Advocate Data Management Innovation chez Dell, évoque ses méthodes inspirées du data storytelling pour sensibiliser les organisations aux défis du Big Data et de l’IA.

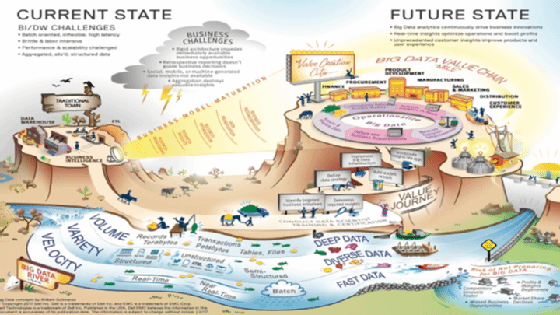

Au départ, j’avais publié « Big Data Storymap », en janvier 2013, pour présenter aux entreprises les facteurs essentiels d’une transition réussie vers le Big Data et la data science. L’outil permettait entre autres d’illustrer de façon créative le parcours de valorisation des données, et s’appuyait sur l’indice de maturité du modèle métier du Big Data.

1 - Big Data Storymap

Il explique aux organisations le passage de leur état actuel en matière d’informatique décisionnelle et d’entrepôts de données à leur état futur, grâce au Big Data, à la science des données et à l’ingénierie de la valeur (Figure 1).

L’intérêt d’une telle carte narrative était de fournir à mes interlocuteurs une représentation visuelle utilisant des métaphores et des points de repère pour les sensibiliser aux fondamentaux d’une stratégie Big Data réussie (du data storytelling donc !)

Voici les principaux points de cette carte (cf. Figure 2) :

- Point de repère n° 1 : Dynamiques de marché mouvantes Met en évidence les défis liés au marché qui nécessitent une approche différente pour intégrer le Big Data (données et analytiques) aux activités d’une entreprise.

- Point de repère n° 2 : Défis opérationnels et IT Fait ressortir les enjeux prépondérants auxquels les organisations ont été confrontées lors de la transformation de leurs environnements d’informatique décisionnelle et d’entrepôt de données pour bénéficier des avantages métier du Big Data.

- Point de repère n° 3 : Transformation des modèles métier au profit du Big Data Fournit un référentiel qui permet aux entreprises d’apprécier l’efficacité avec laquelle elles exploitent les données et les éléments analytiques pour faire évoluer leurs modèles métier.

- Point de repère n° 4 : Parcours de mise en œuvre du Big Data Définit un processus qui favorise l’alignement entre IT et métier afin d’obtenir des résultats exploitables et pertinents pour l’entreprise.

- Point de repère n° 5 : Opérationnalisation du Big Data Définit un processus de data science à même d’encourager le développement et l’amélioration en continu des données et des éléments analytiques pour rendre les capacités Big Data de l’entreprise opérationnelles.

- Point de repère n° 6 : Création de valeur Donne des exemples de fonctions métier qui pourraient bénéficier de ce parcours.

Figure 2 : Points de repère de la carte conceptuelle du Big Data

2 - Le jeu du Big Data

En octobre 2018, j’ai présenté une sorte d’extension de la Big Data Storymap qui propose une expérience ludique - de type jeu de plateau - pour aider les organisations à réussir leur parcours.

Je l’ai baptisé le jeu du Big Data (Big Data Game Board)

Figure 3 : Le plateau du jeu du Big Data

Le jeu du Big Data que montre la figure 3 ci-dessus mettait en évidence les écueils que pouvaient rencontrer les entreprises lors de la transformation de leurs données en valeur :

- Piège n° 1 : Vous êtes-vous retrouvé « pris au piège du gouffre de l’analytique » ou avez-vous réussi à « exploiter la valeur économique des données » ?

- Piège n° 2 : Vous êtes-vous « embourbé dans le marécage des données » ou êtes-vous parvenu à « élaborer une plateforme collaborative de création de valeur » ?

- Piège n° 3 : Vous êtes-vous lancé dans une « course sans fin à la technologie » ou êtes-vous « focalisé sur les résultats de l’entreprise » ?

- Piège n° 4 : Êtes-vous « en train de dériver avec des promesses trop ambitieuses » ou avez-vous adopté une approche « pragmatique en termes d’ingénierie de la valeur » ?

- Piège n° 5 : Avez-vous succombé dans la « plaine des décisions limitantes pour votre carrière » ou avez-vous réussi à gravir la montagne de la « conception du support métier » ?

De nombreux conseils pratiques, assortis de modèles et d’outils, liés à ce jeu aideront les organisations à créer de la valeur grâce au Big Data et à la science des données.

3 - La carte du parcours de valorisation de la gestion des données

Ces deux outils devraient permettre de stimuler la créativité au sein des organisations pour les inciter à exploiter plus efficacement leurs données et leurs éléments analytiques, afin de faire évoluer leurs modèles métier.

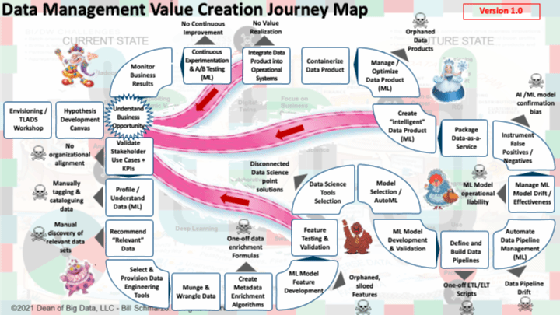

Passons maintenant au troisième volet de cette représentation visuelle, qui établit les bases du parcours de gestion des données en proposant une trajectoire claire vers leur valorisation. La « Data Management Value Creation Journey Map » ou « Carte du parcours de valorisation de la gestion des données ».

Cette carte propose une feuille de route claire qui va des données à la valeur. Elle intègre les disciplines de la gestion des données, de la data science et de la gestion d’entreprise (cf. Figure 4).

Figure 4 : Carte du parcours de valorisation de la gestion des données

Ce parcours peut être semé d’embûches et conduire à des prises de décision incorrectes qui se soldent par un échec (☠️). De plus, le fait de négliger ou d’abréger certaines étapes peut entraîner un retour à la case départ, ce qui induit un gaspillage de temps et de ressources financières et humaines, et surtout, peut éroder la confiance des parties prenantes.

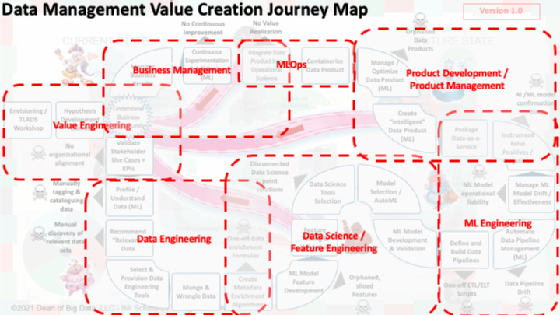

L’objectif de cette carte est de mettre en évidence la nécessité d’une collaboration étroite entre toutes les parties. Ainsi, la Direction pourra clairement formuler et quantifier la valeur commerciale et opérationnelle obtenue par la mise en œuvre des données et des éléments analytiques dans l’entreprise (Figure 5).

Figure 5 : Les différentes disciplines

La carte du parcours de valorisation des données inclut les disciplines suivantes :

- L’ingénierie de la valeur décompose l’initiative stratégique d’une organisation selon les exigences sur lesquelles elle repose en termes d’activité (parties prenantes, cas d’utilisation, indicateurs de performance clés), de données et d’éléments analytiques.

- La gestion des données permet de rassembler, stocker, organiser, étiqueter, cataloguer, gérer et sécuriser les données créées et recueillies par une organisation.

- L’ingénierie des données est responsable de l’agrégation, de la préparation, de la normalisation, du regroupement, de la mise en ordre et du traitement des données brutes. Elle a en outre pour mission de les rendre exploitables en aval, au sein d’une organisation et à l’échelle de l’écosystème de l’entreprise.

- Le Feature engineering oriente la collaboration entre les experts du domaine et l’équipe de data science pour sélectionner et transformer mathématiquement les variables de données afin d’élaborer des paramètres utilisés pour générer des modèles de machine learning et d’IA.

- La data science crée l’ensemble des modèles d’IA/ML utilisés pour identifier et codifier les propensions, les tendances, les récurrences et les relations enfouis dans les données et qui peuvent en être dégagés en rapport avec les clients, les produits et les opérations.

- L’ingénierie ML applique les principes de l’ingénierie logicielle aux processus de gestion des données et de data science pour gérer, contrôler et rendre opérationnels les modèles ML dans l’entreprise.

- Le MLOps est un ensemble de pratiques visant à déployer et à maintenir les modèles de machine learning en production de manière fiable et efficace.

Résumé : Créer une culture favorisant la valorisation des données

Ces trois outils visent à présenter de façon ludique et exploitable tout ce dont les entreprises ont besoin pour parvenir à valoriser leurs données.

Nous espérons qu’ils permettront de donner libre cours à la créativité et au potentiel de chacun au sein dans votre entreprise, et qu’ils vous permettront d’exploiter encore mieux le pouvoir du Big Data et de l’analytique.