SDS : l'essentiel sur Qumulo Core

LeMagIT vous propose un tour d'horizon des solutions de software defined storage du marché. Dans cet article, nous faisons le point sur la solution de stockage logicielle Qumulo Core, la solution de NAS scale-out de Qumulo.

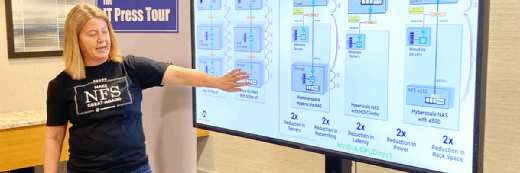

Qumulo, une start-up fondée par certains des développeurs clés d’Isilon, qui propose un système de stockage NAS en mode scale-out, dont la particularité est d’être disponible à la fois sous forme d’appliance physique et sous forme logicielle (pour l’instant sur les serveurs d’HPE et bientôt sur ceux d’autres constructeurs dont Dell EMC). Comme Isilon, Qumulo est basé à Seattle.

Un système de stockage en mode scale-out

Qumulo est le fruit des travaux de Peter Godman, Aaron Passey et Neal Fachan, respectivement CEO, directeur de l’ingénierie et CTO de la société. Le cœur de la solution de la firme est un OS de stockage baptisé Qumulo Core, basé sur Linux. Qumulo Core met en œuvre un système de fichiers NAS distribué développé par la société et baptisé QSFS (Qumulo Scalable File System).

Les données ingérées par un nœud Qumulo sont répliquées sur un autre nœud du cluster avant d’être écrites sur des SSD, puis progressivement basculées vers les disques durs du nœud et « stripées » sur autant de disques que disponibles. Ce mécanisme permet non seulement d’assurer l’intégrité des données en cas de défaillance matérielle de disques ou de nœuds, mais aussi d’optimiser les performances.

Les clusters Qumulo sont accessibles via des protocoles de partage de fichiers NAS standard (NFS v3 et SMB 2.1), ainsi qu’en mode objet via une API REST. Les volumes NFS ou SMB ne sont au final que des entités virtuelles consommant une partie de l’espace du pool de capacité QSFS. Il est à noter que la version 2.5 du logiciel, annoncé en novembre 2016, a apporté le support attendu des snapshots (par répertoire)

Des fonctions analytiques avancées

Pour se différencier de ces concurrents, Qumulo a fait le pari d’intégrer des fonctions analytiques avancées à son système de stockage. L’idée est de renseigner les administrateurs sur l’usage du cluster, les données dormantes, les données actives et de fournir des indications sur les pistes possibles en matière d’optimisation de performance. Il s’agit aussi d’aider les administrateurs à anticiper les évolutions de capacité via des fonctions d’analyse prédictive. En temps réel, la baie analyse les performances (en IOPS) et le débit du cluster et fournit des métriques détaillées sur la quantité de données stockées, sur l’espace disponible, sur la consommation par utilisateur… Toutes ces données sont exposées via une série de tableaux de bord avancés dans la console d’administration du cluster.