jules - Fotolia

Quelle place pour les disques durs dans un monde de SSD ?

Les disques durs sont loin de disparaitre, même si l’intérêt pour les SSD va croissant dans les datacenters.

Il devient de plus en plus difficile d’aimer les disques durs. Imaginés il y a près de soixante ans, ces périphériques sont lents et accèdent maladroitement aux données. Mais ils stockent des volumes d’informations de plus en plus conséquents à un prix difficile à battre.

Depuis le milieu des années 2000, les partisans des SSD annoncent que ces périphériques vont prochainement remplacer les disques. Pourtant, nous sommes en 2017, et la guerre entre disques durs et disques SSD continue à faire rage dans les datacenters.

Si l’on analyse les capacités stockées, les disques durs jouent toujours un rôle plus important que les SSD dans les PC et les serveurs. Et les livraisons de disques durs ne sont guère inférieures aux niveaux de 2005.

Alors pourquoi les flash SSD n’ont-ils pas conquis le marché ?

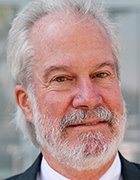

Pour faire bref, c’est parce que le remplacement des disques durs n’est pas la meilleure façon d’utiliser la technologie SSD. La figure 1 montre un continuum entre mémoire et stockage, chaque catégorie s’insérant dans une hiérarchie ordonnée. Les disques durs et les SSD jouent un rôle important dans cette hiérarchie, mais ils ne sont pas les seuls.

Parcourons ce continuum et faisons une analyse détaillée pour comprendre pourquoi.

Figure 1

Figure 1

La hiérarchie de stockage est illustrée dans la figure 1. Sur ce graphique, l’axe horizontal correspond au prix au gigaoctet tandis que l’axe vertical correspond à la bande passante de la technologie. Les axes sont étiquetés par ordre de grandeur -- 103 (1000), 104 (10 000), etc. -- pour aider à rendre plus visibles les valeurs les plus grandes et les plus petites.

En bas à gauche, figure le stockage sur bande, le périphérique de stockage le plus lent et le moins cher encore en usage courant. En haut à droite, figure la mémoire cache de niveau 1 du processeur, la mémoire la plus rapide et la plus chère d’un système. Entre les deux, de gauche à droite, on trouve les disques durs, les SSD à base de flash NAND, la mémoire dynamique (DRAM) ; puis les différents autres niveaux de cache.

Tout s’emboîte parfaitement chaque orbite étant plus rapide que celle qui se trouve en dessous, plus lente que celle du dessus, moins chère que l’orbite de droite et plus chère que l’orbite de gauche.

Au sein d’un système, la hiérarchie de stockage en mémoire utilise des algorithmes pour déplacer automatiquement les données chaudes dans les éléments plus rapides et plus coûteux de cette hiérarchie et les données froides dans des éléments plus lents et moins chers. Ceci est effectué à l’interface cache-DRAM et aux différents niveaux par la logique de gestion du cache du processeur. L’interface de stockage DRAM - disque dur ou SSD-NAND - est gérée à la demande par le système de gestion de la mémoire virtuelle du système d’exploitation.

Les SSD sont un élément relativement nouveau dans cette hiérarchie, de telle sorte que ce sont les logiciels de mise en cache, plutôt que le système d’exploitation qui gèrent l’interface SSD-HDD. La plupart des systèmes n’automatisent pas la hiérarchisation des données entre la bande et le disque dur.

Pour optimiser le rapport prix/performance d’un système, les responsables informatiques doivent idéalement trouver le meilleur équilibre entre la quantité de chaque mémoire ou élément de stockage qu’ils utilisent. S’ils ajoutent trop des éléments les plus performants, le prix du système est plus élevé que nécessaire. Et s’ils en utilisent trop peu, la performance en souffre.

Utiliser des SSD pour réduire les besoins en mémoire vive

Parce que la différence de vitesse entre la DRAM et le disque dur est importante - l’écart de latence est d’environ un pour un million - les administrateurs ont longtemps joué avec la quantité de mémoire vive du système afin de compenser les faibles performances des disques durs. Depuis l’introduction des SSD bon marché, cette approche a perdu de son attrait. Ces mêmes administrateurs système ont compris qu’utiliser un SSD est bien plus avantageux que d’augmenter la DRAM. En d’autres termes, ils utilisent des SSD, non pas pour remplacer les disques durs, mais pour réduire l’utilisation de DRAM.

Disque dur vs SSD : le modèle Flash Cloud

Certaines entreprises ont adopté un modèle mixant usage local de la flash pour les données requérant de la performance et recours à des ressources distantes dans le cloud pour le stockage de données « froides ».

En quoi cela change-t-il le modèle économique du stockage ? Comment cela modifie-t-il le modèle de tarification ?

Comme la latence d’accès au cloud est considérablement plus élevée que celle d’un disque dur local, l’usage du cloud directement en complément de SSD locaux ne semble pas être la façon la mieux adaptée de tirer parti de la hiérarchie mémoire-stockage de la figure 1.

En revanche, en optant pour une approche hybride mêlant SSD et disques durs en local et stockage cloud, les entreprises devraient pouvoir obtenir les mêmes performances qu’un système Flash + Cloud mais à moindre coût.

Notons que le stockage cloud repose en grande partie sur des disques durs, de sorte que les disques durs n’ont pas été éliminés de la hiérarchie du stockage en mémoire. Ils ont simplement été déplacés d’une installation à l’autre, avec des temps de latence plus longs, une gestion différente et peut-être un coût plus élevé.

Figure 2

Figure 2

Un peu de maths suffisent à comprendre cette approche. Admettons que la DRAM est environ 1000 fois plus rapide qu’un SSD, et qu’un SSD est approximativement 1000 fois plus rapide qu’un disque dur. Admettons aussi que 100 € vous permettront d’acheter 10 fois plus de gigaoctets de capacité Flash NAND que de mémoire vive.

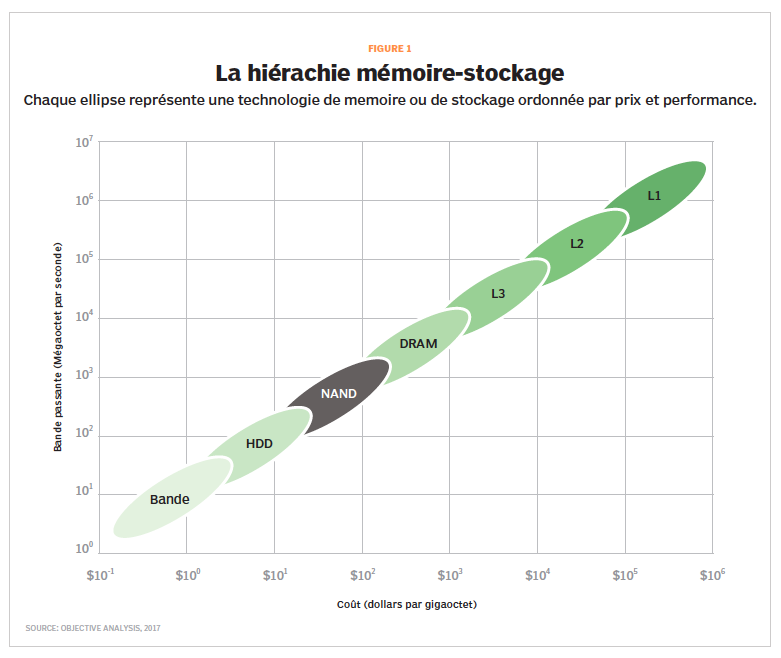

Les logiciels accèdent à la hiérarchie mémoire-stockage selon un schéma similaire à celui d’une courbe en cloche : certaines données sont accédées de façon intensive sur une courte période de temps, d’autres beaucoup moins fréquemment. La figure 2 en est une illustration.

La performance est affectée par la façon dont les données sont accédées par les applications. De façon générale, certaines applications accèdent à un grand nombre de données sur une période donnée, tandis que d’autres accèdent de façon intensive à un plus petit jeu de données.

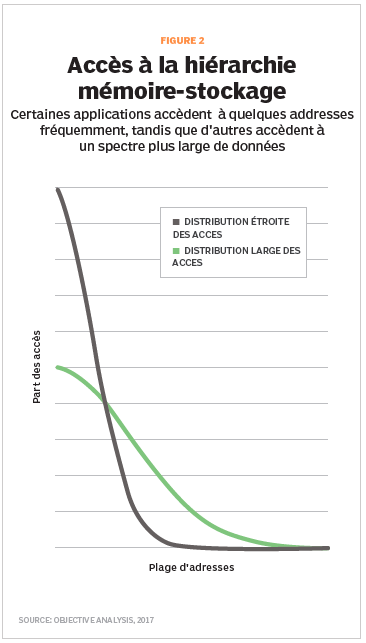

Figure 3

Figure 3

Dans la figure 3, une application du second type fait un usage bien plus efficace de la RAM disponible pour optimiser ses performances. Tandis qu’une application travaillant sur un large jeu de données ne peut mettre en cache qu’une fraction de ses données.

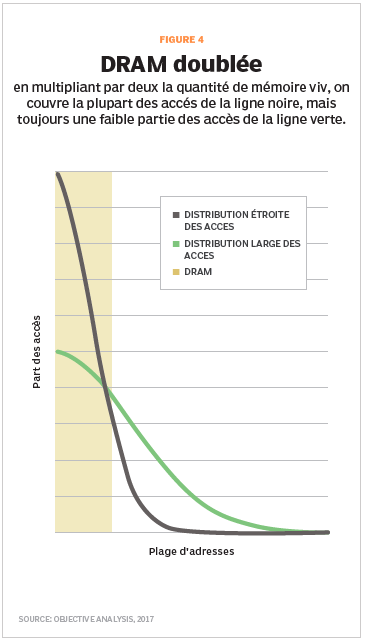

Dans la figure 4, avec le double de DRAM, une application travaillant de façon intensive sur un petit jeu de données profite à plein de la mémoire additionnelle, tandis qu’une application travaillant sur un large jeu de données ne voit que des gains marginaux.

Figure 4

Figure 4

Si le système utilisé n’a pas de SSD, cela veut dire que les accès qui ne se font pas en mémoire se font sur des disques durs, donc avec une pénalité de l’ordre d’un million de fois en matière de latence.

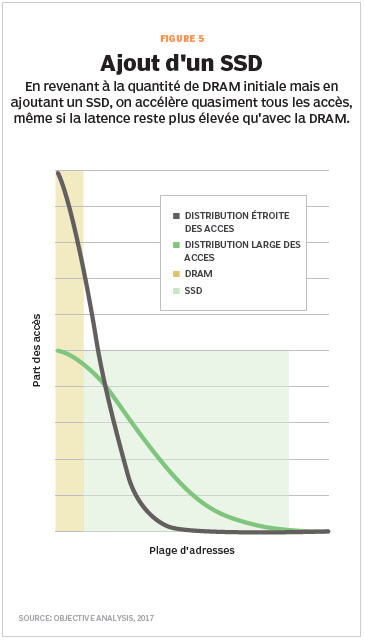

Plutôt que de doubler la capacité de mémoire vive, nous avons tenté d’examiner le comportement des mêmes applications si, au lieu d’acheter de la mémoire additionnelle, on investit le même montant dans un étage intermédiaire de stockage SSD.

Dans la figure 5, le pavé mémoire en jaune est complété par un second pavé gris nettement plus large, car il est possible d’acheter 10 fois plus de gigaoctets de capacité de stockage SSD que de DRAM pour un montant donné. En revanche, ce pavé est décalé vers le bas dans le schéma, car la latence d’accès à la flash est supérieure à celle de la mémoire vive.

Figure 5

Figure 5

L’intérêt de cette configuration est qu’elle couvre la quasi-totalité des accès des applications et ce, quel que soit leur profil. La pénalité de latence d’un million de fois des disques durs ne touche plus qu’une très faible proportion des accès. C’est pour cela qu’à prix équivalent il est intéressant de déployer de la capacité flash en lieu et place d’une quantité de mémoire additionnelle bien inférieure.

Mettons quelques chiffres autour de ça.

Avec la configuration minimale de DRAM, environ 55 % des accès des applications utilisant un petit jeu de données sont satisfaits. C’est la surface sous la courbe noire de la figure 3 dans la boîte DRAM. Lorsque vous doublez la quantité de mémoire vive, 90 % des accès de la même application sont couverts, comme le montre la surface sous la courbe noire de la figure 4 dans les deux boîtes DRAM. Si nous décidons de ne pas mettre la DRAM additionnelle, mais plutôt d’ajouter un SSD qui coûte le même montant que la DRAM additionnelle, alors seulement environ 1 % des accès doivent aller au disque dur - représenté par la zone sous la courbe noire de la Figure 5 qui se trouve en dehors des deux boîtes.

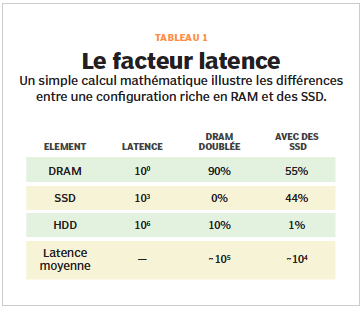

Le tableau 1 compare les informations de latence des différentes technologies en prenant pour base 1 la latence de la mémoire vive.

Dans le scénario imaginé, le doublement de la RAM satisfait 90 % de tous les accès, et 10 % des accès souffrent d’un accroissement de la latence d’un facteur d’un million de fois. Cette pénalité de latence a un impact énorme, car au final la latence moyenne d’accès à l’ensemble des données sur le système est d’environ un dixième de celle du disque dur, soit 100 000 fois supérieures à celle de la mémoire vive.

En utilisant des SSD au lieu d’ajouter de la mémoire vive supplémentaire, la DRAM satisfait 55 % des accès, et les SSD 44 %. Seuls 1 % des accès subissent la pénalité des disques durs. La latence moyenne d’accès aux données est réduite d’un facteur de dix et s’établit à 10 000 fois celle de la mémoire vive.

Il peut être difficile de déterminer le profil I/O d’une application, mais cela vaut la peine de tester de multiples scénarios avec des quantités variables de stockage DRAM et SSD pour voir quelle est la solution qui offre le meilleur rapport prix/performance.

De façon générale, les SSD sont les plus efficaces non pas en remplacement des disques durs, mais comme un moyen de tirer le plus de performance d’un système que ne pourrait le faire une plus grande quantité de mémoire. Un nombre croissant d’administrateurs système l’ont compris. Ils ne se concentrent plus sur la bataille entre disques durs et SSD mais se préoccupent plutôt de la recherche du meilleur équilibre entre usage des SSD et de la DRAM.

L’analyse ci-dessus ne considère que le rapport entre la performance et le coût en capital. Mais les SSD ont aussi des atouts en matière de coût total de possession (TCO).

Ces périphériques permettent en effet de réduire la consommation électrique et le coût de refroidissement des serveurs et, dans certains cas, les coûts de maintenance. Cela fait pencher la balance en faveur des SSD dans les installations où Capex et Opex sont gérés par la même organisation.

Rôle d’Intel Optane dans les disques durs vs SSD

Intel a récemment lancé de nouveaux supports de stockage à base de mémoire Optane sous forme de cartes et disques SSD PCIe NVMe. Il s’apprête également à dévoiler des barrettes au format DIMM. Offrant une latence inférieure à celle de la mémoire Flash, la mémoire Optane s’insère entre la mémoire vive dynamique et la NAND dans la hiérarchie illustrée sur la figure 1.

De ce fait, Intel incite les administrateurs système à repenser leur hiérarchie de stockage en faveur d’une réduction des besoins en DRAM, car la couche d’Optane permet de combler une large partie de l’écart entre mémoire NAND flash et mémoire DRAM, et ce à un prix très inférieur à celui de la mémoire vive.

Les SSD finiront-ils par être moins chers que les disques durs ?

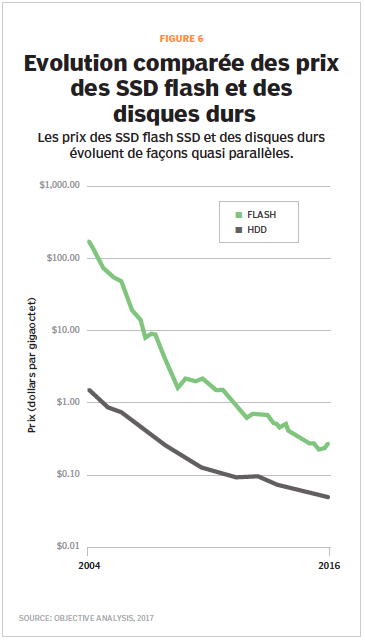

Depuis plus d’une décennie, les partisans des SSD affirment que les prix des disques durs et des disques SSD convergent rapidement et que l’écart de prix entre les deux va disparaître, ce qui à terme éliminera l’intérêt des disques durs par rapport aux disques SSD. En réalité, bien qu’il y ait des projections en ce sens, on en est encore loin.

La figure 6 montre l’historique des prix des disques durs et des supports flash NAND.

Figure 6

Figure 6

Un examen attentif de ce graphique indique que les lignes devraient converger progressivement, sur un horizon de 15 à 20 ans. Mais les courbes restent encore largement parallèles et pour de bonnes raisons.

Les prix des SSD sont déterminés par la loi de Moore, mais aussi par l’aptitude des fournisseurs à continuer la course à la densité en empilant un nombre croissant de couches de NAND dans leurs modules flash. Ces prix diminuent d’environ 30 % par an à capacité égale.

La capacité de stockage d’un disque dur augmente d’environ 30 % par an, selon la feuille de route technologique de l’ASTC. Et les disques durs les plus vendus du marché, ceux qui offrent la capacité la plus élevée au prix le plus faible - environ 50 € - voient leur capacité progresser au même rythme, ce qui fait que le rapport capacité/prix évolue peu ou prou au même rythme que celui des SSD.

La conclusion est que les SSD ne sont pas près d’être en concurrence directe en matière de prix avec les disques durs.

Il reste de la place pour les disques durs

Au vu des caractéristiques respectives des SSD et des disques durs, il est vraisemblable que les datacenters vont continuer à utiliser des disques durs pour le stockage afin de maintenir le meilleur ratio prix/performances tout en équilibrant, à tous les niveaux, la hiérarchie stockage-mémoire des différents systèmes.

Il y a donc de la place pour les disques durs dans un monde de SSD, aujourd’hui, comme dans les années à venir.