Machine learning : six conseils pour faire la chasse aux biais

À mesure que l’adoption du machine learning se développe, les entreprises doivent devenir des experts en préparation de données, faute de quoi elles risquent d’obtenir des résultats inexacts, injustes ou même dangereux. Voici comment lutter contre les biais inhérents au machine learning.

Les entreprises commencent à s’appuyer sur des algorithmes dans le cadre de leurs opérations quotidiennes. Elles deviennent de plus en plus dépendantes de ces systèmes nourris à l’IA pour les aider à prendre des décisions critiques. Dans certains cas, les algorithmes ou les mécanismes d’automatisation agissent sans intervention humaine, ce qui implique une attention toute particulière à ce que le processus de décision associée fonctionne comme prévu.

Cependant, l’efficacité des algorithmes dépend fortement des données utilisées pour les entraîner. Si les informations qui les nourrissent sont biaisées, les décisions qu’ils prendront le seront également. Cela peut provoquer un manque de confiance, voire entraîner des conséquences néfastes.

Dans cet article, vous apprendrez pourquoi il faut se préoccuper des biais et des déviances algorithmiques, comment les identifier et nous vous présenterons six méthodes pour réduire leurs effets.

Pourquoi réduire les biais est-il important ?

Le machine learning, comme son nom l’indique, apprend des informations dont on le nourrit pour repérer des éléments dans des données, auxquels il n’a jamais eu accès auparavant. Cependant, l’un des nombreux défis rencontrés par les data scientists consiste à s’assurer que les données d’entraînement sont non seulement « propres », exactes et correctement étiquetées dans le cadre d’un apprentissage supervisé, mais également exemptes de tout élément pouvant fausser les résultats.

Si un système d’apprentissage statistique affublé d’un pouvoir de décision s’appuie sur des informations altérées, il peut poser de graves problèmes.

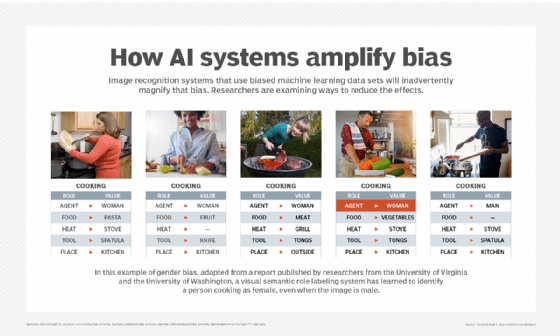

Parmi les mauvais exemples causés par des biais algorithmiques, on peut citer : un système de reconnaissance d’images de Google qui a mal identifié les images des minorités de manière offensante ; des demandes de crédit automatisées de Goldman Sachs qui ont déclenché une enquête sur les préjugés sexistes ; et un programme d’IA à caractère racial utilisé pour condamner les criminels. Les entreprises doivent être très vigilantes face aux préjugés liés au machine learning. Les apports de l’IA en termes d’efficacité ou de productivité seront anéantis si les algorithmes discriminent les individus ou des minorités.

Les biais présents dans les modèles d’intelligence artificielle ne sont pas limités aux préjugés envers les individus. Un jeu de données faussé peut impacter l’activité d’une entreprise. Interpréter des gestes, des coutumes vestimentaires, des résultats financiers, etc. réclame la prise en compte de nombreux facteurs et d’un contexte pour que l’utilisation de l’algorithme ne tourne pas au gaspillage de ressources informatiques.

Les data scientists à l’origine de ces algorithmes doivent prendre conscience qu’il est pratiquement impossible d’éviter les biais. Pour des raisons culturelles, économiques, politiques, organisationnelles, technologiques, de choix des données et la manière de les corréler, un modèle d’apprentissage statistique est une photographie d’un mode de pensée qu’il reproduit à la virgule près. Cet état de fait invite à une prise de recul, un mouvement bénéfique pour améliorer la pertinence d’un modèle ML.

Comment identifier un biais dans une IA

L’identification de biais, dans certains types d’algorithmes, pose véritablement question. L’une des difficultés consiste à comprendre comment un modèle généralise l’apprentissage qu’il a effectué à partir des données d’entraînement.

Les Data Scientists doivent faire attention à la manière dont ils sélectionnent les données d’entraînement et les caractéristiques ou dimensions qui sont incluses dans les données pour la formation à l’apprentissage automatique.

Le modèle doit représenter les données telles qu’elles existent dans le monde réel. Si votre jeu de données est artificiellement limité à un sous-ensemble, vous obtiendrez des résultats faussés, même s’il est très performant sur les données utilisées. Ou alors son utilisation correspondra à un cas d’usage précis dans lequel les conditions réelles sont identiques à celles de la phase d’apprentissage.

Souvent les algorithmes de Deep learning sont pointés du doigt.

Appréciés pour leur capacité à ingérer de gros volumes de données et leur efficacité dans la résolution de problèmes complexes, ils sont souvent perçus comme des boîtes noires. Sans surveillance lors de l’apprentissage, les processus de décision semblent complexes à retracer. Il existe pourtant des méthodes pour maîtriser plus facilement ces réseaux neuronaux. C’est ce que cherchent à mettre en place de plus en plus d’équipes de data science.

Les entreprises luttent contre les biais inhérents aux données en mettant en œuvre des programmes visant à élargir non seulement la diversité de leurs ensembles de données, mais aussi celle de leurs équipes. Plus de diversité dans les équipes signifie que des personnes aux perspectives et aux expériences variées alimentent les systèmes. Cela induit une plus grande attention à certaines formes de biais.

Malheureusement, l’industrie IT est aujourd’hui très homogène : il y a encore peu de femmes et peu de diversités ethniques. D’autant que le data scientist en lui-même est un profil rare et très recherché par les entreprises.

Différents types de biais à appréhender

- Biais d’échantillonnage. Une des erreurs les plus courantes lors de la collecte des données résulte d’un manque de représentativité. Certains éléments peuvent être suréchantillonnés par rapport à la réalité. Prenons l’exemple d’une entreprise qui cherche à prédire les pannes sur ses machines. Si elle collecte majoritairement des informations sur les erreurs, l’algorithme ne sera pas en capacité d’identifier suffisamment précisément le fonctionnement normal de l’équipement.

- Biais de mesure. Le biais de mesure est le résultat de l’absence de mesure ou d’enregistrement précis des données qui ont été sélectionnées. Par exemple, si vous utilisez le salaire comme mesure, il peut y avoir des différences de traitements (primes, avantages…), ou des différences régionales dans les données. D’autres biais de mesure peuvent résulter de l’utilisation d’une normalisation incorrecte des données ou d’erreurs de calcul.

- Biais d’exclusion. Tout comme le biais d’échantillonnage, le biais d’exclusion provient de données qui sont retirées de manière inappropriée de la source de données. Lorsque vous avez des pétaoctets de données, il est tentant de sélectionner un petit échantillon à utiliser pour la formation, mais ce faisant, vous risquez d’exclure par inadvertance certaines données, ce qui se traduit par un ensemble de données biaisées. Un biais d’exclusion peut également se produire en raison de la suppression des doublons dans les données lorsque les éléments de données sont réellement distincts.

- Biais d’enregistrement. Parfois, l’acte d’enregistrer les données lui-même peut être biaisé. Lors de l’enregistrement des données, le chercheur peut n’enregistrer que certaines données, et en ignorer d’autres. On peut concevoir un algorithme de machine learning basé sur des données en provenance de capteurs IoT, mais si l’enregistrement n’est pas continu, certaines données peuvent manquer. Ou bien il y a un autre problème systémique dans la façon dont les données ont été observées ou enregistrées. Dans certains cas, les données elles-mêmes peuvent même devenir biaisées par l’acte d’observation ou d’enregistrement de ces données, ce qui pourrait déclencher des changements de comportement. D’autres problèmes peuvent survenir lors de cette phase de collecte. Ils peuvent causer des changements de comportement de l’algorithme.

- Biais liés aux préjugés. Dans certains cas, les données en entrée sont entachées par des préjugés humains qui favoriseront différents éléments en fonction de leur idéologie. Lorsque l’on utilise des données historiques pour former des modèles, en particulier dans des domaines où les préjugés étaient auparavant très répandus, il faut veiller à ce que les nouveaux modèles ne les prennent pas en compte.

- Biais de confirmation. Le biais de confirmation est le désir de sélectionner uniquement les informations qui soutiennent ou confirment quelque chose que vous connaissez déjà, plutôt que des données qui pourraient suggérer quelque chose qui va à l’encontre d’idées préconçues.

- Effet de mode. Cette forme de biais apparaît généralement quand les data scientists repèrent une tendance dans un data set. Au fur et à mesure que le volume d’informations relatif à cette tendance prend de l’ampleur, il y a un risque de surreprésenter ce phénomène qui peut être au final de courte durée.

Il existe d’autres types de phénomènes qui peuvent influencer les performances ou la pertinence d’un algorithme. Ceux décrits ci-dessus doivent être pris en compte rapidement au lancement d’un projet.

Six mesures pour éviter les biais algorithmiques

- Identifier les sources potentielles de biais

En utilisant la liste établie ci-dessus, il est possible de réduire significativement les effets nocifs que nous avons décrits jusqu’ici. Il est important de se poser les questions concernant la procédure de sélection, de collecte, ou encore de la pertinence des données historiques.

- Mettre en place une procédure pour éviter le phénomène

Pour éviter les biais, les organisations doivent établir des lignes directrices, des règles et des procédures pour identifier, communiquer et atténuer les biais potentiels des ensembles de données. Les organisations tournées vers l’avenir documentent les cas de partialité au fur et à mesure qu’ils se produisent, décrivent les mesures prises pour identifier la partialité et expliquent les efforts déployés pour l’atténuer. En établissant ces règles et en les communiquant de manière ouverte et transparente, les entreprises peuvent parfaire leur utilisation de l’apprentissage statistique.

- Identifier les données représentatives

Avant de collecter et d’agréger des données d’entraînement, les entreprises doivent d’abord essayer de comprendre à quoi ressemble un jeu de données représentatif. Les data scientists doivent corréler les données avec les individus ou les objets dont elles proviennent.

- Documenter la phase de préparation de données

Afin de réduire les biais lors de la préparation de données, les organisations doivent documenter leurs méthodes de sélection et de nettoyage des données et permettre aux autres d’examiner quand et si les modèles présentent une forme quelconque de biais. La transparence permet d’éliminer les causes profondes d’une déviation d’un modèle lors de la prochaine itération.

- Sélectionner les modèles les plus performants et les moins biaisés

Avant leur passage en production, un algorithme de machine learning passe généralement par une phase d’évaluation. La plupart du temps, les data scientists et les data engineers se concentrent sur la précision et l’efficacité du modèle. Ajouter une étape pour repérer les possibles biais permet d’améliorer un modèle, mais aussi d’écarter des données d’entraînement non pertinentes.

- Surveiller les modèles déployés en production

Dans un environnement de test, un algorithme peut afficher un comportement exemplaire. Une fois appliquée à des cas d’usage réels et sans surveillance, le modèle pourrait tendance à dévier. Ce phénomène doit non seulement être surveillé, mais corriger de manière continue. L’application d’une approche CI/CD dans la gestion des pipelines ML devient alors primordiale. La mise en place d’une politique DataOps, le penchant du DevOps appliqué au flux de données, apparaît comme essentielle. Évidemment, les data scientists, data engineers, machine learning engineers, les responsables d’exploitation doivent travailler de concert avec le Chief Data Officer et la direction.