Comment réaliser la mise en œuvre hybride d’une stratégie MobileFirst

Les infrastructures hybrides mêlant services en ligne, mobilité en tout temps, et infrastructure sur site sont la norme de nos jours. À travers cet article nous proposons de comprendre leurs fonctionnements, avantages et risques.

À l’instar des conceptions d’applications, la réflexion autour d’une architecture moderne doit se penser en MobileFirst : la mobilité doit être le pivot principal des interconnexions de l’infrastructure. Il ne s’agit plus de contrôler uniquement le réseau interne de l’entreprise, mais plutôt d’assurer indépendamment la sécurité et la conformité de chaque appareil où qu’il soit.

Face à ce genre de problématique, le réflexe serait d’opter pour une approche basée uniquement sur des services en ligne. Mais que faire des systèmes qui pilotent l’intégralité de votre infrastructure actuelle ? Il existe des solutions, comme le cloud hybride, que nous allons détailler ici. Les composants critiques, tels que l’annuaire ou l’autorité de certification resteront en interne, mais seront exposés de manière sécurisée et restreinte aux services en ligne. Ces derniers (messagerie, gestionnaire de mot de passe, accès aux logiciels, etc.) iront s’approvisionner sur les bases des composants internes pour fournir leurs accès.

L’idée principale est de s’affranchir en partie des services historiques tels que l’Active Directory pour gérer les accès des services en ligne.

Exemple de la suite Workspace ONE

Il existe actuellement plusieurs suites logicielles pour basculer une architecture historique en configuration moderne. Nous allons prendre en exemple Workspace ONE de VMware, mais on retrouve souvent les mêmes types de composants chez d’autres éditeurs comme Microsoft, MobileIron (racheté par Ivanti en 2020), Citrix, Sophos, etc. L’ensemble des notions abordées dans cet article est valide, quelle que soit la combinaison de produits que vous choisissez.

Nous utilisons ici la suite de VMware afin de servir de démonstrateur à une architecture et un ensemble de connaissance. La plupart des composants de la suite sont autonomes et indépendants, en fonction de vos besoins et des outils déjà en place dans vos services, ils ne seront pas tous utiles ou pertinents. Dans tous les cas certaines fonctionnalités requièrent l’installation de connecteurs sur vos serveurs internes. Voici les composants les plus notables pour transformer votre infrastructure en un système moderne orienté vers la mobilité.

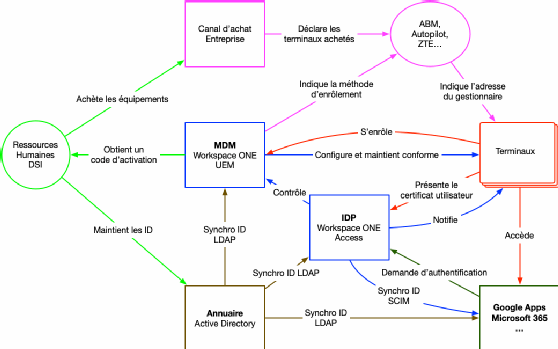

- Workspace ONE UEM. C’est l’élément principal qui permet de piloter l’ensemble des appareils (Windows, macOS, Android, iOS, ChromeOS) à l’intérieur et hors des murs de l’entreprise. Grâce à cette solution, vous pourrez déployer des logiciels, les mettre à jour ainsi que les OS, installer des profils de configuration et de sécurité, appliquer des règles de conformité et concevoir des rapports d’utilisation. En France ce système est appelé gestionnaire de terminaux mobiles, mais on le retrouve le plus souvent sous l’appellation MDM (Mobile Device Management). Pour associer les utilisateurs de votre annuaire aux terminaux et profils qui seront déployés par WS1 UEM, un CloudConnector est requis dans votre infrastructure interne.

- Workspace ONE Access. Ce composant peut servir de source unique pour la gestion des identités de votre SI, c’est un fournisseur d’identité autrement appelé IDP (identity provider). En utilisant votre annuaire historique comme base de référence, WS1A valide les accès aux différents services en ligne que l’on rencontre sous le sigle SP (Service Provider). Pour synchroniser les utilisateurs de votre annuaire et leur attribuer des accès aux différents services en ligne, un AccessConnectordoit être installé sur vos serveurs internes.

- Unified Access Gateway et VMware Tunnel. VMWare Tunnel est une application pour terminaux en situation de mobilité qui permet d’établir des connexions VPN PerApp au travers de la Unified Access Gateway (UAG) vers les ressources internes non exposées sur Internet. On peut ainsi se passer d’un VPN global qui ferait transiter l’ensemble des données sur le réseau interne de l’entreprise et basculer sur des flux dédiés à des applications identifiées qui accèdent ainsi uniquement aux ressources dont elles ont besoin. L’UAG offre également des services de Reverse Proxy authentifié permettant d’exposer sur Internet des services web sans nécessiter d’ouverture de tunnel et sans pour autant exposer le service au grand jour. Celui-ci n’étant accessible qu’après un premier niveau d’authentification.

- Remote Assist. Ce module complémentaire vient en concurrence directe avec des produits d’assistance tels que TeamViewer ou AnyDesk. Il permet d’amorcer la prise en main directement depuis la console UEM avec la validation par l’utilisateur final d’un code PIN temporaire. Lorsque déployé sur vos infrastructures, il permet une gestion de l’assistance à distance indépendante de tout service en Cloud.

Gestion de flotte en mobilité

Dans un monde de plus en plus mobile et connecté, les personnels des entreprises ont recours aux outils numériques pour un nombre croissant de tâches et de métiers. Les lieux d’utilisations sont également plus variés : télétravail, déplacements en clientèle, mobilité sur le lieu même de travail (usine, établissements de soins, écoles, entrepôts, commerces, bureaux configurés en flex-office, etc.). Plus largement encore, il est intéressant de considérer la mobilité comme, à minima, une solution de continuité d’activité. Aussi, il devient indispensable aujourd’hui de concevoir les déploiements de flottes avec la mobilité comme ligne directrice ; avoir une approche MobileFirst.

Par rapport aux parcs traditionnels de postes de travail fixes installés dans les bureaux, plusieurs choses changent et doivent être prises en considération. Premièrement, les ordinateurs doivent pouvoir sortir du réseau de l’entreprise sans compromettre leur sécurité. Ils doivent pouvoir être maintenus en conformité où qu’ils se trouvent, ce qui fait que leur gestion et leur fonctionnement ne sauraient dépendre de services internes qui ne peuvent être ouverts sur Internet, tel qu’un Active Directory. Ensuite, leur configuration initiale par l’intervention de techniciens du service informatique est une contrainte forte : plus de temps passé, délais de livraison à l’utilisateur final plus important, là où il serait plus intéressant de pouvoir lui livrer directement la machine.

Parallèlement, les techniques de déploiement évoluent vers plus d’efficacité. Le déploiement d’images système monolithiques n’est plus adapté aux besoins actuels. Il est rarement utile de réinstaller le système d’exploitation alors que la machine est déjà livrée avec. Les applications sont mises à jour fréquemment ; il faudrait donc refaire régulièrement les images de déploiement. Mais aussi, tous les utilisateurs n’ont pas forcément besoin de toutes les applications disponibles dans l’entreprise ; il n’est donc pas nécessaire de toutes les installer dès le début, on préférera les mettre à disposition à la demande. De plus, les applications accessibles dépendent également des métiers et habilitations de chaque utilisateur. Les réglages gérés sur les systèmes peuvent évoluer dans le temps, changer pour diverses raisons (nouvelles politiques de sécurité, nouveaux usages…), quand ils ne sont pas personnalisés en fonction de l’utilisateur.

Aussi, il est nécessaire d’avoir une approche de déploiement plus efficace, plus souple, plus évolutive et capable de s’inscrire dans un scénario MobileFirst. Cette solution, c’est le MDM ou UEM pour Unified Endpoint Management qui est le terme couramment employé quand il s’agit de gérer différentes plateformes dans une solution unique. Tous les terminaux des utilisateurs sont ainsi gérés : ordinateurs fixes et portables qu’ils soient nominatifs ou partagés, smartphones, tablettes, écrans de salles de conférences, mais aussi les machines virtuelles utilisées comme bureau distant (VDI).

Un scénario typique actuel de déploiement de flotte mobile se déroule de la manière suivante :

- les nouveaux appareils sont achetés par des canaux spécifiques de sorte à être inscrits dans le portail de gestion pour l’entreprise ;

- ils sont livrés ou remis en main propre directement aux utilisateurs finaux, neufs et dans le carton d’origine ;

- l’utilisateur déballe alors son appareil, l’allume et le connecte à Internet ;

- le terminal s’enrôle automatiquement dans la solution UEM, via l’Automated Device Enrollment chez Apple, Windows AutoPilot chez Microsoft, Chromebook Enterprise chez Google, etc. ;

- l’UEM pousse alors les configurations et politiques de sécurités (chiffrement du stockage, règles de mot de passe ou code PIN, réglages réseau filaires ou Wifi, comptes emails, etc.), ainsi que les applications et agents de sécurité obligatoires.

- Comme évoqué précédemment, ce scénario de déploiement permet de personnaliser la configuration pour chaque utilisateur, en fonction de son métier, de son rôle et de ses habilitations. Il est donc nécessaire que la solution UEM connaisse ses éléments. C’est l’annuaire d’entreprise qui les lui fournit par l’intermédiaire des groupes et unités d’organisation constitués à partir des informations RH de l’entreprise.

Une vision zero trust de la gestion d’identité et d’authentification

Pour mieux comprendre la vision Zero Trust (ou sans confiance, en français), il faut remettre en contexte son émergence. En effet, on observe depuis plusieurs années des changements conséquents dans les usages de l’informatique au travail. Outre que l’outil devient incontournable pour de plus en plus de métiers, les contextes, types de terminaux, les lieux d’utilisations et la nature des applications changent. Bien qu’accélérées par la pandémie de COVID-19, nombre de ces transformations étaient déjà en cours. Les principales sont :

- l’augmentation de la quantité et de la diversité d’informations générées, stockées, échangées et consommées via l’informatique ;

- le recours à de nombreuses applications en ligne, qui ne sont donc pas protégées derrière le pare-feu du réseau de l’entreprise ;

- le travail de plus en plus fréquent en dehors des locaux de l’entreprise, en télétravail bien sûr, mais également en clientèle, dans les transports et sur des sites géographiques plus vastes et sur lesquels il n’est pas toujours possible de déployer un réseau privé d’entreprise ;

- le recours croissant aux terminaux mobiles (smartphones, tablettes, ordinateurs portables, etc.), indispensables aux scénarios de mobilités, mais qui apportent aussi plus de souplesse dans leur usage (flex-office, réunions, etc.) ;

- le recours croissant au BYOD (Bring Your Own Device), qui offre la possibilité aux utilisateurs d’utiliser leurs propres terminaux pour accéder aux applications et données de l’entreprise ;

- mais aussi, l’augmentation du niveau de menace, avec des attaques plus fréquentes, plus variées, plus ingénieuses, etc.

Dans ce contexte, le modèle traditionnel de sécurité périmétrique, sans pour autant devenir obsolète, montre ses limites :

- les applications et services en ligne ne sont plus protégés par le pare-feu de l’entreprise ;

- le recours au VPN pour accéder aux ressources internes est à doubles tranchants : s’il permet de sécuriser la connexion du client comme s’il était sur le réseau interne, il ouvre aussi un point d’entrée dangereux si ce terminal est compromis ;

- accorder une confiance implicite aux terminaux et aux actions des utilisateurs ne permet plus d’apporter une sécurité suffisante.

La vision Zero Trust vient pallier ces défauts en tâchant de s’adapter aux nouveaux paradigmes d’usages, sans pour autant remplacer complètement la sécurité périmétrique, particulièrement en infrastructure hybride. Pour atteindre cet objectif, nous devons mettre en œuvre plusieurs concepts clés :

- la gestion centralisée des identités et des accès ;

- le recours à des authentifications fortes, multifactorielles, gérées par un fournisseur d’identités central aux différents services ;

- le contrôle régulier (y compris dans le processus d’authentification) de la conformité des terminaux d’entreprise et personnels (version du système d’exploitation, chiffrement du stockage, état de l’antivirus, etc.) ;

- le chiffrement systématique de toutes les connexions entre clients et serveurs, qu’il s’agisse de ressources internes ou en cloud, accéder depuis le réseau interne ou depuis Internet ;

- l’analyse des comportements de connexions et d’accès aux ressources (lieux de connexions, horaires, terminaux utilisés) ;

- l’étude de la sensibilité des ressources (certaines peuvent être accessibles depuis des terminaux personnels, d’autres uniquement depuis des terminaux d’entreprise) ;

- l’adaptation des mécanismes d’authentification selon les niveaux de risques mentionnés dans les points précédents (par exemple on ajoutera un troisième facteur d’authentification pour accéder à des données plus sensibles).

Dans l’exemple appliqué de la solution Workspace ONE, voici comment les rôles se répartissent :

- Unified Endpoint Management est le module en charge de la gestion des terminaux (macOS, iOS/iPadOS, Android, Windows, ChromeOS), il déploie donc les profils de configurations, les applications, applique les politiques de sécurité propres aux terminaux et audite également leur état de conformité ;

- Workspace ONE Access est le fournisseur d’identités. Synchronisé avec l’annuaire source des identités, il a pour rôle d’authentifier les utilisateurs sur l’ensemble des services, On-Premise comme en Cloud, qui y sont fédérés. Il imposera les mécanismes d’authentification choisis pour chaque application, groupes d’utilisateurs, et en tenant compte des comportements et lieux de connexion et dialoguera avec UEM pour permettre les accès en fonction du niveau de conformité de l’équipement ;

- Unified Access Gateway permettra l’accès distant aux services hébergés en interne, par l’intermédiaire de services VPN ou Reverse Proxy limité aux applications désignées comme éligible par UEM lors de leur installation.

Le lien entre la gestion de flotte et la gestion des identités est un constituant clé d’un scénario Zero Trust.

Authentification forte

On le sait bien, une sécurité contraignante pour les utilisateurs peut être contre-productive et peut induire des comportements compromettants. Aussi, les mécanismes d’authentification doivent répondre à deux critères :

- être suffisamment résistants aux attaques ;

- être suffisamment simples à utiliser, et aider l’utilisateur davantage que le contraindre.

Aussi, l’authentification unique est essentielle à la réussite d’un scénario Zero Trust.

Une authentification forte s’entend par le recours à des mécanismes suffisamment solides au regard du niveau de risque et par l’association de multiples facteurs, d’au moins deux types différents, afin de complexifier la tâche des attaquants.

Les facteurs sont classés en trois catégories :

- ce que l’on connaît, tel un mot de passe, un code PIN, etc. ;

- ce que l’on possède, tel un terminal, une carte à puce, etc. ;

- et ce que l’on est, c’est la biométrie (empreinte digitale, reconnaissance faciale, etc.).

Partant de là, nous pouvons combiner différents facteurs en piochant dans ces catégories. Dans un scénario Zero Trust, nous utilisons principalement les facteurs suivants :

- le mot de passe local du terminal (c’est-à-dire qui n’existe et ne puisse être utilisé que sur le terminal en question), typiquement le mot de passe de la session utilisateur sur les systèmes d’exploitation historiques et les codes PIN sur les tablettes et smartphones ;

- les clés physiques pour les protocoles PIV ou FIDO2, ces jetons étant protégés par code PIN ;

- la biométrie enclavée (qui a l’avantage de poser moins de problèmes éthiques et de réduire le risque de fuite de donnée sensible), telle que Apple FaceID et TouchID, Windows Hello.

Quid des mots de passe des comptes de l’entreprise ? Ils tendent à disparaître, d’où l’authentification Passwordless, qui sous-entend en réalité : sans invite de mot de passe sur un service en ligne. Autrement dit, il s’agit de supprimer tout mot de passe exposé aux risques d’écoutes du trafic, d’attaque par force brute à distance (et potentiellement distribuée). À la place, nous privilégions les authentifications par certificats vérifiables et révocables ou par jetons FIDO2 enrôlés dans l’IdP, pour les accès en ligne. Les terminaux quant à eux sont protégés par mot de passe ou code PIN, ceux-ci n’existant que sur le terminal. Si les exigences de sécurités sont plus fortes, l’accès aux terminaux peut également être protégé par PIV.

Précisons le cas des terminaux, car c’est un point important dans notre scénario. En effet, protégé par un mot de passe local, non extractible et qui ne peut être testé que localement, le déverrouillage du terminal implique alors, de fait, une authentification à deux facteurs. L’utilisateur doit connaitre son mot de passe et être en possession de son appareil. S’il manque l’un ou l’autre, l’accès n’est pas possible. Ces mots de passe et codes PIN répondent à des critères de force définis par la politique de sécurité, mais n’expirent pas.

Ceci nous permet de transiter au point suivant : l’authentification par certificat des accès sur les outils en ligne (comptes email et calendriers, applications Web, etc.). La solution technique utilisée par Workspace ONE Access diffère d’une plateforme à l’autre, car VMware a tiré parti au mieux des capacités et limites de chacune. Cependant, l’idée générale est de profiter du niveau de confiance que nous pouvons accorder au terminal, du fait que sa conformité est maintenue et contrôlée, et que son accès est suffisamment protégé, pour y déployer un certificat d’authentification unique. Afin de le protéger, ce certificat :

- est délivré par l’autorité de certification de l’entreprise, par l’intermédiaire de WS1 UEM ;

- a sa clé privée générée sur le terminal, qui est ensuite transférée à la PKI via WS1 UEM ;

- est lié à l’identité de l’utilisateur (dont il porte l’identifiant) et à la machine (dont il porte l’UDID).

Pour finir, une fois généré par la PKI, le certificat est délivré via WS1 UEM au terminal. L’usage de ce certificat diffère en fonction de la plateforme :

- macOS, Windows et Chrome OS feront de l’authentification web par certificat ;

- iOS et iPadOS feront du Kerberos avec PK-INIT ;

- Android utilisera le VMware Tunnel.

Dans cette configuration, on a donc une authentification en ligne par certificat, sans mot de passe transitant sur le réseau. Ceci assure un mécanisme plus fort qu’un mot de passe d’utilisateur de l’annuaire et équivalent à une carte à puce pour l’authentification en ligne, car dans les deux cas, nous combinons deux facteurs :

- ce que l’utilisateur possède (son terminal dans un cas, sa carte à puce dans l’autre) ;

- ce qu’il connaît (le mot de passe de son terminal, ou le code PIN de la carte à puce).

On voit bien ici l’importance de l’intégration forte entre la solution de gestion de flotte (MDM ou UEM), et le fournisseur d’identités.

Cependant, il est important de prendre en compte que ce certificat d’authentification est constamment présent sur la machine. Aussi, par exemple si un utilisateur laissait son terminal déverrouillé et sans surveillance, un attaquant pourrait en profiter pour accéder à une application de l’entreprise, ainsi qu’aux données qu’elle contient. Pour prévenir ce risque, d’une part la machine doit être suffisamment protégée (mot de passe obligatoire, mais aussi un délai de verrouillage assez court). D’autre part, l’accès aux ressources les plus sensibles doit avoir recours à une vérification de présence, qui peut se faire par une notification sur un terminal de confiance, ou avec une clé FIDO2 (protégée par code PIN).

Déploiement ZeroTouch et Passwordless

Dans le cas d’un déploiement ZeroTouch, il est nécessaire d’authentifier l’utilisateur déballant la machine pour permettre au MDM de la personnaliser pour son usage. Cette authentification en situation Passwordless sera différente en fonction de la plateforme.

L’option la plus simple est de reposer sur l’authentification FIDO2, celle-ci n’est cependant possible en phase de déploiement que pour les Chrome OS et les Windows.

La solution viable pour l’ensemble des plateformes consiste aujourd’hui à reposer sur un code à usage unique fourni par l’équipe informatique ou obtenu depuis un terminal de confiance déjà dans les mains de l’utilisateur. Ce code valable un temps limité et donnant un droit d’enrôlement pour une seule machine permettra d’authentifier l’utilisateur et de personnaliser le poste pour son usage. Dès lors et une fois la machine conforme à la stratégie d’entreprise, il sera possible d’y distribuer un certificat de sécurité.

Complexité et risques

Dans ce genre d’architecture, il y a deux risques principaux :

- la complexité ;

- l’IDP.

Concernant la complexité, il est aujourd’hui impératif de maîtriser un nombre de systèmes grandissant, dont une part de l’exploitation est assurée par l’utilisateur final, et dont les capacités de déploiement et d’authentification varient. Pallier ce risque implique des équipes informatiques ayant accès régulièrement à de la formation afin de rester à la page, et convenablement dimensionnées pour supporter l’ensemble des plateformes et services nécessaires.

Et pour l’IDP, comme l’Active Directory, c’est une source d’authentification pour les services. Le compromettre met en danger l’ensemble des services de l’entreprise. Sauf que celui-ci devra être accessible à distance. Une manière adaptée de réduire l’exposition de l’IDP s’il est hébergé par l’entreprise, c’est de le placer derrière une Access Proxy ou un VPN pouvant authentifier les clients par certificat uniquement. Ce certificat pouvant se trouver sur la clé FIDO2 pour celles disposant des fonctions PIV s’il est nécessaire de supporter les terminaux personnels non gérés.

La sécurité du MDM est également un sujet, celui-ci devant obligatoirement être accessible à distance pour enrôler et gérer les terminaux, il sera nécessaire d’auditer régulièrement son fonctionnement, sa liste de terminaux enrôlés, et les certificats émis par son intermédiaire pour s’assurer qu’aucun accès illégitime n’existe.

Conclusion

D’une sécurité périmétrique nous passons à une sécurité par de multiples couches et une séparation des rôles d’identité (annuaire), d’authentification (IDP et MDM), d’autorisation (annuaire, IDP et MDM) et de maintient en condition opérationnelle des terminaux (MDM) dans une situation ou tout est accessible à distance avec ou sans Reverse Proxy ou VPN par application pour limiter les tentatives de piratages en ligne. D’autre part, certaines responsabilités préalablement inhérentes à l’équipe informatique deviennent celles des utilisateurs finaux : le déballage et l’activation initiale des machines. Ce qui impliquera aussi des problèmes humains à gérer.

Si cette architecture est aujourd’hui devenue incontournable pour répondre aux attentes de notre temps, elle n’en reste pas moins complexe et impose avant tout une formation complète des équipes. Ce n’est pas une évolution du passé, ce n’est pas une simple montée de version d’un Active Directory ou de stations de travail. C’est une vision totalement différente, où les rôles humains et techniques sont redistribués, et où la connaissance des fondamentaux inhérents à cette architecture est capitale à toute réussite et difficile à obtenir par itération depuis les architectures passées.