Les biais du recrutement augmenté à l’IA : ce qu’il faut savoir

Les biais et la discrimination peuvent s’insinuer à presque toutes les étapes de votre processus de recrutement. Voici quelques points de vigilance et conseils pour en limiter l’impact.

Côté pile, les outils de recrutement s’appuyant sur l’intelligence artificielle (IA) allègent considérablement la charge des équipes RH en automatisant presque chaque étape du processus.

Côté face, ils amplifient les biais de jugement inhérents à l’encontre de « groupes de personnes protégées » qui peuvent être sous-représentées dans l’entreprise.

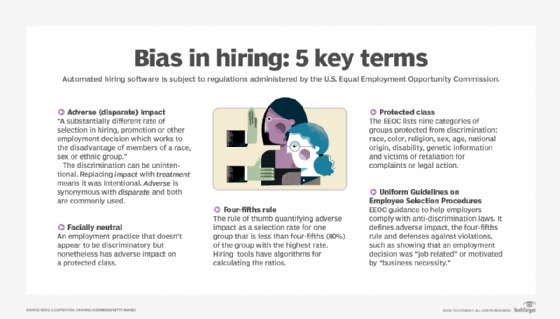

Aux États-Unis et au Canada, les groupes protégés désignent les personnes pouvant faire l’objet de « motif de distinction illicite », en clair de discrimination à l’embauche – au sens de l’article L1132-1 du Code du travail français.

Dans le recrutement, ces biais risquent également de diminuer le vivier de candidats et de pousser les entreprises à la faute en matière de conformité réglementaire.

Pionnier dans le domaine, Amazon a introduit l’IA dans son processus de recrutement dès 2018. Malgré des efforts louables visant à supprimer les informations sur les groupes protégés, le programme a dû être abandonné après la découverte de biais dans les recommandations d’embauche.

Qu’est-ce qu’un biais en IA et quel est son impact sur le recrutement ?

En intelligence artificielle, un biais désigne tout mécanisme par lequel les outils d’IA et d’analytique perpétuent ou amplifient des discriminations. Ils peuvent prendre diverses formes, mais le plus courant consiste à augmenter un ratio sur la base de critères tels que le sexe, l’origine nationale, la religion ou l’orientation sexuelle.

Il peut s’agir également de différences dans les offres d’emploi, qui accentuent les disparités de revenus entre différents groupes. En cause la plupart du temps, les données historiques utilisées pour entraîner les algorithmes. Même si, humainement, tout est fait pour ignorer des différences précises, l’IA n’en reste pas moins entraînée involontairement sur des biais dissimulés dans les données.

« Tous les systèmes qui impliquent des êtres humains sont biaisés d’une façon ou d’une autre, car les biais concernent tous les individus », explique Donncha Carroll, associé du département Revenue Growth d’Axiom Consulting Partners chez qui il dirige le centre d’excellence en data science. « Chaque décision que nous prenons dépend de ce que nous voyons, de nos observations et de notre perception du monde à venir. Les algorithmes étant entraînés sur des données, si le jugement humain se mêle à l’historique, le risque est réel d’inscrire le biais dans l’algorithme lui-même. »

La conception même de l’algorithme peut être biaisée, tout comme la façon dont nous interprétons les résultats de l’IA. Parfois, le biais peut découler de l’ajout d’éléments de données, par exemple des revenus, associés à des résultats faussés ou des données peu pertinentes concernant des membres de groupes protégés qui tirent leur épingle du jeu.

IA : quels sont les types de biais dans le recrutement ?

Sourcing, screening, sélection, offre… les biais peuvent être introduits à toutes les phases du recrutement.

Prenons la phase du sourcing : les recruteurs peuvent s’appuyer sur l’IA pour décider où et comment publier leurs offres. Or certains sites, en ciblant des groupes spécifiques, ajoutent des biais au vivier de candidats potentiels. L’IA peut également recommander des tournures pour rédiger les offres d’emploi, au risque d’encourager ou de décourager certains groupes. Si une application de sourcing relève que des recruteurs privilégient telle ou telle plateforme pour contacter des candidats, elle peut y publier plus d’offres, amplifiant ainsi le biais des recruteurs. Les RH aussi peuvent involontairement employer des termes connotés (« ambitieux », « leader »…), qui parlent plus à des groupes privilégiés.

Dans la phase de screening, les solutions d’analytique de CV ou les applications de chat peuvent utiliser certaines informations pour écarter des candidats potentiels, par ailleurs associés indirectement à une classe protégée. Elles peuvent rechercher des caractéristiques que l’algorithme associe à la productivité ou la réussite, par exemple des périodes sans emploi. D’autres outils analysent la prestation vidéo des candidats en entretien, au risque d’amplifier le biais à l’encontre de certains groupes culturels. Quelques exemples : des sports plus souvent pratiqués par un des deux sexes ou une population d’origine nationale donnée, des activités extrascolaires plus fréquentes dans les classes aisées…

En phase de sélection, les algorithmes peuvent recommander certains candidats en particulier, en s’appuyant sur des métriques elles aussi biaisées.

Lorsqu’un candidat a été sélectionné, l’entreprise doit lui faire une offre. Les algorithmes peuvent analyser les fonctions précédentes du candidat pour faire une offre susceptible d’être acceptée. Ces outils peuvent amplifier des disparités existantes dans les salaires de début et de fin de carrière suivant le sexe, l’origine nationale, etc.

Les cadres législatifs et gouvernementaux aux États-Unis

Aux États-Unis, les organisations gouvernementales ou fédérales telles que la Commission américaine pour l’égalité des chances en matière d’emploi (EEOC) font de la sanction par la loi des biais délibérés un objectif essentiel. Des statistiques récentes de l’EEOC indiquent un taux d’inemploi largement plus élevé chez les Noirs, les Asiatiques et les Hispaniques que chez les Blancs. L’organisation relève par ailleurs que le chômage est de plus longue durée chez les 55 ans et plus. En France, les statistiques ethniques sont en principe interdites, mais pas les statistiques sur l’immigration, comme le prouve une étude sur les origines des salariés publiée par l’INSEE.

En 2021, l’EEOC et le ministère de la Justice américain ont émis des recommandations pour venir en aide aux entreprises désireuses de limiter les biais du recrutement par l’IA. Ils suggéraient, entre autres, de s’intéresser aux moyens d’entraîner l’IA à ignorer les variables qui n’ont pas d’incidence sur les performances professionnelles et soulignaient que l’intelligence artificielle – malgré toutes les précautions – pouvait être source de problèmes. Ces précautions sont importantes, car les entreprises peuvent être rappelées à l’ordre lorsqu’elles utilisent l’IA sans supervision pour le recrutement.

Charlotte Burrows, présidente de l’EEOC, recommande aux entreprises – pour valider l’utilisation d’un logiciel de recrutement par IA – de le mettre à l’épreuve, de pratiquer des audits et de poser toutes les questions utiles.

Biais de recrutement avec l’IA : 4 solutions pour les limiter

Voici les principaux moyens de limiter les biais de l’IA pour le recrutement.

1. Garder des humains dans la boucle

Associé du département des pratiques analytiques de Kearney, cabinet mondial de conseil en gestion et stratégie, Pratik Agrawal recommande de ne pas tout miser sur un moteur d’IA et de garder des humains dans la boucle. Les recruteurs peuvent, par exemple, définir une procédure qui équilibre les différentes catégories de CV introduits dans le moteur d’IA. Autre conseil, non moins important : l’examen manuel des recommandations. « Présentez sans cesse différentes catégories de CV au moteur d’IA pour éviter d’ajouter des biais, inévitables sans supervision des données qui l’alimentent », conclut-il.

2. Exclure les éléments de données biaisés

Identifiez absolument les éléments de données qui introduisent des biais inhérents dans le modèle. « Ce n’est pas une mince affaire », insiste Donncha Carroll. « Soyez particulièrement vigilants au moment de la sélection des données et des fonctionnalités qui seront intégrées au modèle d’IA. » Lorsque vous envisagez d’ajouter une variable, demandez-vous si ce pattern a tendance à être plus ou moins important dans une classe protégée ou chez un type de collaborateurs protégés, sans que cela ait un lien avec les performances. Ce n’est pas parce que les joueurs d’échecs font de bons programmeurs qu’il faut penser à l’inverse que les non-joueurs sont dénués des qualités requises pour la programmation, par exemple.

3. Mettre l’accent sur les personnes habituellement ciblées par la discrimination

Veillez à pondérer la représentation de groupes protégés qui peuvent être actuellement sous-représentés au sein du personnel. « Vous éviterez ainsi de coder des patterns dans le modèle d’IA, qui perpétuent ce qui a été fait jusqu’à présent », affirme Donncha Carroll. Ce dernier a collaboré avec un client persuadé qu’un diplôme était un indicateur de réussite essentiel. Après avoir supprimé cette contrainte, le client a découvert que les employés non diplômés étaient non seulement plus performants, mais restaient plus longtemps.

4. Mesurer la réussite

Prenez le temps de cerner ce qui est qualifié de réussite dans chaque rôle et développez des résultats tels qu’un rendement plus élevé ou des reprises moindres, qui sont moins soumis aux biais humains. La diversité des approches permet d’éliminer les biais qui peuvent être inscrits dans des mesures telles que l’évaluation des performances. Changer d’angle permet de faire poindre des caractéristiques à rechercher lors du recrutement.