Getty Images/iStockphoto

Comment l’infrastructure composable et le stockage intelligent se combineront

L’infrastructure composable et le stockage intelligent sont les deux prochaines tendances dans les datacenters. Cet article explique de quoi il en retourne et comment ces technologies pourraient fonctionner ensemble.

Deux nouvelles tendances technologiques pointent leur nez dans les datacenters : les infrastructures composables et le stockage intelligent. De prime abord, ces deux concepts semblent opposés : l’infrastructure composable consiste à partager, sur un réseau PCIe 5.0, les CPUs, GPUs, RAM et SSD NVMe entre différents serveurs, alors que le stockage intelligent consiste à ramener du calcul sur les disques pour éviter de charger les serveurs. Pour autant, les analystes estiment que les entreprises utiliseront bientôt les deux.

Le stockage intelligent pour soulager les serveurs

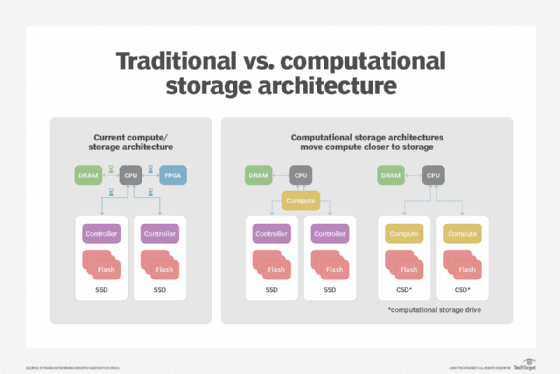

Le stockage intelligent est une technologie relativement nouvelle dans laquelle une unité centrale et une mémoire sont placées à l’intérieur d’un SSD ou à proximité du matériel de stockage. Les entreprises peuvent effectuer certaines tâches au niveau du stockage plutôt que de solliciter l’unité centrale du système.

Le stockage intelligent est pour l’heure porté par des startups comme Fungible, SmartIOPS et ScaleFlux. Leur promesse est de réduire les temps de latence grâce à des puces accélératrices qui exécutent elles-mêmes une grande partie des traitements liés au stockage. Pour l’heure, il s’agit de fonctions de bas niveau, comme la compression, l’optimisation ou la déduplication des données.

Demain, les SSD pourraient intégrer des fonctions d’analyse (d’images, de sons…) pour trier les seules données utiles à un serveur applicatif. Le chiffrement des données et le traitement vidéo sont de bons candidats pour le stockage intelligent. Mieux, certains fournisseurs planchent sur l’exécution d’un système d’exploitation complet au niveau du stockage.

Les infrastructures composables pour succéder à l’hyperconvergence

L’infrastructure composable remonte aux efforts d’élasticité des fabricants de serveurs. Jusqu’ici, il s’agit d’assembler des machines en cluster – ayant leurs propres caractéristiques de calcul et de stockage – et de répartir les applications sur chacune d’elles selon leurs ressources disponibles. C’est le principe de la virtualisation. Quand des ressources de calcul ou de stockage viennent à manquer, il suffit d’ajouter d’autres machines au cluster. C’est le principe des infrastructures hyperconvergées.

Pour autant, les infrastructures hyperconvergées ont un défaut : tous les nœuds serveur d’un cluster doivent avoir les mêmes caractéristiques. Et qu’importe qu’un projet nécessite seulement plus de calcul ou seulement plus de stockage, il faudra acheter les deux, puisqu’un nœud apporte à chaque fois une certaine quantité de puissance de calcul et une certaine quantité de capacité de stockage.

Cela met en lumière un autre défaut : la granularité. Une application qui a besoin de beaucoup de mémoire ne pourra pas en obtenir plus que celle offerte par un nœud. Par ailleurs, il peut rester sur chaque nœud une puissance de calcul résiduelle (quelques cœurs de CPU, de la RAM…) qui n’est jamais utilisée, car elle n’est suffisante pour aucune des applications en cours d’exploitation.

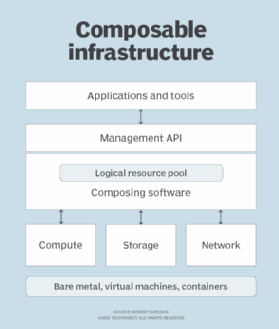

Dans une infrastructure composable, le problème de la granularité disparaît. Les applications peuvent aller chercher des cœurs, de la RAM, des GPUs et des SSDs NVMe partout dans le cluster. Cette agilité est d’autant plus intéressante que les applications modernes sont développées à présent sous la forme de containers qui s’activent ou disparaissent très souvent, au gré des fluctuations les plus infimes de l’activité.

Les environnements d’infrastructure composables regroupent des ressources telles que le calcul, la mémoire, l’équipement réseau et le stockage. Il n’est pas nécessaire que ces composants résident tous dans le même système. Les environnements d’infrastructure composable peuvent évoluer horizontalement : les ressources des nœuds nouvellement ajoutés sont simplement ajoutées au pool. Les ressources étant désagrégées de cette manière, les nœuds doivent être reliés entre eux par des interconnexions haut débit.

Ces interconnexions haut débit vont se concrétiser avec l’arrivée des architectures CXL, lesquelles reviennent à des réseaux de bus PCIe 5.0. Pour l’heure, c’est la startup Liqid qui implémente la première ce concept.

Comment utiliser les deux conjointement ?

L’infrastructure composable et le stockage intelligent présentent des différences essentielles. Alors que l’infrastructure composable dépend d’une structure à haut débit entre les composants de l’infrastructure, le stockage intelligent s’en passe, car la mémoire et les cœurs de calcul se trouvent dans l’unité de stockage.

Les systèmes d’infrastructure composable sont pratiques, en particulier pour les entreprises dont les charges de travail sont imprévisibles et qui ont besoin de flexibilité. Cependant, ils ne sont pas sans poser de problèmes. La nature de l’infrastructure composable implique un temps de latence supplémentaire.

À l’inverse, le stockage intelligent place les ressources de mémoire, de stockage et d’unité centrale en un seul endroit afin d’éviter une latence excessive. Pour autant, il pose le même problème de granularité que les infrastructures hyperconvergées.

Compléter une infrastructure composable par du stockage intelligent permet dès lors d’exécuter ensemble des applications peu sensibles à la latence, avec une grande flexibilité dans l’économie des ressources, et des charges de travail qui ne supportent aucun ralentissement. En définitive, l’exploitation des ressources matérielles est optimisée à son maximum. Les gains comprendront une réduction de la surface au sol occupée par les équipements et une baisse de la consommation d’énergie par rapport à des clusters standards.