Business Intelligence : pas de crise et beaucoup d’avenir

Toujours porteuse en dépit de la crise, la Business Intelligence apparaît même comme une aide pour faire face à la crise. Temps réel, prédictabilité : la pression est forte côté utilisateurs pour trouver, dans les outils décisionnels, le moyen de freiner la chute, de piloter l’atterrissage voir d’anticiper le rebond. Résultat : un segment dont la consolidation faisait craindre la dissolution s’avère l’un des plus dynamiques côté applications.

En dépit de la crise économique et de la consolidation particulièrement forte de ce segment de marché depuis 18 mois, la Business Intelligence devrait sortir par le haut de l’année 2009. Tout à leur effort d’intégration, les gros du secteur – parmi lesquels seul SAS demeure un acteur indépendant, mais plutôt discret ces derniers temps – ont finalement laissé nombre d’opportunités se créer pour de nouveaux entrants, là où de nombreux analystes craignaient l’émergence d’un oligopole. Les acteurs open source tentent d’en profiter d’autant plus que, sur le marché des PME, Microsoft a décidé d’abandonner le terrain. De fait, les « petits acteurs » représentent toujours un quart d’une activité florissante.

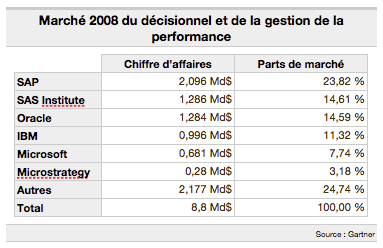

Avec près de 21% de croissance en 2008 selon Gartner : les marchés du décisionnel et des outils de gestion de la performance n’ont pas vraiment pâti du début de la crise – qui a éclaté à la fin de l’été 2008 – en générant 8,8 milliards de dollars de chiffre d'affaires pour des éditeurs spécialisés dont les plus gros ont attisé la gourmandise des géants du secteur. Selon Gartner, la kyrielle de rachats n’a pas freiné la progression du marché, en dépit des inévitables changements organisationnels et la rationalisation des gammes de produits. Au contraire, les acquéreurs aux vastes bases installées ont fait feu de tout bois, commercialement, pour proposer à leurs clients de basculer vers leurs plate-formes BI tout juste acquises. De quoi doper un secteur déjà fortement croissant.

Mais la révolution n’est pas seulement économique ou dans l’identité des acteurs. Vues comme une solution ou tout du moins une aide dans la gestion de la crise, les applications décisionnelles sont à l’orée de modifications profondes : déclinaison sur toutes les fonctions de l’entreprise ; évolution toujours plus poussée des outils de prédiction ; demande des clients pour des applications en temps réel ; convergence avec des applications venues du domaine des moteurs de recherche (le search dans le jargon des éditeurs) : les années à venir devraient confirmer et accentuer la bonne tenue actuelle. Et voir la BI jouer le rôle de commodité incontournable de la décision en entreprise.

En témoignent, dans la vidéo ci-dessous, les regards croisés d’un utilisateur conquis et d’un fournisseur qui trace la roadmap à venir. Des choix de solutions et une vision d’avenir que nous avons essayé de mettre en perspective dans ce dossier en présentant quelques nouveaux entrants, en faisant l’état des lieux pour quelques acteurs de la consolidation et en fixant les orientations pour 2010 et 2011.

Diplômé de l'Ecole Centrale de Paris et de l'University of Southern California, Patrice Bertrand entame sa carrière chez Capgemini, où il est successivement développeur, chef de projet puis directeur de projet. En 1994, il rejoint Smile et devient directeur des opérations en 2002. A partir de janvier 2007, il est directeur général, en charge de la stratégie, de la communication, du marketing et de la veille technologique, en continuant à participer à l'action d'avant-vente.

Diplômé de l'Ecole Centrale de Paris et de l'University of Southern California, Patrice Bertrand entame sa carrière chez Capgemini, où il est successivement développeur, chef de projet puis directeur de projet. En 1994, il rejoint Smile et devient directeur des opérations en 2002. A partir de janvier 2007, il est directeur général, en charge de la stratégie, de la communication, du marketing et de la veille technologique, en continuant à participer à l'action d'avant-vente.

Les annonces se multiplient autour de produits Open Source liés au décisionnel. Où en est-on réellement de la maturité de l’offre ?

On est au début de l’histoire du décisionnel en Open Source. Chez Smile, on a l’habitude d’avancer sur les solutions en fonction de la maturité de l’offre. Et aujourd’hui, on voit émerger des cycles de maturation des applications dans un grand nombre de domaines. Si on prend l’exemple de la gestion de contenu, il y a eu une émergence des solutions en 2001 et jusqu’en 2005, on a monté la pente. L’heure est venue du démarrage sur d’autres briques comme le décisionnel.

L’Open Source fonctionne d’abord sur de petits projets. Pour la BI, on avait donc jusqu’à peu de nombreux composants de la chaîne décisionnelle avec un gros historique de développement, mais également avec un trop gros besoin d’intégration pour présenter une offre complète. L’élément déclencheur pour conquérir un marché plus vaste, c’est la mise en suite autour de deux acteurs Open Source principaux : Pentaho et Spago BI.

Le segment du décisionnel a connu une concentration sans précédent en 2007. Les plus gros acteurs ont intégré des groupes plus importants et plus généralistes en terme d’offres. Ce mouvement représente-t-il une opportunité pour le décisionnel Open Source ?

En fait, nous sommes toujours challenger. Le vrai problème pour les gros fournisseurs, ce n’est pas tant les grands comptes qui sont largement équipés et qui, ayant mis du temps à déployer les solutions, ne reviennent pas vraiment sur leur choix, que les PME. Pour ces dernières, il y a un gros volume de données à traiter et de petits budgets. Du coup, les acteurs Open Source ont une carte à jouer. Tout comme dans des projets spécifiques au sein de grands comptes. Certes, ces derniers ont déjà une solution à l’échelle corporate mais avec un nombre de licences limité. Dès lors qu’il faut payer de nouveau, les challengers sont écoutés.

Mais au final, la concentration sert l’Open Source surtout parce qu’elle crédibilise des acteurs tels que Spago BI et Pentaho qui offrent une solution globale.

La France apparaît comme un eldorado, tant pour l’Open Source que pour le BI comme en témoigne les arrivées récentes sur le marché de Jedox et de Jaspersoft, avec l’ouverture d’un bureau parisien. Vous le ressentez à votre niveau ?

En Open Source, c’est vrai que l’on peut dire que la France à une longueur d’avance en matière d’applicatifs, donc c’est également vrai pour le décisionnel. Mais le paradoxe, c’est que si on est en avance dans l’adoption ce n’est pas vraiment le cas dans l’édition où l'on ne compte pour l’instant que Nuxeo, dans la gestion de contenu, et Talend, dans le décisionnel, comme éditeurs d’envergure.

Pour ce qui est du BI, il est vrai que la France est la patrie d’origine de BO qui demeure très fort localement même depuis son rachat par SAP. Cela crée certainement un marché particulier.

La France est-elle l'eldorado rêvé pour les éditeurs de solutions décisionnelles ? Terre d'origine de Business Objects – longtemps leader du secteur avant que la consolidation très forte dans le top 5 ne vienne le pousser dans les bras de l'allemand SAP – la France accueille depuis quelques semaines trois éditeurs supplémentaires. Tous venus faire leur trou sur un marché fraîchement recomposé et où l'Open Source joue les alternatives.

De fait, deux des nouveaux venus se réclament du monde libre. Jaspersoft – le premier – en est même le fer de lance dans la Business intelligence. Et s'il est déjà commercialisé dans l'Hexagone, l'ouverture d'un premier bureau parisien devrait permettre un développement plus important encore. Open Source toujours avec l'Allemand Jedox – spécialiste de l’analyse à partir de consolidation et d'exploitation de données Excel – qui tente lui aussi une percée. Logique propriétaire, mais puissante enfin avec l'Italien Tagetik, l'un des leaders transalpin, qui compte bien profiter des déçus de la consolidation en jouant sa carte de spécialiste. Surtout que le marché est florissant. Le cap des 2 milliards d’euros de CA réalisé par les éditeurs d’outils décisionnels devrait être franchi en 2009, selon Pierre Audoin Consultants qui livrait au mois de juin sa première étude post-concentration.

Pour Dominique Donné, patron de Jedox pour l'Hexagone, « la France est un marché très dynamique pour la BI mais surtout pour tous les outils Open Source. En Allemagne, d’où vient Jedox, les entreprises ont beaucoup plus peur et se tournent plutôt vers de grosses marques installées, quitte à payer plus cher ». Un argument récurrent qui nous faisait titrer il y a quelques semaines à peine « Open Source : la leçon française à l’Amérique ».

Pour Jedox la France est ainsi la première destination hors Allemagne, mais était déjà dans la tête des concepteurs avant même leur marché historique. « Pour nous, c’était la priorité même si l’on songe à ouvrir d’autres bureaux à Londres ou dans le Nord des Etats-Unis par exemple », précise Dominique Donné. Comme nombre d’éditeurs Open Source, Jedox compte tout à la fois sur un réseau de partenaires intégrateurs – au premier rang desquels la SSII Smile – et sur ses propres services pour se développer. « Difficile de savoir quel est notre niveau d’implantation car le module de base de Palo (l’outil développé par Jedox) est bien sûr gratuit. Mais ce qui est sûr, c’est que notre site web reçoit un trafic très important en provenance de la France ».

Mêmes causes, mêmes effets pour Jaspersoft qui vient de prendre la décision d’ouvrir une filiale à Paris. Une manière de répondre à la demande française croissante pour l’éditeur leader du décisionnel en Open Source. Un éditeur pourtant déjà installé en Europe avec des bureaux en Irlande, en Italie, en Roumanie et en Ukraine. Jaspersoft est d’autant plus avancé que de spécialiste du reporting, il a basculé vers la plate-forme de BI avec Jasper Intelligence.

Selon Jaspersoft, « l’équipe est aujourd’hui constituée d’ingénieurs, de commerciaux, de professionnels du marketing, du support technique et du conseil ». Au cours des douze derniers mois, les effectifs de Jaspersoft en Europe ont plus que doublé. Brian Gentile, PDG de l’éditeur, explique que « l’Europe continue d’être le continent où nous enregistrons le nombre de téléchargements le plus élevé ». Et d’ajouter que « dans l’univers des logiciels Open Source, le marché européen a toujours fait figure de pionnier, notamment dans les administrations et les universités. Une tendance qui gagne également d’autres segments de marché, et notamment les moyennes et grandes entreprises. »

Pour l'Italien Tagetik, seul éditeur parmi les trois nouveaux venus à jouer la carte du propriétaire, le choix d’ouvrir une filiale en France n’est pas non plus neutre. Spécialiste de la consolidation financière, l’éditeur est présent dans de nombreux pays européens au travers de revendeurs-intégrateurs. Mais, là encore, la France a visiblement constitué une opportunité spécifique en terme de développement. Même si la dimension propriétaire du produit peut donner le sentiment de « déjà vu » en terme de choix économique. Tout en faisant également craindre le spectre du rachat à une clientèle utilisatrice peut-être échaudée par la vague de 2007 qui a vu la plupart des éditeurs spécialisés se faire avaler par les mastodontes du secteur.

Début 2009, Arrow Génériques – filiale française du spécialiste de la production de médicaments génériques Arrow Generics – s’est mis en quête d’un outil décisionnel susceptible d’accompagner sa croissance et surtout ses besoins en termes de prévisions budgétaires. Après une procédure de présélection durant laquelle le groupe lyonnais s’est appuyé sur un groupe de conseil spécialisé, trois solutions se sont dégagées : le choix d’un grand nom de la BI, un développement spécifique en s’appuyant sur une SSII ou enfin un nouvel entrant, plus petit mais remplissant pleinement le cahier des charges. Cette dernière option l’a finalement emportée et l’italien Tagetik a été choisi.

Un premier projet décisionnel

Arrow Génériques en bref

Activité : industrie pharmaceutique ; filiale française d’Arrow Generics ,spécialiste de la production de médicaments génériques avec trois usines (Canada, Malte, Brésil)

Nombre de salariés : 130 en France ; 1 000 dans le monde dont un quart en R&D

Chiffre d’affaires : 442 millions d’euros en 2008 – 125 millions d’euros en France

Le projet : mise en place d’un module d’analyse prédictive à des fins budgétaires au profit de la DAF.

Yanis Najid, directeur administratif et financier d’Arrow Génériques, s’en félicite et explique que « jusqu’à présent nous n’avions pas d'outil de BI. La plupart des rapports étaient réalisés sur un mode manuel, sous Excel. Une approche qui a vite atteint ses limites puisque nous avions un besoin croissant d’informations, tant en quantité qu’en qualité. Nous cherchions avant tout un outil pour la partie financière et notamment à des fins prévisionnelles. » Un certain nombre de critères de sélection ont été définis.

Yanis Najid – qui a piloté directement le choix – recherchait, pour ses services, « un logiciel souple pouvant s’adapter aux besoins précis de notre organisation, et un outil qui soit également très technique au niveau financier et très orienté autour des métiers de la comptabilité (gestion des charges mais également la production du bilan et sur la gestion de la trésorerie). » Le tout dans une enveloppe précise, inférieure à 100 000 euros.

Au niveau du projet lui-même, « dès le choix établi - fin avril - nous avons attaqué pour un début de chantier en juin. Le cabinet de conseil nous a alloué une personne tandis que les gens de chez Tagetik étaient deux, avec des équipes tournantes tant françaises qu’italiennes mais francophones, donc sans aucune difficulté linguistique particulière. En interne, notre contrôleur de gestion a assuré l’interface et la gestion du projet. »

Une mise en production rapide et concluante

Après avoir travaillé sur le projet durant tout le mois de juillet, Arrow Générique a laissé passer le mois d’août avant de basculer en phase de production début septembre avec un déploiement sur trois postes. Yanis Najid explique avoir « choisi d’aller vite et de tout centraliser sur la DAF avec des données qui transitent systématiquement par une personne afin de garder la main sur l’outil. » Un projet et un objectif très orientés métier donc, sur lequel la direction informatique n’est pas intervenue. Selon Yanis Najid, chez Arrow Génériques, l’équipe informatique « est surtout concentrée sur la gestion du parc et le support. Le choix a été de se concentrer à 100% sur le besoin fonctionnel et la DSI n’est intervenue ni à ce niveau ni dans le déploiement »

Une option qui a permis de mettre très rapidement en œuvre la solution tout en s’assurant qu’elle serait opérationnelle dès l’automne, pour répondre aux besoins en matière de préparation du budget 2010. Yanis Najid affirme que « sur le budget 2010 – en cours de constitution – on devrait diviser par deux le temps nécessaire à y consacrer. Le processus prévisionnel est donc plus court et plus fiable et on va pouvoir multiplier les points intermédiaires. »

Une offre taillée pour répondre aux défis des entreprises en temps de crise. C'est ainsi que Jim Hagemann Snabe (en photo), membre du conseil d'administration de SAP, présente Business Suite 7, qui recouvre de nouvelles versions des modules de la suite maison (ERP, CRM, SRM, SCM, PLM). Sous le capot, un accès aux innovations de la firme à un coût moindre et avec moins d'efforts d'implémentation, a martelé Jim Hagemann Snabe.

Fondamentalement, selon le dirigeant, Business Suite 7 est une librairie de processus métier - une trentaine au total - couvrant de bout en bout une problématique business, et faisant appel aux différents modules du PGI. Le tout avec une interface unifiée. L'éditeur met par exemple en lumière des scénarios autour du design de produits (remontant jusqu'aux aspects supply chain notamment), de la gestion de chaînes de magasins (allant de tableaux de bord, aux opérations en magasins, au pricing, à la gestion des assortiments ou aux RH), de la gestion collaborative de la supply chain ou de la gestion des achats.

Fondamentalement, selon le dirigeant, Business Suite 7 est une librairie de processus métier - une trentaine au total - couvrant de bout en bout une problématique business, et faisant appel aux différents modules du PGI. Le tout avec une interface unifiée. L'éditeur met par exemple en lumière des scénarios autour du design de produits (remontant jusqu'aux aspects supply chain notamment), de la gestion de chaînes de magasins (allant de tableaux de bord, aux opérations en magasins, au pricing, à la gestion des assortiments ou aux RH), de la gestion collaborative de la supply chain ou de la gestion des achats.

Du BO enfoui dans Business Suite

Autre évolution notable : ces versions intègrent des outils analytiques. Notamment le fruit du rachat de Business Objects (BO). Même si, précise Jacques Libeyre, directeur des solutions chez SAP France, "nous avions déjà entamé cette transition consistant à combiner vision analytique et fonctions transactionnelles, sur la base de restitutions issues de l'entrepôt de données BW. Le rachat de BO n'a fait qu'accélérer et faciliter ce mouvement".

Dans une interview au MagIT, Hervé Couturier, un ex BO devenu patron de la R&D de la plate-forme d'intégration Netweaver, expliquait en octobre dernier : "on va assister à une fusion du transactionnel et de l'analyse. Demain, un rapport deviendra le point d'entrée d'un système opérationnel. Nous sommes les seuls à être capables de combler ce vide entre la stratégie et l'exécution, car Oracle a séparé ces deux visions dans son organisation." Selon lui, cette fusion amènerait un gain de productivité important aux entreprises. C'est cette tendance qui se dessine dans Business Suite 7, comme le montre la vidéo mise en ligne par SAP détaillant un exemple de gestion opérationnelle d'une chaîne de magasins à partir d'un tableau de bord.

Retour sur investissement : 90 jours maximum, promet SAP

"Business Suite 7 est la combinaison de processus et de fonctions analytiques, mais avec une approche pas à pas. Dans le contexte économique actuel, les entreprises doivent bénéficier d'un retour sur investissement en 90 jours maximum", martèle Jim Hagemann Snabe. "Les grands projets qui promettent seulement une fondation amenant des bénéfices futurs sont trop risqués, trop coûteux et leurs bénéfices sont difficiles à justifier auprès des patrons métier", abonde Jeff Woods, vice-président du cabinet Gartner pour l'ERP et le SCM (supply chain management).

Selon l'Allemand, les innovations de Business Suite 7 seront amenées via des packages de mises à jour (Enhancement package en langage SAP), dans lequel les entreprises peuvent piocher les fonctions qu'elles souhaitent déployer. Seule condition : disposer du coeur ERP 6.0, la dernière version. "Avec la garantie de n'avoir aucune mise à jour lourde pendant 5 ans", ajoute le dirigeant de l'éditeur. Pour passer à Business Suite 7, il faudra ensuite appliquer l'Enhancement Package 4.0, qui sera disponible en avril.

Reste à convaincre la base installée, qui continue à employer largement R/3 ou ECC 5.0, les versions antérieures de l'ERP. Selon les chiffres donnés par l'USF (le club des utilisateurs francophones) lors de sa convention annuelle en novembre dernier, 80 % de la base installée française fonctionne aujourd'hui encore sur une de ces deux versions. Au niveau mondial, 13 000 comptes parmi les 45 000 entreprises sous SAP ont effectué leur migration vers la dernière version de l'ERP. L'annonce peut aussi être interprétée comme une façon pour l'Allemand de se déployer plus largement sur sa base installée, en termes de couverture fonctionnelle. "Avec l'intégration naturelle entre les modules, nous pouvons espérer reprendre des positions à des acteurs de niche comme Ariba ou Siebel", explique ainsi Jacques Libeyre.

La concrétisation de virages déjà entamés

SAP explique avoir travaillé en amont avec 200 clients, qui testent depuis la fin d'année dernière Business Suite 7. Aucun compte français ne figure dans la liste. L'éditeur s'est également associé à quatre intégrateurs pour assurer le lancement de ce produit clef dans sa stratégie, puisqu'il touche une gamme de produits comptant pour 90 % de son activité : l'américain IBM, les français Capgemini et Atos-Origin et l'indien Wipro.

In fine, l'annonce apparaît surtout comme une formalisation de virages déjà largement pris par SAP. L'approche processus était ainsi présente au coeur de la stratégie Netweaver, le middleware que l'éditeur tente d'imposer depuis plusieurs années. Les Enhancement packages, eux, existaient déjà pour l'ERP. "Cette annonce est la consolidation de l'effort technologique que nous menons depuis des années", résume Jacques Libeyre, de SAP France.

Microsoft et l’Enterprise Performance Management (EPM), c’est fini. L’éditeur de Redmond a surpris tout le monde en annonçant en mars dernier son intention d’arrêter la commercialisation sous forme de produit indépendant de PerformancePoint Server (PPS), dix-sept mois seulement après son lancement en grande pompe. L’outil de reporting et d’analyse devait être l’un des fers de lance de Microsoft dans sa conquête du marché du décisionnel. Las, une vague de concentration plus tard - qui a vu Cognos rallier IBM et BO tomber dans les bras de SAP – et avec une crise à gérer sur les bras, Microsoft a visiblement décidé de réduire ses ambitions.

Un recul significatif malgré l’intégration de PPS à SharePoint

Certes, l’éditeur explique que sa stratégie de BI pour les masses est toujours d’actualité puisque PerformancePoint Server sera présent sous forme de fonctionnalité dans SharePoint Server 2007, la solution de portail de Microsoft. Et d’ajouter que désormais les millions d’utilisateurs de Sharepoint vont en profiter. Mais l’arrêt intempestif de la distribution indépendante signifie tout de même une reculade importante qui coupera durablement l’éditeur des utilisateurs friands d’EPM, au premier rang desquelles les directions financières.

Et ce n’est pas la sortie du Service Pack 3 de PerformancePoint Server 2007, maintenue pour la mi-2009, qui devrait les inciter à poursuivre l’utilisation d’un produit dont la commercialisation s’éteindra le 1er avril prochain. Durant sa courte vie, PerformancePoint Server – dont une partie des fonctions analytiques reposent sur le rachat de Proclarity en 2006 - semblait pourtant avoir marqué des points en dépit d’une marque encore peu connue. Microsoft revendique ainsi une croissance de 188 % du nombre de licences commercialisées entre 2007 et 2008 et des milliers d’entreprises utilisatrices tant en grands comptes (comme Chevron) qu’en PME.

Intégration profitable ou dilution avant abandon ?

Bien insuffisant, selon Madan Sheina et Helena Schwenk, du cabinet d'étude Ovum, qui expliquent qu’indépendamment du contexte, Microsoft a « sous-évalué les efforts nécessaires pour conquérir les utilisateurs d’EPM. Avoir un vaste écosystème de partenaires et mettre en place une équipe commerciale dédiée n’a pas suffi. La société a manqué d’expertise dans le domaine et d’une structure de conseils efficace pour implémenter des solutions EPM ». Du coup, difficile pour l’activité d’être rapidement profitable, le juge de paix indépassable au moment où Microsoft a décidé de sacrifier les produits jugés non rentables.

En France, Laurence Dubrovin, du cabinet CXP, estime dans une note que « Microsoft par cette annonce montre qu’en intégrant PerformancePoint Server dans Sharepoint, il a privilégié les fonctions collaboratives nécessaires à une bonne prise de décision. De plus, le nombre important de clients sur la plate-forme Sharepoint va faire bénéficier des fonctions de BI un nombre très important d’utilisateurs potentiels. Ce dernier point n’est sans doute pas neutre dans la décision de Microsoft.» Et d’expliquer que la Business Intelligence à la sauce Microsoft est toujours bien vivante et « se structure désormais autour de 3 composants majeurs : SQL Server, la plateforme décisionnelle ; SharePoint 2007, la solution de portail d'entreprise et Office Excel, l'outil d'analyse et de gestion ».

Pas si simple pour Madan Sheina et Helena Schwenk pour qui « SharePoint n’est probablement pas un réceptacle viable pour les fonctionnalités de PPS (…) SQL Server étant la solution la plus évidente pour tout se qui concerne l’analyse et le décisionnel ».

Bonne nouvelle pour SAP, moins bonne pour les prix

Côté marché – celui de l’Enterprise Performance Management était évalué à 15,4 milliards de dollars par IDC en 2007 -, aucun doute : le retrait de Microsoft fait l’affaire de ses concurrents directs. Avec 603 millions de dollars de chiffre d’affaires, Microsoft s’octroyait le 5ème rang en 2007, avec 3,9 % de parts de marché mais de belles perspectives de croissance pour un nouvel entrant qui faisait figure d’épouvantail. Pour Brice Thébaud, analyste chez Aurel - BGC Partners, « Microsoft est un petit acteur en terme de parts de marché, mais un gros acteur dans sa capacité de nuisance, notamment concernant les prix ». Du coup, SAP - leader de l’EPM depuis le rachat de BO - devrait être le grand bénéficiaire de ce retrait. Pour Brice Thébaud, « l’activité Enterprise Performance Management représente environ 21 % du CA de SAP depuis l’acquisition de BO et fait partie des rares segments à croître. SAP devrait également pouvoir améliorer ses marges, alors que la pression tarifaire devrait s’atténuer ».

De plus, le portefeuille Business Object est très complet, intégrant également des solutions low-cost, celles qui adresseront le mieux les clients de Microsoft. Selon Brice Thébaud, « il faut se rappeler qu’avant 2006, Microsoft proposait comme outil analytique Crystal Decision, racheté ensuite par BO, lui-même acquis par SAP ». Enfin, pour l’analyste d’Aurel, « les solutions de BI sont susceptibles de mieux résister à cette crise que les solutions « core » de SAP, car l’investissement à réaliser est beaucoup plus faible pour les entreprises et le retour sur investissement plus rapide (moins d’un an généralement) et plus facile à calculer. » Un critère essentiel pour les investissements des DSI en cette période.

Passée relativement inaperçue il y a quelques semaines, l’annonce du lancement d’une division 100% orientée Business Intelligence au sein d’IBM Global Services – la SSII désormais au cœur de l’activité de Big Blue – annonce une évolution majeure. C'est à la fois l'épilogue des rachats du canadien Cognos en 2007 et du français Ilog en 2008 et le révélateur du désir d'IBM de mettre systématiquement les services en pointe de l’offre technologique. La société insiste d’ailleurs sur la dimension « historique » de la réorganisation, affirmant qu’il s’agit « du premier lancement d’une nouvelle ligne de services par IBM Global Business Services depuis la création de cette dernière en 2002, à la suite du rachat des activités de conseils de PricewaterhouseCoopers. »

Selon Fred Balboni, un vétéran d’IBM Global Services qui dirigera au niveau mondial les 4 000 consultants qui seront versés dans Business Analytics and Optimization Services (BAO) - nom de la nouvelle entité –, « les activités d’analyse et d’optimisation vont devenir incontournables dans la manière dont les entreprises seront dirigées et incontournables dans l’ensemble de nos pratiques professionnelles ». Une manière de traduire la vision de Big Blue qui, par l’intermédiaire de Ambuj Goyal, d’IBM Software, expliquait en juin dernier dans nos colonnes que les applicatifs d’entreprise seraient bientôt supplantés en terme d’investissement par les outils de gestion de l’information.

En savoir plus

- Entretien avec Ambuj Goyal, directeur général de l'activité gestion de l'information d’IBM Software

- Entretien avec Wilfried Guerit, IBM Global Services qui explique en quoi les outils BI sont trés complets mais que cela ne suffit pas

Certes, la nouvelle organisation du groupe d’Armonk répond aux impératifs de la conjoncture : l’ensemble des analystes du secteur considère que ce segment devrait continuer de croître durant la crise, voire en profiter. Wilfrid Guerit, directeur des activités de services CRM & BI chez IBM GS France et partie prenante pour l’Hexagone de la mise en place de BAO, explique ainsi que « si le marché informatique baisse un peu du fait de la crise ce n’est pas le cas de la BI. Dans un contexte difficile, prendre des décisions rapides et bien instruites devient un élément encore plus stratégique du pilotage des entreprises ». Au-delà de l’aspect conjoncturel, l’approche du décisionnel par les services est également l’occasion pour IBM de proposer une démarche réellement alternative face à SAP – nouveau leader du marché via le rachat de Business Object – et Oracle, tout deux partant de l’applicatif.

A la clef, partout dans le monde, une activité dédiée qui pourra jouer sur l’ensemble des leviers du groupe : matériel, logiciel et surtout R&D. Selon Wilfrid Guerit, ce dernier point est essentiel, tant les requêtes des clients en matière de décisionnel peuvent être complexes dés lors que l’on cherche à optimiser le passage de la remontée d’information à la décision puis à l’action. « Dans notre dernière étude CEO 2008, 30 % des dirigeants affirmaient prendre leurs décisions à l’intuition. C’est un taux d’autant plus important que bien souvent l’information existe. Le problème réside dans sa remontée mais surtout dans son exploitation. Avec BAO, nous souhaitons donner du sens à la donnée et transformer l’information en modalité d’action, le tout en temps réel. »

Une difficulté d’exploitation des données déjà stigmatisée fin janvier lors du Gartner Business Intelligence Summit 2009 par les analystes du cabinet. Ces derniers mettent notamment en cause la perte de confiance entre directions opérationnelles et DSI et s’attendent à une reprise en main importante par les premières d’ici 2012. Et d’estimer que, côté fournisseur, ce mouvement devrait favoriser les offres analytiques intégrées incluant notamment – au delà de la dimension reporting – des outils de CPM (corporate performance management), d’analyse marketing en ligne et de prévisions.

Une vision reprise quasiment point par point par IBM qui précise que BAO s’organisera autour de cinq pôles, tous sous le contrôle de l’équipe mise en place par Fred Balboni : la stratégie, la BI et le BPM proprement dit, l’optimisation et l’analyse avancées, la gestion des processus d’information et la gestion de contenu. Autant de segments qui s'appuient sur l’étendue du portefeuille d’outils d’IBM. Portefeuille qui ne cesse de s’accroitre, Big Blue ayant annoncé il y a quelques jours – par la voix d’Ambuj Goyal - le rachat d’Exeros, petite société de la Silicon Valley spécialisée dans l’optimisation de la remontée d’information depuis les bases de données. Sur l’ensemble de la couche « gestion de l’information » - le pendant logiciel de BAO donc –, il s’agit de la seizième acquisition en un peu plus d’un an, depuis le rachat de Cognos.

Par Jean-Michel Franco - Directeur Solutions (Business & Décision) , Ian Huckle (Business & Decision)

Le « credit crunch » a propulsé les entreprises dans un climat d'incertitude sans précédent. Même les marques les plus solides voient leurs acquis remis en question et tous les secteurs d’activité sont concernés. Ceci a conduit, tout naturellement, à un élan de protectionnisme, de réduction des risques et de diminution des coûts. Le cash est roi, les budgets d’investissements sont mis à rude épreuve tandis que la rationalisation des budgets de fonctionnement est au centre de toutes les attentions. Tant de changements qui se produisent alors même que les marchés et les consommateurs sont en pleine évolution, due à l'ère numérique.

La rationalisation peut être tout simplement synonyme de réduction de coûts pour préserver ses acquis. Toutefois, pour les entreprises les plus agiles, elle représente une immense opportunité : celle de repenser les modèles opérationnels, de développer les activités les rentables, d’anticiper avant les autres les trous d’air et les périodes de reprise, d’équilibrer l’exposition au risque et d’orienter l’investissement au bon endroit. Plus que jamais, piloter l’entreprise impose une clairvoyance permanente sur les performances métiers et l’efficacité de chaque processus.

De la Business Intelligence à la gestion de la performance

La Business Intelligence voit ainsi élargir son champ de responsabilités, au plus près des processus de gestion et des opérations. Elle se mue en solution de gestion de la performance.

Pour les directions financières, le sujet n’est pas nouveau, même s’il reste encore beaucoup d’opportunités de rationalisation : dans ces périodes mouvementées, les hypothèses budgétaires et les prévisions, par exemple, doivent être réajustées en permanence, dans des cycles de plus en plus courts. L’analyse des coûts est un autre sujet d’intérêt, maintenant que l’entreprise s’organise en centres de services partagés, qui doivent refacturer leurs coûts et justifier de leur rentabilité.

Mais, la gestion de la performance s’étend aussi à d’autres activités de l’entreprise. Dans les banques, alors que l’évaluation de la performance des produits et celle des risques a toujours été un leitmotiv, les événements récents ont montré qu’elle imposait une vision encore plus fine à l’intérieur de la nomenclature de produits financiers devenus de plus en plus complexes, hétérogènes et interdépendants. De leur côté, les consommateurs de ces mêmes produits financiers, rendus de plus en plus prudents, exigent de leur banque l’information pertinente pour les accompagner dans leurs prises de décisions. Les autorités de réglementations étendent le périmètre de leurs instruments de contrôle, comme l’ont illustré les récents débats du G20 autour des modèles de rémunération des traders. La Business Intelligence augmente ainsi son empreinte au cœur, et non plus en superficie, des systèmes d’information de la banque : gestion des risques, relation client, analyse de la profitabilité, ressources humaines…

Jusqu’à présent observateur relativement passif de l’activité de l’entreprise, la Business Intelligence en devient aussi agent. Prenons l’exemple de la gestion des primes et des rémunérations variables, qu’elles concernent les salariés de l’entreprise ou ses tiers : distributeurs, courtiers, franchisés, etc. Dans cette période de crise, leurs modes de calcul suscitent toutes les attentions. Selon le Gartner, une affectation plus minutieuse des territoires commerciaux, des quotas et des primes est de nature à impacter le chiffre d’affaires d’une entreprise à hauteur de 5 à 10 % ! Et on voit bien que le sujet des rémunérations variables n’intéresse plus seulement l’entreprise, mais toutes ses parties prenantes qui exigent sans cesse plus de transparence : actionnaires, employés et syndicats, autorités de réglementations, presse, etc. Définir les modèles d’intéressement en fonction de la stratégie de l’entreprise, planifier les coûts, superviser le versement des primes et rendre compte de la juste attribution des rémunérations variables est donc devenu un processus en tant que tel, d’où le succès actuel de solutions dites d’Incentive & Commission Management pour les gérer.

Cet exemple peut être repris à tous les niveaux de l’entreprise. Chaque processus, chaque activité peut être significativement optimisée avec le support de système de gestion de la performance : gestion des dépenses liées aux achats, de la performance du marketing, optimisation de l’éco-efficience et des dépenses énergétiques, gestion des risques, etc.

De nouveaux besoins, mais des budgets resserrés

En se mettant au service de l’optimisation des processus, la Business Intelligence devient un outil d’entreprise en période de crise, au cœur des stratégies de rationalisation. Mais, elle reste soumise aux mêmes règles que toute autre activité dans l’entreprise : bien que confirmée par les DSI pour la quatrième année consécutive comme leur priorité numéro un, la dure réalité du terrain montre que les budgets consacrés à la BI sont au même régime que tous les autres.

Il faut donc, dans la BI comme ailleurs, faire plus avec moins. La bonne nouvelle, c’est que les voies d’optimisation existent : dans les grands comptes, il est de plus en plus fréquent d’identifier des potentiels de réduction du coût total de possession des systèmes d’information BI de 5 à 35 % ! La BI est suffisamment mature aujourd’hui pour évoluer d’un art à une discipline. Après s’être réalisée du côté des éditeurs de logiciels et des outils associés, la consolidation devient une opportunité aussi pour les entreprises, avec les potentiels d’économie d’échelle que cela implique.

Cela passe notamment par la création de centres de compétences en Business Intelligence, centres de services partagés pour le déploiement et la maintenance des projets. En devenant le point de contact unique pour la gestion du portefeuille des projets BI, ces organisations peuvent s’intéresser à l’optimisation du « delivery » : développement des nouveaux projets, maintenance corrective et évolutive, réalisation des grands projets d’amélioration continue de type consolidation des systèmes ou montée de version, etc. Certes, les modèles de déploiement très industriels, tels ceux des grands projets transactionnels, apparaissent mal adaptés à la Business Intelligence qui permet et nécessite des cycles de développement plus itératifs, en très forte proximité avec « le business » et les utilisateurs finaux.

Centres de services de proximité et recours à l'offshore

Il n’en reste pas moins qu’un certain degré d’industrialisation peut être mis en œuvre : la mise en place de centre de services externalisés de proximité pour le développement des interfaces de type rapport ou tableaux de bord, ou encore pour le support aux utilisateurs qui réalisent par eux-mêmes des requêtes ; l’utilisation de structures nearshore ou offshore pour les développements « lourds » (réalisation des développements pour les programmes d’intégration de données par exemple) ou pour des parties spécifiques de projets tels que les montées de version, les tests…

De telles organisations permettent de gagner sur les deux tableaux. En jouant l’industrialisation des développements, les coûts de possession diminuent. Ceci est la condition nécessaire pour dégager de nouveaux budgets qu’un centre de compétences BI spécialisé et libéré des contraintes du quotidien de la réalisation de projets saura exploiter pour mettre sur les bons rails les projets de gestion de la performance évoqués précédemment.

LeMagIT : Le décisionnel semble finalement relativement étanche à la crise avec des projets qui se poursuivent et des éditeurs plutôt en croissance. Qu’est-ce qui explique cette bonne tenue ?

LeMagIT : Le décisionnel semble finalement relativement étanche à la crise avec des projets qui se poursuivent et des éditeurs plutôt en croissance. Qu’est-ce qui explique cette bonne tenue ?

Jean-Pascal Ancelin : Dans le contexte de crise globale, les entreprises sentent qu’elles ont eu raison d’investir dans la BI au niveau des services financiers. Désormais, on voit arriver des projets touchant à l’ensemble des forces opérationnelles sur le terrain. Le but étant d’étendre l’utilisation des outils à l’ensemble des services susceptibles de s’en servir pour optimiser les revenus en période de crise ou encore anticiper au maximum le moment de la reprise.

A ce titre, au niveau de l’analyse, on a également une mutation avec une pression forte des entreprises utilisatrices pour obtenir des outils permettant d’anticiper et de prévoir et ce, quel que soit le département de l’entreprise. On a donc une tendance très forte à vouloir rapprocher la logique décisionnelle des processus métiers, avec des problématiques très fortes en terme de temps réel.

LeMagIT : Le paysage de la BI a beaucoup changé en 24 mois, avec une vague importante de consolidation. Quels sont les atouts d’une offre indépendante ?

Jean-Pascal Ancelin : Chez nous, depuis deux ans, on a surtout cherché à étoffer l’offre et finalement on a été plutôt créatif à ce niveau, un chemin que l'on compte bien poursuivre. De fait, nous n’avons pas eu à gérer les lourdeurs liées au processus de consolidation qu’ont rencontrées les acteurs qui ont été rachetés. On a travaillé sur nos points forts comme la facilité de déploiement qui nous permet d’être très vite présents sur de nombreux postes utilisateurs chez nos clients, notamment sur la partie reporting.

LeMagIT : Autre mouvement, la multiplication des acteurs open source avec des offres qui se multiplient, soit complètes, soit par module. Ces acteurs représentent-ils un risque pour Information Builders ?

Jean-Pascal Ancelin : C’est vrai que l’on a vu arriver de nombreux acteurs de l’open source ces derniers temps. Mais, pour l’instant, nous n’avons pas le sentiment de les voir se positionner sur des gros projets. De notre côté, on voit plutôt l’open source comme une opportunité de partenariat. Depuis le début, notre philosophie est d’ouvrir notre offre au maximum d’utilisateurs de l’entreprise. Les applications open source ont souvent cette même logique et on voit bien l’intérêt de partenariat, comme avec Lucene [projet d’outil de recherche open source, ndlr] par exemple, dans le search. Mais sur de la Business Intelligence pure, notamment pour les grands comptes, on va vraiment vers des logiques d’intégration forte d’environnements hétérogènes et sur le temps réel. Des domaines où aujourd’hui, on ne voit pas vraiment d’offres open source tout comme d’ailleurs sur l’analyse prédictive ou la gestion de la performance.

LeMagIT : Quelles sont les grandes tendances fonctionnelles à attendre dans les mois à venir ?

Jean-Pascal Ancelin : Nous misons beaucoup sur deux tendances fortes pour l’avenir. Tout d’abord le développement de l’analyse prédictive et celle du temps réel, deux demandes majeures chez les utilisateurs. Ensuite, il va surtout y avoir un croisement technologique entre le search et la BI, avec la recherche d’accès et d’interprétation de données tant structurées que non structurées. On a vu que les spécialistes de la recherche en ligne commençaient à proposer des formes de logiques d’exploitation décisionnelle, mais on est encore loin de la Business Intelligence, notamment concernant les connecteurs et le reporting. Aujourd’hui, on a des partenariats avec Google et Lucene et on discute avec l’ensemble des acteurs de la recherche en ligne.

Un autre point devrait se développer mais qui concerne plus le modèle que les fonctionnalités : c’est le Saas. Actuellement, on est en phase d’étude d’impact du modèle économique. Aux Etats-Unis, un premier service a été mis en place qui semble intéressant. En France, on devrait proposer un service courant 2010, nous sommes d’ailleurs en discussion pour nous adosser à un partenaire côté infrastructure. Nous n’avons pas vocation à proposer une infrastructure ou à administrer un datacenter.

La BI a bien le vent en poupe et cela devrait dépasser le cadre conjoncturel de la crise. C'est en tout cas l'avis rendu par le cabinet Aberdeen Group dans une étude dressant un état du marché pour le premier semestre de l’année 2009. Le déploiement à grande échelle des outils décisionnels devrait passer par l’intégration aux briques des grands ERP et des outils de gestion de la relation clients.

Sur les 1 600 dirigeants interrogés dans 36 pays par les analystes d’Aberdeen, environ un quart estime que la BI et les outils d’analyse sont les outils logiciels qui auront le plus d’effets en 2009. Seul point noir, si les entreprises évaluent bien les bénéfices de ces outils, la mise en œuvre correcte et les usages optimisés côté utilisateur final sont plus fastidieux à établir.

Parmi les utilisations particulièrement mises en avant par les dirigeants interrogés : le pilotage d’une stratégie environnementale de chasse au gaspillage, le suivi et l’analyse des campagnes de communication et de marketing, le pilotage de la relation client... En terme de RoI, ce sont les conséquences commerciales du déploiement qui sont mesurées prioritairement (pour 40% des entreprises interrogées), avant même les bénéfices attendus en matière de contrôle des dépenses, également souvent cités comme critère de mesure du RoI.

En clair, les déploiements actuels privilégient désormais plus des logiques tactiques et très opérationnelles plutôt que des approches stratégiques au niveau du pilotage global de l’entreprise, à RoI souvent plus long. Une forme de démocratisation qui, selon Aberdeen Group, devrait faire de la BI le principal module additionnel aux ERP désormais en place dans les entreprises.

A ce jeu là le couple SAP/BO – leader sur l’un et l’autre des segments applicatifs – pourrait bien tirer son épingle du jeu dans les mois qui viennent. De même, la stratégie orientée services mise en place par IBM autour de Cognos pourrait finir par porter ses fruits.

Gartner a publié au cœur de l’hiver ses prédictions concernant l’avenir des applications décisionnelles à court-moyen terme. L’occasion pour le cabinet d’études de faire le point sur l’impact possible d’une crise qui devrait déboucher sur de nouvelles pratiques tant en matière de collaboration dans la prise de décision que du côté de la validité et de la transparence de l’information. Si, toutefois, le BI fait très vite la preuve de sa valeur opérationnelle. Jean-Michel Franco, Directeur solutions chez Business & Decision et expert en matière de BI, était présent à La Haye (Pays-Bas) à l’occasion du Gartner Business Intelligence Summit 2009 qui s’est déroulé les 20, 21 et 22 janvier derniers. Il a accepté pour LeMagIT de passer au crible les différentes tendances observées par Gartner.

1 – Selon Gartner, d’ici 2012, les divisions commerciales (business unit) contrôleront directement au moins 40% du budget décisionnel total de leur organisation. Il s’agit, selon Gartner, d’une reprise en main importante dans la mesure où les directions opérationnelles n’ont plus réellement confiance dans la capacité de la direction informatique à convoyer les bons éléments pour l’aide à la décision. Côté fournisseur, ce mouvement devrait favoriser les offres analytiques intégrées incluant notamment – au delà de la dimension reporting – des outils de CPM (corporate performance management), d’analyse marketing en ligne et de prévisions.

Un risque de dépossession de la DSI sur les applications BI de l’entreprise qui ne va pas sans risque, selon Gartner. Les principaux d’entre eux étant la constitution de silos d’applications et d’informations limitant l’analyse et l’exploitation croisée de données mais aussi et, surtout, le risque de ralentissement du processus de remontée d’éléments cohérents pour aider la direction générale à prendre rapidement les décisions stratégiques.

Le point de vue de Jean-Michel Franco : « Les analystes de Gartner considèrent effectivement que les DSI risquent de perdre le contrôle des applications BI s’ils ne parviennent pas à répondre aux besoins du ‘business’ plus rapidement. Cela fait quatre années consécutives que c’est la priorité numéro un et, pourtant, dans la plupart des entreprises, la stratégie BI n’est toujours pas très lisible. L’un des axes d’amélioration passe par la constitution d’une organisation transverse dédiée au BI. Elle gèrerait des programmes plutôt que des projets, parce qu’un projet BI, contrairement à un projet ERP par exemple, ça se déploie par itération et ça doit évoluer en permanence. Ce type d’organisation permettrait aussi de mieux cadrer chaque initiative : s’assurer de la bonne définition des besoins, de la pertinence des indicateurs, hiérarchiser les projets… Ce sont donc des équipes pluridisciplinaires, à la fois expertes en Business Intelligence et en gestion de projets, mais aussi aptes à comprendre et formaliser les besoins métiers, d’accompagner les utilisateurs pour qu’ils utilisent l’environnement à son plein potentiel.

La tendance qu’évoque Gartner découle aussi de ce que j’appelle l’effet Web 2.0 : les directions métiers ne supportent plus d’être considérées comme de simples consommateurs du système d’information : ils veulent être acteurs, et pas seulement dans les phases de conception générale. Dans le BI, ils veulent être autonomes pour exploiter par eux-mêmes l’information, un objectif que peu de systèmes décisionnels sont parvenus à atteindre pleinement, malgré les vœux pieux. Mais ces utilisateurs veulent aussi s’impliquer plus en profondeur : maîtriser la qualité des données (ce qu’on appelle la data gouvernance), gérer et faire évoluer les référentiels qui sont dans leur domaines de responsabilité (ce que l’on appelle le master data management), voire même pouvoir créer par eux-mêmes les magasins de données de leur choix de la manière la plus dynamique possible.

Désormais, le rôle des DSI, c’est d’assurer la gouvernance de tout ce dispositif : donner aux métiers les moyens de leur autonomie, tout en assurant le contrôle. Les technologies qui permettent d’y parvenir existent sur le marché, reste à se les approprier. Pour les DSI, il me semble qu’il y a urgence face au risque de perte de contrôle qu’évoque Gartner. »

2 –Gartner prévoit, pour 2010, que 20% des organisations utiliseront en mode SaaS (Software as a service) une application analytique dédiée à leur secteur qui sera intégrée comme un composant standard de leur portefeuille applicatif décisionnel. Surtout, ce composant sera ouvert aux données externes via des services en ligne d’agrégation. Ces derniers devraient émerger par centaines, selon le cabinet d’études, et proposer des offres de niche très spécifiques. Ce mouvement impliquera de la part des patrons de branche et des DSI de travailler main dans la main pour favoriser l’intégration à la plate-forme BI de l’organisation.

Le point de vue de Jean-Michel Franco : « Le modèle SaaS s’adapte bien à des sujets que l’on peut aisément isoler du reste du SI. Mais plus il y a de points d’intégration au reste du SI, plus le modèle SaaS perd de sa pertinence. Le BI dans son ensemble n’est donc pas à priori la première cible, du fait de sa forte dépendance aux systèmes transactionnels de l’entreprise. Ceci dit, des choses intéressantes se font jour. Le CPM (corporate performance management), et, plus particulièrement, l’élaboration budgétaire, en est un bon exemple. Quelques entreprises fondées sur le modèle SaaS s’affirment sur ce marché, comme Adaptive Planning ou Host Dynamics. Le fait qu’elles ne soient pas encore présentes en France montre que l’on se situe au tout début de cette tendance.

Au-delà du CPM, on voit aussi arriver des jeunes pousses qui proposent des applications analytiques SaaS sur des sujets pointus, comme la gestion des portefeuilles projets dans la gouvernance de la DSI ou la R&D, la gestion des primes et intéressements, la détermination des prix de ventes… On voit aussi le BI compléter les solutions SaaS que les entreprises ont déjà adoptées, que ce soit à l’intérieur même de ces solutions - Oracle CRM On Demand par exemple -, ou en complément de celles-ci. De nombreux éditeurs BI se positionnent d’ailleurs comme complément de Salesforce.com pour lui amener une dimension analytique. Malgré cette tendance SaaS qui est réelle, il serait toutefois très étonnait qu’elle atteigne l’ampleur évoquée dès 2010 !

On observe aussi, et de manière bien plus nette, le développement d’un modèle hébergé ou associé à des services d’exploitation clé en main. Des jeunes pousses comme Kognitio ou 1001 Data fournissent un « Data Warehouse as a Service » - HP le fait également avec l’Appliance BI Accelerator. Il s’agit d’appliances qui sont, soit livrées chez le client et dans ce cas administrées à distance, soit fournies en mode hébergé. Le prestataire associe à sa solution un accord de niveau de service et peut, éventuellement, la commercialiser en mode locatif. Parfois même, la maintenance et les montées de version sont proposées clé en main. C’est un modèle extrêmement prometteur selon moi, à fortiori si l’on s’appuie sur la virtualisation car, dans ce cas, le client est associé à un serveur virtuel et non physique, d’où des coûts de service raisonnables. En tant qu’hébergeur, Business & Decision s’oriente d’ailleurs vers ce modèle d’infogérance spécialisée ; et l’on constate un très fort intérêt du marché pour cette approche. Mais, il ne s’agit pas de SaaS au sens « traditionnel » du terme.

Dernier sujet à suivre : l’intégration de données issues des applications SaaS dans les Data Warehouse d’entreprise. Prenons le cas d’une entreprise qui gère ses commandes et sa comptabilité client dans un ERP en interne et dont le CRM est en mode SaaS. Elle doit pouvoir analyser des indicateurs clés comme la rentabilité de ses clients, et donc extraire les données de l’application SaaS et les intégrer au Data Warehouse. On voit apparaitre des solutions d’intégration spécifiques pour le SaaS et les solutions ETL traditionnelles prendre en considération ce modèle. »

3 – Pour Gartner, 2009 devrait être l’année du décisionnel collaboratif avec l’arrivée d’offres combinant fonctions d’aide à la décision et outils issus des réseaux sociaux. Selon le cabinet d’études, il y a là matière pour le DSI à concevoir une plate-forme d’exploitation de données collaboratives informelles. Il s’agira d’exploiter, dans un contexte décisionnel, les données liées au développement de l’usage des outils de réseaux sociaux en entreprises.

Le point de vue de Jean-Michel Franco : « il y a un domaine où le décisionnel collaboratif a fait ses preuves : c’est le budget - typiquement un processus de décision collectif, qui nécessite de se mettre d’accord entre le management (top down) et l’opérationnel (bottom up).

Il y a un autre domaine où c’est plus long à se matérialiser : les « balanced score cards » où il est prévu de décliner une stratégie en initiatives, avec un responsable pour chacune d’entre elles. Cela fait longtemps que les concepts existent, mais ils sont longs à devenir des bonnes pratiques acceptées par tous. Gartner semble considérer que les réseaux sociaux pourraient jouer un rôle de facilitateur, mais ça reste à prouver.

Plus généralement, selon moi, il y a une autre tendance majeure qui n’apparaît pas dans cette analyse de Gartner : c’est l’intérêt de plus en plus fort accordé à la gestion de l’information au sens large. On parle de l’EIM, qui regroupe notamment la gestion des données de référence, la gestion de la qualité, de la synchronisation et de la diffusion des données, le stockage/sécurisation/gestion du cycle de vie (ECM) et l’accès (search) aux données non structurées. C’est un enjeu clé, auquel les entreprises sont particulièrement sensibles et qui commencent à faire l’objet d’approche dédiées. »