In-Memory : comment SAP compte ringardiser les bases de données (et surtout marginaliser Oracle)

Monter le maximum de données en mémoire pour offrir de meilleurs temps de réponse. Si l'idée a déjà plus de 20 ans dans le décisionnel, SAP tente aujourd'hui de l'adapter à son domaine traditionnel, le transactionnel. En plus d'une simplification des applications, l'éditeur entend remettre en cause le pouvoir des grandes bases de données, à commencer par celle du grand rival Oracle. Reste à amener la technologie à maturité et à la faire adopter par la base installée. Ce qui, dans l'environnement SAP, n'est pas forcément le plus facile.

In-Memory (littérallement "en mémoire"). Dans les récentes conférences organisées par SAP, le terme revient comme un mantra. Il s'agirait, à en croire les responsables de l'éditeur européen, tout bonnement de la vision technologique maison de l'évolution des systèmes d'information. Evoqué dès le printemps 2009, le concept - connu depuis les années 80 dans la BI avec un éditeur comme Applix - consiste à réarranger en colonnes les données et à les stocker directement en mémoire vive, en passant par des techniques de compression pour optimiser l'utilisation de la DRAM.

En apparence, la technologie n'a rien de révolutionnaire : elle est largement employée dans le décisionnel pour améliorer les temps de traitement. Sauf que, cette fois, SAP envisage de l'étendre à son domaine d'origine, le transactionnel. La promesse de temps de réponse améliorés, mais aussi d'une remise en cause de la gestion des bases de données telle qu'on la pratique aujourd'hui.

Comment l'éditeur compte-t-il s'y prendre ? Quand les premiers produits ERP seront-ils disponibles ? Selon quelles modalités ? Avec quelles conséquences pour ses "partenaires" dans les bases de données (dont le plus important n'est autre que le grand rival Oracle) ? Autant de questions que l'éditeur laisse pour l'heure sans réponse.

Tout en ménageant le suspense : en octobre dernier, puis en décembre, le responsable du développement de l'ensemble du porte-feuille de produits de l'éditeur, Jim Hagemann Snabe, expliquait lors d'une conférence organisée par l'éditeur : "In-Memory changera la façon même dont on peut construire des applications". Et Vishal Sikka, directeur technique de l'éditeur, d'embrayer : "Avec cette technologie, s'ouvre l'opportunité d'analyser des données à la volée, sans créer d'aggrégats. Une entreprise pourra ainsi réaliser une clôture de comptes à chaque fois qu'elle le souhaite. Cette capacité rendra les applications plus simples, et extensibles à la volée. Car on peut créer de nouvelles colonnes quand on le souhaite".

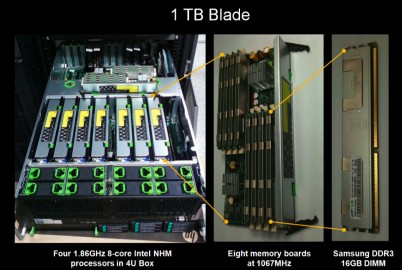

En décembre, le directeur technique a levé le voile sur un prototype, fonctionnant dans les labos de l'éditeur et basé sur un serveur blade embarquant 1 To de mémoire (en photo ci-dessus). "Avec InMemory et ce type de configuration, on peut stocker toutes les données du back office d'un très grand compte", a promis Vishal Sikka. SAP revendique des taux de compression de 20 pour 1 avec son stockage en colonnes, contre 2 pour 1 dans l'univers des SGBD traditionnels.

Des bases de données devenues moins essentielles

Dans la filiale française, Thierry Pierre, responsable d'offres, explique que la technologie couvrira début 2010 l'ensemble des entrepôts de données maison (soit BW mais aussi les univers BO). "Puis, on va l'étendre à d'autres usages comme les moteurs de recherche. Avant d'accélérer également certaines transactions de l'ERP, celles travaillant sur de grands volumes de données", précise-t-il.

| VERBATIM |

| Hasso Plattner, co-fondateur de SAP |

| "J'ai toujours pensé que l'arrivée des solutions de datawehouse (ou entrepôts de données, NDLR) n'était qu'un compromis. La flexibilité et la vitesse que nous avons gagnées l'ont été au prix d'un surcroît de gestion en extraction et chargement de données, ainsi que de contrôles accrus en matière de redondance". |

Avec In-Memory, "le disque dur n'est utilisé que pour le chargement et la création d'images (snapshot, NDLR) permettant une restauration rapide. En fait, le disque devient ce qu'était la bande jusqu'à récemment". "Les données "historiques" peuvent rester accessibles, mais sur un support moins coûteux et plus lent (mémoire flash ou disque). Les données courantes plus l'année fiscale de référence (n-1, NDLR) devront être placées en mémoire vive sur les blades pour des comparaisons d'une année sur l'autre dans les systèmes."

Même s'il présente In-Memory comme une surcouche de la base de données, où sera toujours gérée la persistance, Thierry Pierre avance que la technologie constitue une remise en cause du pouvoir des grands SGBD. Notamment pour la dimension performances, un domaine - l'optimisation - où, précisément, Oracle fait figure de référence. Le responsable des offres au sein de la filiale hexagonale souligne toutefois que les SGBD conserveront leur raison d'être en matière de sécurité ou de haute disponibilité. Reste qu'en déportant la question des performances, SAP ouvre la porte à une redistribution des cartes, où la brique base de données pourrait être confiée à une solution plus spécialisée, et surtout moins onéreuse.

Les avancées de SAP sur In-Memory reposent largement sur les travaux du Hasso Plattner Institute, un institut de recherche basé à l'Université de Postdam et à Palo Alto et financé par le co-fondateur de l'éditeur. Dans un livre blanc datant de l'été dernier, Hasso Plattner, qui reste le président du comité de supervision de SAP, écrivait qu'avec un serveur à 16 coeurs, la technologie peut espérer gérer plus de 10 Mo de données par milliseconde. "Comme des configurations de 100 serveurs blade sont déjà disponibles, des installations allant jusqu'à 50 To de données OLTP (traitement de transactions en direct, NDLR) ou OLAP (traitement analytique, NDLR) peuvent être converties en systèmes purement In-Memory basés sur de la DRAM", calcule le co-fondateur de SAP.

Au minimum 30 % de code en moins

Qualifiant les recherches menées depuis 2 ans et demi par le Hasso Plattner Institute d'encourageantes, le document explique qu'une équipe de recherche travaille sur un nouveau système comptable (comptabilités clients et fournisseurs, comptabilité générale, trésorerie y compris les prévisions).

In-Memory : comment SAP compte ringardiser les bases de données (et surtout marginaliser Oracle)

Hasso Plattner précise : "la base sera le système SAP on demand ByDesign". Le futur ERP pour PME en mode Saas de l'éditeur sert donc de laboratoire à une technologie manifestement promise à s'étendre au fleuron de la marque, la Business Suite. "Dans la réécriture des applications existantes, nous pensons réduire le volume de code de plus de 30 % (dans des applications plus formelles de 40 à 50 %). De nombreuses parties peuvent être totalement restructurées en utilisant l'indexation totale offerte par le stockage en colonne", écrit Hasso Plattner.

En option pour Oracle 11g

Reste que la perspective reste encore lointaine et les résultats incertains. "Même s'il ne serait pas surprenant de voir SAP procéder à un rachat dans ce domaine, cet éditeur a toutes les capacités pour développer de nouvelles approches seul", explique François Guérin, responsable avant-vente de Sybase en France. "L'interrogation porte essentiellement sur le temps que mettra SAP à sortir cette technologie et surtout à l'amener à un niveau de maturité suffisant".

Pour Ray Wang, associé au sein du cabinet Altimeter Group et spécialiste du marché des ERP, la date de sortie des premières applications reconfigurées pour In-Memory devrait se situer aux environs de 2013 ou 2014. Car si l'utilisation en production du stockage en mémoire est déjà une réalité, elle reste limitée à des applications très particulières.

Le décisionnel donc, où des acteurs comme Sybase (avec IQ) mais aussi SAP (avec BI Accelerator pour BW et aujourd'hui Explorer) l'exploitent. Mais aussi dans des applications pour les salles de marché ou les opérateurs télécoms, par exemple. Tant Oracle que IBM (pour DB2) proposent d'ailleurs des solutions de stockage des données en mémoire venant se positionner au-dessus de leur SGBD traditionnel. TimesTen, l'option d'Oracle, fonctionne ainsi comme "une surcouche de 11g, avec des transmissions asynchrones entre les deux et des systèmes de logs permettant de tracer les actions", explique Jean-François Castella, responsable du département logiciel d'Infotel, SSII spécialiste des bases de données.

Le casse-tête de la migration de la base installée

Ce dernier reste pourtant dubitatif quant aux annonces (ou déclarations d'intention ?) de SAP. "Pour l'instant, il n'y a pas de calendrier de sortie (ou roadmap). Mettre en place une infrastructure avec 1 To de mémoire implique de dépenser environ un million de dollars. Il faut vraiment que le retour sur investissement se justifie ! Aujourd'hui, cela me paraît démesuré sur des applicatifs SAP. Dans le futur, peut-être ce choix se justifiera-t-il du fait de la baisse constante du prix des mémoires".

Et le responsable d'Infotel de pointer une autre difficulté, savamment éludée par SAP pour l'instant : la transition de la base installée, un facteur qui freine d'ailleurs très largement l'innovation dans les ERP. "C'est le plus gros problème, car les applications SAP sont très proches du SGBD qu'il s'agisse d'Oracle ou de DB2. Et vont utiliser des éléments non standards, ce qui complexifie les migrations, explique Jean-François Castella. Avec l'option TimesTen, cela ne marche plus. Le travail sur la connectivité s'annonce donc important. SAP peut certes produire des démos, mais faire tourner cette technologie sur des installations actuelles semble bien plus compliqué."

En complément : - Télécharger le livre blanc de Hasso Plattner sur In-Memory - Business ByDesign : pour son offre Saas pour PME, SAP se rapproche de l'orbite Microsoft (décembre 2009) - Innovation : SAP mise sur BO pour faire patienter les utilisateurs (octobre 2009)