Tableau : au-delà de la visualisation de données

L’éditeur travaille à remplacer son moteur par une base de données qui mêle OLAP et OLTP. Un outil de préparation et de transformation des données est aussi inscrit sur la feuille de route.

Parce que finalement, la visualisation de données devient presque une commodité et n’est plus aussi porteuse de valeur dans un marché très concurrentiel, Tableau a décidé d’entreprendre un chantier d’expansion et un renforcement de son catalogue pour 2017. Et cela passera par une base de données et par un outil de nettoyage et d’intégration de données, nous a confirmé Andrew Beers, Directeur du développement chez Tableau Software, en visite à France.

Cette base de données, qui à terme devrait servir de socle pour le traitement des données à l’ensemble des produits du groupe, provient d’un rachat intervenu plus tôt dans l’année : celui Hyper, nous a confié Andrew Beers. Cette base, issue d’un projet universitaire en Allemagne, a la particularité d’associer le transactionnel (OLTP) et analytique (OLAP) dans un unique moteur. Une proximité qui selon Tableau doit accélérer le rendu analytique et le requêtage sur des données multi-sources. Hyper prend en charge aussi bien les données structurées que non structurées, indique le site Internet du projet, et réalise ses traitements en mémoire. « Les entreprises doivent manipuler plus de données éparpillées. L 'idée n'est plus d'aller chercher les données en interne, mais aussi de cumuler les sources », assure encore le responsable.

Bref, Tableau souhaite ici cibler les performances de ses outils. Andrew Beers évoque des gains en matière de rapidité notamment dans le chargement des données.

A ce titre, la préparation et le nettoyage de données est donc une évolution logique pour Tableau. Logique mais aussi indispensable, si l’on en croit Gartner. Dans son Magic Quadrant 2016, Gartner pointe du doigt les faiblesses de Tableau en la matière. Si en effet, l’outil propose un vaste pan de connecteurs multi-sources, il supporte peu de fonction de préparation de ces données issues de différentes sources, explique le cabinet d’analystes. « Pour compenser cette faiblesse, un nombre grandissant de clients de Tableau se sont tournés vers des éditeurs spécialisés dans la préparation de données en self-service et constituent donc une option au format natif de Tableau », affirme Gartner. Un souci pour Tableau car « cela nécessite le déploiement d’une autre solution ; ce qui amplifie les problèmes de ROI qui existe déjà dans sa base de clients. »

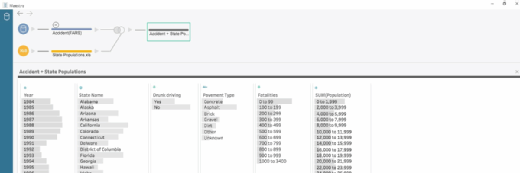

Cela prendra la forme d’un outil nommé Maestro et dont la sortie est prévue courant 2017. Avec Maestro, Tableau veut certes compléter l’étendue de son offre, mais aussi cibler les data stewards, ces spécialistes de la qualité des données, indispensables dans la chaîne des traitements. L’approche se veut donc centré davantage sur les métiers que sur le DSI, « là où sont utilisées les données, », précise Andrew Beer. Initialement, Maestro sera optimisé pour Tableau, a-t-il ajouté.

Une plateforme analytique pour séduire de plus en plus les grands comptes ?

Finalement, avec l’ensemble de ces nouvelles briques, Tableau construit petit à petit une plateforme analytique capable, selon ses responsables, de séduire plusieurs profils d’entreprises. Toutefois, si PME tant publiques que privées, et start-ups sont historiquement les clients cibles de l’éditeur, Edouard Beaucourt, le patron de Tableau en France, précise rencontrer de grands comptes dans l’Hexagone. « Le marché français se compose aujourd’hui de petites et de grandes entreprises, et représente un des premiers marchés en Europe », explique-t-il, citant aussi bien Criteo ou Blablacar, que La Poste, PSA ou BNP Paribas. En Europe, Tableau revendique quelques 9 000 clients. Avec cette approche, logique dès lors qu’une version Linux de Tableau Server soit actuellement en cours de développement (lancement prévu à la mi-2017).