HP « The Machine » : entre arlésienne et réalisme

HP serait-il en train d’enterrer son projet de recherche le plus fou et le plus visionnaire ? L’entreprise dément l’idée mais revisite son projet en adoptant une approche plus réaliste. Objectif : obtenir un prototype dès 2016.

« The Machine », c’est sans doute le projet le plus ambitieux et le plus fantasque issu des HP Labs. Dévoilé il y a exactement un an, lors de la HP Discover 2014, son architecture revisite complètement celle qui régit les systèmes actuels depuis les années 70 avec sa dissociation mémoire et stockage.

« The Machine » est un ordinateur sans RAM ni stockage dans le sens traditionnel. Il est animé par une multitude de processeurs spécialisés (plutôt que des CPU généralistes) reliés par un bus photonique. « The Machine » fusionne les concepts de mémoire et de stockage en un unique espace non volatile de plusieurs péta-octets, rapproche les données des unités de calculs, adopte les concepts de Key/Values au lieu des traditionnels systèmes de fichiers et organisations hiérarchiques des données, et implémente des points de contrôle de la sécurité tout au long de l’assemblage de couches qui s’étend du matériel (bare metal) aux logiciels.

Quant au cœur de la machine s’appuie sur des bus de communications photoniques et non plus électriques.

Sur le papier, The Machine consomme 1/80ème de l’énergie nécessaire à alimenter le Fujitsu K (le plus puissant des supercalculateurs actuels) tout en offrant 6 fois plus de puissance de calcul. En dévoilant son projet l’an dernier, HP s’était fixé une roadmap assez précise : choisir son partenaire CPU à bus photonique avant la fin 2014, échantillonner les mémoires persistantes (Memristors) début 2015 avec une fabrication en masse en 2016, assembler les premières briques de « The Machine » en 2017 pour lui permettre d’exécuter ses premiers programmes en 2018.

Retour au réel et le problème Memristor

Que reste-t-il, un an après, de cette ambitieuse roadmap ?

A priori pas grand-chose !

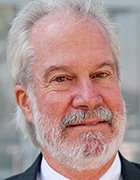

« The Machine » fût le grand absent de l’édition 2015 du HP Discover qui s’est tenu à Las Vegas la semaine dernière. Et pour cause… Lors d’un entretien avec la presse, Martin Fink (en illustration), CTO de HP et Directeur des HP Labs, a confirmé que le projet était en train de « changer de direction et de s’orienter vers une architecture pilotée par la mémoire » focalisée sur la manipulation de volumétries gigantesques plutôt que sur la puissance de traitements.

Un changement de stratégie qui repose, semble-t-il, en grande partie sur les difficultés de développement des « Memristors », ces composants de mémoire persistante sur lesquels repose tout le concept de The Machine.

L’idée des Memristors a bientôt 40 ans. C’est l’arlésienne de HP qui travaille activement sur son développement depuis 2008. Cette mémoire combine les performances de la RAM (en termes de latence et transferts) à la persistance des données sur Flash. Non seulement la consommation énergétique est quasi nulle, mais ces mémoires peuvent être physiquement relativement éloignées des processeurs (ce que ne permet pas le design des DIMM actuelles).

Dans sa vision « The Machine », HP prévoit que n’importe quel octet de son espace de 160 péta-octets soit ainsi accessible en moins de 250 nano-secondes. Le problème est que HP semble encore bien loin de pouvoir échantillonner ses Memristors cette année et encore plus loin d’une production régulière en 2016. La principale difficulté résiderait dans la fiabilisation de la technologie dès que l’on essaye de la densifier.

Un retard qui fait s’effondrer tout un projet sur lequel 75% des chercheurs du HP Labs seraient impliqués, complètement ou partiellement. On comprend mieux, dès lors, l’empressement d’HP à changer son fusil d’épaule.

HP est-il en train de tuer The Machine?

Selon HP, le développement des Memristors n’est pas abandonné et reste un des angles de recherche phares des HP Labs. Mais de l’aveu même de Martin Fink, les ingénieurs de « The Machine » regardent attentivement les éventuelles alternatives. « Nous avons sur-associé le développement de The Machine aux Memristors », explique-t-il ainsi dans les colonnes du New-York Times. « Nous essayons désormais de la mettre en œuvre avec des technologies existantes ».

Un changement stratégique fondamental qui cherche avant tout à dé-corréler les problèmes conceptuels des problèmes technologiques.

Et aussi

Car une architecture aussi radicalement différente, qui s'appuie sur une mémoire non volatile unifiée au stockage, nécessite non seulement le développement d’un système d’exploitation adéquate mais également le développement d’applications capables d’en tirer profit - donc de middlewares simplifiant et uniformisant la conception de telles applications.

« C’est un vrai challenge de réécrire Linux pour créer un système capable de gérer de la mémoire et de la mémoire virtuelle à l’échelle du péta-octet », explique ainsi Rich Friedich, Director of Systems Software de « The Machine ». En outre, le projet comprend tout un volet qui redéfinit les concepts de sécurité au sein d’une architecture et de sécurité d’accès aux données.

Créer la version de Linux capable de piloter cette architecture, développer les middlewares et donner aux développeurs les moyens d’inventer les applications du futur monopolise les énergies de nombreuses équipes de chercheurs au sein d’HP Labs. Ces recherches sont aussi fondamentales que celles des bus photoniques et des Memristors.

Faire preuve de réalisme

Pour faire avancer le projet, Martin Fink semble désormais vouloir adopter une attitude plus pragmatique et plus à même de mener rapidement au développement d’une nouvelle génération d’ordinateurs basés sur des pools de mémoire non volatiles. « Dans un sens, la DRAM est non volatile si on la maintient alimentée », rappelle-t-il.

Obtenir l’équivalent d’un datacenter actuel dans une armoire de la taille d’un réfrigérateur

Exit les Memristors, exit les bus photoniques, exit les processeurs spécialisés, le nouveau projet des HP Labs vise désormais à construire un prototype basé sur 2500 CPU et une capacité de 320 To s’appuyant sur de la DRAM alimentée en permanence. L’objectif est d’obtenir un tel prototype opérationnel dès la fin 2016 - ce qui est déjà un challenge à part entière. Faire tenir tout ceci en un seul rack est en effet un beau défis puisque le plus puissant des Superdome HP ne dépasse pas les 12 To de RAM par exemple. En un sens, le nouveau projet consiste bel et bien à obtenir l’équivalent d’un datacenter actuel dans une armoire de la taille d’un réfrigérateur.

Certes, cette machine sera tout sauf économe en énergie et technologiquement moins marquante que le projet initial, mais elle permettra de mettre en œuvre les concepts systèmes, middlewares et logiciels qui sous-tendent la vision « The Machine » et devrait encourager les développeurs à imaginer les applications à même d’en profiter.

Lors de la conférence HP Discover, le stand HP Labs démontrait d’ailleurs différents outils actuellement utilisés pour le développement de « Linux For the Machine ».

Le « Machine Architecture Simulator » simule les nœuds de calcul et les multiples pools de mémoire non volatile. Ce simulateur permet aux ingénieurs de développement de sélectionner le type de processeurs : ARM ou x86. Il offre une bonne idée du fonctionnement de ce prototype revu à la baisse de « The Machine ».

Dans un second temps, HP envisage de remplacer la DRAM par de la mémoire PCM (Phase Change Memory) qui a le mérite d’exister déjà en dehors des laboratoires de recherche. En attendant que les Memristors deviennent un jour réalité… Un jour… Peut-être.