Claude 3.5 Sonnet : Anthropic met à jour ses LLM pour rattraper OpenAI

Anthropic a annoncé la sortie progressive de la collection de modèles Claude 3.5, en commençant par un modèle multimodal de taille moyenne. Celui-ci s’en sort déjà mieux que Claude 3 Opus – le meilleur des LLM de la startup jusqu’à présent – et se frotte à GPT-4o.

Pour rappel, jusqu’alors, la collection Claude 3, dévoilée en mars dernier, était composée de trois LLM principaux, en ordre de taille Haiku, Sonnet et Opus.

Ici, Anthropic présente Claude 3.5 Sonnet. Le modèle est disponible depuis les API de la startup, Amazon Bedrock et Google Vertex AI. Comme Claude 3 Sonnet, il coûte 3 dollars par million de tokens en entrée, et 15 dollars par million de tokens en sortie. La fenêtre de contexte reste inchangée : elle est de 200 000 tokens.

Il peut être testé gratuitement depuis le site Web Claude.ai et l’application Claude iOS. Les entreprises devront souscrire les abonnements Claude Pro et Team pour profiter de ces applications dans un environnement contrôlé.

Très transparente quant à son approche de l’IA responsable, Anthropic l’est beaucoup moins au moment d’évoquer ses travaux d’affinage. Aucune information supplémentaire ne transparaît sur le processus d’entraînement de cette mise à jour. Dans la documentation fournie par Google Cloud, l’on apprend que les connaissances de Claude 3.5 Sonnet sont arrêtées au mois d’avril 2024 et que la startup utilise diverses techniques de récupération de données publiques sur Internet.

Claude 3.5 Sonnet, fort en code et en maths

Néanmoins, la startup assure que Claude 3.5 Sonnet « surpasse [son] précédent modèle le plus performant, Claude 3 Opus, tout en fonctionnant plus rapidement et à moindre coût ».

Mieux, Anthropic assure que Claude 3.5 Sonnet titille ou dépasse GPT-4o dans les benchmarks présentés. Claude 3.5 Sonnet obtient un score de 88,3 % au test de raisonnement MMLU effectué en 0 shot (sans exemple) avec la méthode Chain of Though, et 88,7 % en « 5 shot ». Claude 3 Opus atteint une note de 85,7 % dans le premier cas et 86,8 % dans le second. Selon les tests d’Anthropic, GPT-4o fait 88,7 % au test « 0 shot ».

La startup met surtout en avant le parangonnage de connaissances GPQA où Claude 3.5 Sonnet décroche 59,4 % en zero shot, contre GPT-4o et ses 53,6 %.

Mais c’est surtout en mathématiques et en programmation que Claude 3.5 Sonnet s’illustre. Il obtient 92 % aux tâches de programmation Python HumanEval 0 shot, contre 84,9 % pour Claude 3 Opus et 90,2 % pour GPT-4o. Au benchmark de mathématiques GSM8K, DROP et MGSM, Claude 3.5 Sonnet affiche respectivement 96,4 %, 87,1 % et 91,6 %, devant ses prédécesseurs et le modèle d’OpenAI. Pour autant, ce dernier est meilleur quand il est confronté au benchmark de résolution de problèmes MATH (76,6 % pour GPT-4o, 71,1 % pour Claude 3.5 Sonnet).

Surtout, Claude 3.5 Sonnet serait deux fois plus rapide à l’inférence que Claude 3 Opus, mais là, il faut croire l’éditeur sur parole.

Par ailleurs, le petit nouveau d’Anthropic s’en sort haut la main dans les tests d’interprétation de visuels MathVista, AI2D, ChartQA et DocVQA.

« Claude 3.5 Sonnet est notre modèle de vision le plus performant à ce jour », avance Anthropic dans un communiqué de presse.

« Ces améliorations sont particulièrement remarquables pour les tâches qui requièrent un raisonnement visuel, comme l’interprétation de tableaux et de graphiques. Claude 3.5 Sonnet peut également transcrire avec précision du texte à partir d’images imparfaites – une capacité essentielle pour la vente au détail, la logistique et les services financiers », lit-on plus loin.

Pour autant, malgré sa méthodologie axée sur la mitigation des risques, Anthropic indique que son petit nouveau présente le même niveau de dangerosité que les LLM de la collection Claude 3. En septembre 2023, la startup a publié un système de classification des LLM suivant une échelle de risques à quatre niveaux (AI Safety Levels ou ASL). Claude 3.5 Sonnet « ne présente aucune capacité susceptible de provoquer une catastrophe, bien qu’il présente les premiers signes de ces capacités ». Ce niveau de risque correspond à celui de la plupart des LLM disponibles sur le marché.

Les LLM Claude 3.5 Haiku et Sonnet sont attendus plus tard cette année. « Notre objectif est d’améliorer sensiblement la courbe de compromis entre l’intelligence, la vitesse et le coût de nos modèles en quelques mois », avance la startup.

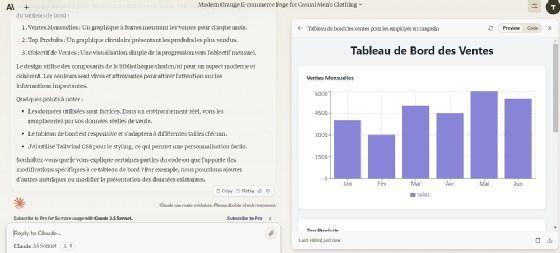

Artifacts, un petit plus pour Claude.ai

En attendant, Claude.ai intègre en préversion la fonction Artifacts. Celle-ci permet d’obtenir un aperçu visuel des éléments de code, de design ou de texte dans une fenêtre dédiée. Dans une vidéo, l’éditeur présente cette fonctionnalité en développant un jeu vidéo 8 bit dont le héros est un crabe devant sauter par-dessus des crustacés. Les tests du MagIT sont moins amusants, mais démontrent qu’il est possible de générer des mockups pour la page d’accueil d’un site Web d’e-commerce et un tableau de bord de visualisation des ventes en deux phrases et autant de clics. Les artefacts de droite dans la fenêtre ne sont malheureusement pas directement éditables, mais le code (ici React, HTML, CSS) correspondant est téléchargeable et les éléments visuels sont bien interactifs.

Anthropic indique qu’elle développe d’autres fonctions et modalités pour davantage de cas d’usage métier, sans préciser lesquelles. Ses ingénieurs sont toutefois en train de concevoir la fonction Memory, qui devra permettre de retenir l’historique et les préférences de l’utilisateur.