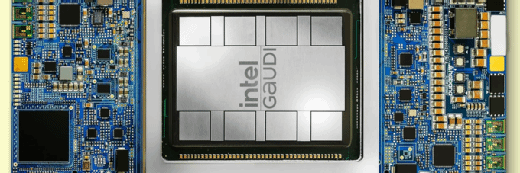

Intel dévoile Gaudi3, sa réponse aux GPU de Nvidia

Le nouveau GPU d’Intel serait plus rapide et plus économique que l’actuelle puce H100 du leader du marché. Gaudi3 aura aussi le mérite d’être disponible en quantité dès cet été.

Intel vient de dévoiler sa réponse aux GPUs de Nvidia : son Gaudi3 serait en moyenne 50 % plus rapide que l’actuel H100 pour entraîner et exécuter des modèles d’IA, et globalement 40 % plus efficace en matière de calculs/watts dissipés. Il intègre aussi son propre contrôleur Ethernet RoCE pour communiquer sur 24 ports en 200 Gbit/s chacun, soit avec d’autres Gaudi3 sur le réseau, soit avec des baies de stockage NAS pour transférer les données sans passer par le processeur.

Ce contrôleur Ethernet intégré devrait permettre de baisser sensiblement le coût des serveurs – un H100 a 18 liens NVLink en 400 Gbit/s chacun, mais il faut passer par des cartes réseau BlueField de Nvidia pour en faire des ports Ethernet. Cela dit, Intel ne partage pas encore de prix public. Le GPU Gaudi3 est censé être « significativement moins cher » que les 40 000 dollars facturés par Nvidia pour un H100.

Les caractéristiques du Gaudi3 sont, sur le papier, moins impressionnantes que celles prévues pour le futur GPU B200 de Nvidia. Notamment, la puissance de calcul du Gaudi3 est de 1 835 TFLOPS en 8 bits (la taille qui importe pour les traitements d’IA), alors que celle du B200 serait de 10 000 TFLOPS. Mais qu’importe : le B200 ne devrait pas arriver dans les serveurs avant 2025, alors que les cartes PCIe 5.0 Gaudi3 seraient disponibles dès cet été, au moins sur le PowerEdge XE9680 de Dell. HPE, Lenovo et SuperMicro promettent de proposer d’autres configurations simultanément.

Disponible est d’ailleurs le principal argument du GPU d’Intel ; ceux de Nvidia seraient livrés en moyenne 18 mois après avoir passé commande.

L’enjeu de concurrencer

Gaudi3 n’est pas la seule alternative parmi les puces accélératrices très haut de gamme. AMD a lancé en fin d’année dernière le MI300X, notamment disponible sur les serveurs Cray EX255a de HPE. Citons aussi les puces surpuissantes fabriquées par les hyperscalers, mais pour leur seul usage : Trainium2 chez AWS, Maia 100 chez Azure et TPU v5p chez GCP.

Dans les serveurs des entreprises, cela dit, la compétition devrait désormais se faire avec le H200 de Nvidia. Cette version améliorée du H100, qui contient 141 Go de mémoire HBM au lieu de 80 Go, devrait être livrée au compte-gouttes aux fabricants de serveurs d’ici à cet été.

Enfin, l’un des points clés du succès d’un GPU est son écosystème logiciel. Les puces de Nvidia reposent sur les kits CUDA richement fournis. Celles d’AMD pèchent par leur absence de logithèque. Intel, qui promeut par ailleurs des compilateurs Open source pour les applications d’IA, annonce la disponibilité d’une pile complète de logiciels. Elle comprend des kits de développement, des APIs documentées pour tout faire (réunies en frameworks, par exemple pour faire du RAG), ainsi qu’une collection de modèles et d’applications d’inférence (chatbot et autres IA génératives) spécialement adaptés à son Gaudi3.

Caractéristiques techniques

Gravé comme tous les GPUs récents dans les usines du Taiwanais TSMC avec une finesse de 5 nm, Gaudi3 repose sur des circuits développés par la startup Habana Labs, qu’Intel a rachetée en 2019 pour 2 milliards de dollars.

La puce Gaudi3 est composée de deux circuits comprenant chacun 32 cœurs TPC (tous calculs), 4 cœurs MME (calculs matriciels) et 48 Mo de cache. Soit un total de 64 cœurs TPC, 8 cœurs MME et 96 Mo de cache, avec une bande passante globale de 12,8 To/s. On y trouve également huit circuits de mémoire HBM2e de 16 Go chacun. Soit un total de 128 Go avec une bande passante globale de 3,7 To/s vers les cœurs.

Comparativement, un H100 a 80 Go de RAM HBM3 pour une bande passante de 3,35 To/s vers les cœurs, un H200 devrait avoir 141 Go de RAM HBM3e en 4,8 To/s, un MI300X d’AMD dispose de 192 Go de RAM HBM3e en 5,3 To/s et le futur B200 devrait avoir également 192 Go de RAM HBM3e, mais, lui, avec une bande passante de 8 To/s vers les cœurs.

Chacun ayant une manière différente de regrouper les fonctions de calcul, il n’est pas pertinent de comparer les nombres de cœurs respectifs.

Dans les serveurs, la puce Gaudi3 existera, comme ses concurrentes, sous trois formes. Une carte PCIe 5.0 (16 canaux) HL-338 prendra place dans les serveurs classiques et offrira, pour communiquer en réseau, deux ports Ethernet RoCE en 400 Gbit/s chacun. Une carte mezzanine HL-325L au standard OAM (Open compute Accelerator Module) sera plutôt destinée aux hébergeurs qui fabriquent eux-mêmes leurs machines.

4 096 Gaudi3 en réseau

Dernier format, Une carte mère HLB-325, comprenant huit cartes HL-325L, permettra de proposer des nœuds de calcul autonomes. Les huit puces communiqueront ici entre elles sur une bande passante globale de 8,4 To/s, chacune via 21 ports Ethernet. Les 24 ports Ethernet 200 Gbit/s restants, présentés sous la forme de six connecteurs OFSP 800 Gbit/s seront destinés à la communication vers les autres machines du réseau, via une cascade de switches.

Il sera possible de mettre en réseau jusqu’à 512 cartes HLB-325, soit 4 096 GPUs Gaudi3. Comparativement, Nvidia annonce un maximum de 576 GPUs B200 capables de travailler ensemble sur un même calcul. Il reste possible de connecter d’autres nœuds au-delà de ces limites, mais la bande passante ne peut plus être répartie équitablement et des goulets d’étranglement se forment.

Chaque carte OAM HL-325L est donnée pour une enveloppe thermique de 900W, alors que la version PCIe HL-338 ne devrait pas dépasser 600W. Intel n’explique pas comment il parvient à consommer 300 W de moins sur la version PCIe, alors qu’elle est censée avoir exactement les mêmes caractéristiques et les mêmes performances. Chez Nvidia, les deux modèles se différencient par une mémoire HBM2e sur la version PCIe et HBM3 sur la version en puce autonome.