AWS Summit Paris 2024 : l’IA générative à tous les étages

Des annonces, des invités de marque, les premières expérimentations des clients… AWS a largement mis en avant l’IA générative lors de son événement parisien. Sans surprise, le géant du cloud espère pérenniser sa stratégie qui, pour l’heure, réclame d’importants investissements.

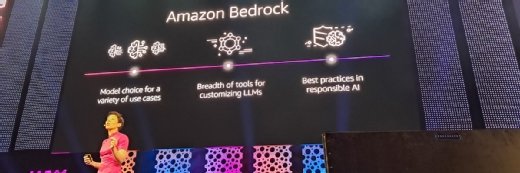

AWS annonce la disponibilité d’Amazon Bedrock dans sa région cloud française Paris. Cette annonce présentée lors de l’AWS Summit Paris 2024 accompagne l’arrivée de Mistral Large au sein de la suite, en sus de Mistral 7B et de Mistral 8X7B. L’arrivée de la collection Claude 3 Haiku et Claude 3 Sonnet est prévue au cours de cette semaine. En attendant, les clients pourront utiliser la famille de modèles Amazon Titan (Text Lite, Text Express, Multi-Modal Embeddings) et les modèles d’embedding de Cohere.

Amazon Bedrock, Mistral Large et Claude 3 débarquent sur AWS Paris

Pour l’heure, les tarifs d’Amazon Bedrock dans la région française ne sont pas disponibles. Les clients européens pouvaient déjà s’appuyer sur la région Francfort pour expérimenter les modèles d’IA générative de la suite AWS.

Il y a toutefois un intérêt certain pour le géant du cloud de présenter cette annonce au Palais des Congrès. La scène de l’IA parisienne est particulièrement effervescente. Encore une fois, Arthur Mensch, cofondateur et CEO de Mistral AI, était sur scène pour présenter la scale-up et les possibilités de sa plateforme. Thomas Wolf, cofondateur français et CSO d’Hugging Face a lui mis en lumière sa plateforme communautaire censée accueillir le plus de modèles ouverts possibles. Par ailleurs, l’Américain Tom Brown, cofondateur d’Anthropic et ancien chercheur chez OpenAI, est également monté sur scène pour présenter rapidement Claude 3.

Ces trois entreprises ont en commun de dépendre, tout du moins en partie, des fonds et des infrastructures d’Amazon Web Services. Elles utilisent les instances équipées des puces Trainium et Inferentia, mais surtout les instances P4 et P5, équipés de GPU Nvidia.

Pour Arthur Mensch, le cloud AWS est aussi « un canal de distribution particulièrement efficace ». De son côté, Tom Brown est très enthousiaste au fait que les clients français d’AWS puissent tester les modèles Claude. D’autant qu’Anthropic profite de financements importants de la part d’Amazon. Outre la puissance de calcul nécessaire à l’entraînement de ses modèles, l’éditeur voit un moyen de s’attirer la confiance d’un écosystème IT en place, de commercialiser plus simplement ses LLMs et de profiter des fonctions de sécurité du cloud, selon les propos de Tom Brown.

Des expérimentations prudentes, mais prometteuses

Malgré la grande quantité d’annonces autour de l’IA générative, les entreprises sont principalement dans des phases d’expérimentation ou lancent les premiers cas d’usage en production.

Par exemple, Air Liquide a mis en place une stratégie IA depuis 2018, mais elle ne s’est pas jetée sur l’IA générative. Le groupe préfère évaluer les cas d’usage potentiels à l’aide d’Amazon Bedrock dans un cadre de transparence, d’explicabilité et de confiance. Comme le rappelle Fabien Mangeant, Chief Data & AI Officer chez Air Liquide, le groupe est membre du consortium Confiance.ai dont les travaux ont porté sur des livrables consacrés à l’IA de confiance.

De même, TF1, qui vient de migrer une partie de sa chaîne de production sur AWS, a lancé plusieurs expérimentations, dont un chatbot interne installé sur une instance dédiée sur Azure et un autre consacré aux ressources humaines. Les deux entreprises prévoient d’étendre les cas d’usage. De son côté, Airbus présentait avec Accenture une expérimentation couplant CAO (Création assistée par ordinateur) et LLM (Large Language Model).

Lors d’une session, Vincent Dagoury, CTO de la Digital Commercial Platform (DCP) chez Axa, a évoqué l’usage d’Amazon Q et d’Amazon CodeWhisperer, des assistants de développement sur AWS et de génération de codes en vue de lancer prochainement la DCP qui doit étendre les services IARD de l’assureur.

Autant de raisons pour AWS de proposer « du choix » à travers Bedrock. Le service managé inclut plusieurs collections de modèles à la fois pour ne pas dépendre d’une seule technologie et pour répondre à différents cas d’usage, selon le fournisseur.

Mais avant de pouvoir déployer des LLM, il faut savoir maîtriser la couche de gestion de données, signale Mai-Lan Tomsen Bukovec, vice-présidente stockage et calcul chez AWS. « Les applications d’IA générative s’appuient sur les architectures de données existantes et les entreprises qui ont déjà adopté des architectures de données modernes sont en avance », vante-t-elle.

Il faut aussi anticiper la gestion de nouveaux types de données générées par les applications de GenAI : les embeddings, les événements en provenance de l’inférence des modèles et les checkpoints – c’est-à-dire les packages qui permettent d’exécuter les modèles.

En ce sens, Mai-Lan Tomsen Bukovec met en avant le fait qu’AWS propose à ses clients de déployer des LLM sur des hôtes EC2 dédiés, à partir de services managés ou des modèles infusés dans des applications. « Et nos clients utiliseront probablement les trois », envisage-t-elle lors de l’AWS Summit Paris.

Vient ensuite la problématique des coûts.

« Quand vous commencez à utiliser les modèles, vous ne vous préoccupez pas des coûts des modèles, mais dès que l’on approche de la mise en production, les entreprises s’intéressent à de plus petits modèles, moins chers », avance Tom Brown, cofondateur d’Anthropic. C’est également le pari pris par Mistral AI et Hugging Face.

Accélérer et reprendre les migrations vers le cloud

Tout le marché s’attend justement à cette entrée en production cette année.

« Depuis l’année 2024, nous observons les premiers cas d’usage entrés en production », affirme Julien Groués, directeur général d’Europe du Sud chez AWS. « Beaucoup de choses restent à faire », ajoute-t-il.

Pour l’heure, le marché IT s’accorde sur des suites de fonctionnalités peu différenciées, note Cyrille Chausson, responsable de recherche en Europe autour des stratégies de modernisations des applications et des services IT chez IDC et ex-rédacteur en chef du MagIT. De fait, beaucoup de modèles identiques et de fonctions similaires sont accessibles via les plateformes d’IA générative d’Azure, d’AWS et de Google Cloud.

Il s’agit de faire prendre conscience des prérequis aux déploiements des applications d’IA générative et de la nécessité d’investir davantage dans les services cloud. « Si les fondations techniques ne sont pas hébergées sur le cloud cible, y apposer des applications d’IA générative semble beaucoup plus difficile », signale Cyrille Chausson.

En clair, les promesses de l’IA générative sont aussi des invitations pour accélérer les migrations vers le cloud.

Au début du mois de février 2024, Brian Olsavsky, chief financial officer chez Amazon, observait lors de la présentation des revenus du quatrième trimestre 2023 une « ré-accélération des migrations existantes vers le cloud » après une phase d’optimisation des charges de travail en 2023, désormais en cours de ralentissement. L’IA générative n’est encore qu’une tendance secondaire, mais prégnante.

« Les clients sont également enthousiasmés par notre approche de l’IA générative », ajoutait Brian Olsavsky.

« Il est encore relativement tôt, mais les revenus s’accélèrent rapidement dans les trois couches [IaaS, PaaS, SaaS] et notre approche de la démocratisation de l’IA trouve un écho favorable auprès de nos clients ».

Pour AWS comme les autres fournisseurs, cela implique des investissements importants.

« Nous sommes encore en train d’élaborer nos plans pour l’année, mais nous prévoyons une augmentation des dépenses d’investissement, car nous augmentons la capacité d’AWS pour l’expansion des régions, mais surtout pour le travail que nous effectuons avec les projets d’IA générative », prévenait le CFO en février.

Des investissements qu’AWS entend transformer en bénéfices, tout comme l’ensemble de l’écosystème réuni au Palais des Congrès ce 3 avril.

Pas moins de 53 sur 150 sessions de la conférence parisienne étaient consacrées à l’IA et au machine learning, dont 36 se concentraient sur des services ou des projets d’IA générative.

Sur les stands de l’AWS Summit Paris 2024, l’IA et l’IA générative n’étaient pas seulement l’apanage de quelques startups ou stands de démonstration AWS. « 99,9 % des stands des sponsors, éditeurs et startups présentes l’affichaient de manière directe ou indirecte comme le sujet à ne pas manquer », écrit François Denis, Head of Cloud Advisory chez Wenvision, un cabinet de conseils, sur LinkedIn.