GTC 2024 : Nvidia dévoile son GPU Blackwell

La puce B200 succède à l’actuelle H100 et à la H200 dont les livraisons commencent à peine auprès de certains clients. Elle s’accompagne d’un nouveau réseau NVLink-5 depuis plus performant.

Nvidia profite de son événement annuel GTC 2024, qui se tient cette semaine à San José, dans la Silicon Valley, pour dévoiler ses nouvelles générations de composants serveur. Le GPU Blackwell, dans sa déclinaison commerciale appelée B200, serait 4 fois plus performant que l’actuel H100 sur les algorithmes de Machine learning (10 PetaFLOPS en FP8) et 30 fois plus sur l’inférence (utilisation d’un modèle d’IA préentraîné, soit 20 pétaflops en FP4).

« Entraîner un modèle avec 1 800 milliards de paramètres coûte l’utilisation de 8 000 GPUs H100 et 15 mégawatts de puissance électrique. On peut désormais effectuer ce même travail avec 2 000 GPUs B200 et 4 mégawatts », argumente, sur scène, Jensen Huang, le PDG de Nvidia.

Les différents chiffres présentés suggèrent que la consommation électrique d’un B200 serait 30 % supérieure à celle de l’actuel H100, soit environ 1 000 watts au lieu de 700. On note par ailleurs que le B200 est une puce bicéphale, comme le H200 auquel Nvidia ne le compare pas. L’existence à terme d’une version B100 ne comportant qu’un seul circuit, comme le H100, a été évoquée. Le B200 intègre 192 Go de RAM HBM3e, contre 96 Go sur le H100 et 141 Go sur le H200.

Les GPU de Nvidia sont conçus pour fonctionner en grappe. Le B200 bicéphale dispose à ce titre d’une bande passante réseau de 1,8 To/s, soit le double des 900 Go/s du H100 monocéphale. En l’occurrence, il s’agit de 18 ports entrants à 50 Go/s chacun (900 Go/s), plus autant en sortant.

Vient ensuite une nouvelle puce réseau NVLink-5 qui dispose de 72 ports à 50 Go/s, entrants ou sortants, soit une bande passante de 3,6 To/s par puce NVLink. Cette puce est capable d’identifier 8 GPUs sur chacun de ses ports (routables par des switches en cascade), soit un total de 576 GPUs pouvant fonctionner de concert.

Les quantités annoncées de Go/s sont sans doute à prendre avec des pincettes. Nvidia remplace parfois 50 Go/s par 400 Gbit/s, ce qui correspond bizarrement à un octet pour huit bits. Or, s’il est plus conventionnel d’exprimer la vitesse d’un réseau en bit/s, dès lors qu’il s’agit d’un réseau avec des possibilités de routage, chaque trame de données est forcément constituée d’un en-tête. Et celle-ci consomme de la bande passante utile pour des raisons purement fonctionnelles. Dès lors, en 400 Gbit/s, par exemple, le débit est nécessairement inférieur à 50 Go/s (il devrait plutôt se situer aux alentours de 40 Go/s).

Du GPU au datacenter Nvidia

À partir de ces puces, Nvidia a mis au point toute une hiérarchie de configurations serveur. On trouve ainsi la carte de calcul GB200 qui comprend deux GPU B200 et un processeur Grace, soit l’implémentation d’un ARM Neoverse V2 contenant 72 cœurs, conçu par Nvidia. Cette carte totalise 864 Go de RAM.

Deux cartes GB200 pourront être réunies dans un nœud de calcul au format rack 1U appelé GB200 Superchip Compute Tray. Celui-ci, qui totalisera 80 pétaflops de puissance en inférence et 40 PetaFLOPS en Machine learning, sera forcément refroidi par liquide.

Également proposé en boîtier 1U, le switch NVLink Switch Tray intégrera quatre puces de routage NVLink-5, pour router en façade arrière une bande passante agglomérée de 14,4 To/s.

Nvidia propose d’assembler dans une seule étagère Rack dix-huit Compute Tray et neuf modules switch NVLink-5. Une telle configuration serait baptisée GB200 NVL72. Il sera possible d’assembler huit étagères GB200 NVL72 pour former un cluster DGX de nouvelle génération, avec 576 GPUs, 288 processeurs Grace et 240 To de mémoire.

Ces clusters sont connectables à des baies de stockage et des serveurs x86 plus conventionnels. Nvidia propose à cet effet deux nouveaux switches. Le Spectrum-X800 dispose de 64 connecteurs Ethernet en 800 Gbit/s. Le Quantum X-800 offre 144 connecteurs Infiniband, également en 800 Gbit/s.

Une puce deux fois plus grosse avec des circuits d’optimisation

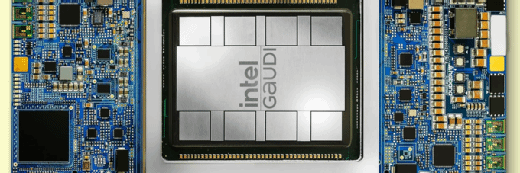

Concernant le design de la puce B200, on note qu’elle est gravée avec une finesse de 4 nanomètres, comme les derniers H100 et H200. Contentant deux circuits, elle est de fait deux fois plus grosse qu’un H100. Les deux circuits communiquent entre eux à la vitesse de 10 To/s et avec leur mémoire HBM3e à la vitesse de 8 To/s.

Il se dit dans les couloirs de la conférence GTC 2024 qu’une version ultérieure reposant sur le même design pourrait voir la mémoire grimper à 256 Go avec une bande passante de 13,3 To/s.

La véritable nouveauté se situe dans la présence de circuits Transformer Engine améliorés qui permettent d’exécuter les calculs avec une précision FP4, contre FP8 précédemment. Ce simple changement suggère une multiplication par deux des données analysées. Et comme il y a deux circuits au lieu d’un seul, on comprend mieux pourquoi Nvidia annonce une multiplication par quatre des performances.

Accessoirement, de nouveaux circuits Decompression Engine permettent d’ingérer dans les GPU des données compressées qui, parce qu’elles sont moins lourdes, transitent plus rapidement entre les GPUs ou depuis le stockage.

Enfin, des circuits baptisés RAS Engine font leur entrée pour vérifier à la volée les potentielles erreurs de lecture/écriture ou incohérences dans les caches. Ces circuits sont notamment capables de prédire où arriveront les prochaines erreurs, de sorte à éviter une latence lors des corrections ultérieures.

Quant au fait que le B200 serait 30 fois plus performant que le H100 sur l’inférence, la raison serait plutôt à chercher dans la nouvelle version de NV-Link. Le doublement des ports de communication servirait mieux des calculs répartis en étoile entre les GPUs. Revers de la médaille, la configuration en étagère GB200 NVL72 contiendrait plus de trois kilomètres de câbles et pèserait 1,5 tonne.