Stockage : NGX propose des baies presque européennes

Le fabricant turc revendique proposer des baies de disques aussi performantes que celles des marques américaines, mais conçues, expédiées et améliorées à quelques heures seulement de Paris.

Une alternative aux NetApp, Vast, Infinidat et autres baies de stockage américaines. Tel est l’argument que met en avant le fabricant presque européen NGX, pour promouvoir ses équipements utilisables par les machines du réseau, soit en NAS (NFS ou SMB), soit en mode bloc (FC ou iSCSI).

NGX est une société turque qui revendique vendre essentiellement en Europe ses produits adaptés à tous les besoins de performances : les données sont stockées sur des disques durs après être passées par plusieurs niveaux de cache – sur SSD, sur modules Intel Optane et en RAM – dont la quantité est attribuable selon les applications.

« Les banques utilisent nos produits comme des SAN pour leurs bases de données et comme des NAS pour leurs développeurs. Les hébergeurs se servent du mode bloc pour les images-disques des machines virtuelles et du mode fichiers pour stocker les vidéos. Les instituts de recherche font plutôt du mode fichier pour leurs VMs sous OpenStack et du mode bloc pour volumes partagés en Lustre entre les nœuds de leurs clusters de calcul », explique Ali Kemal Yurtseven, le directeur général de NGX.

« Nous n’allons pas prétendre que nous sommes moins chers que les marques de stockage américaines. Mais notre production est locale, réactive, sans problème d’acheminement jusqu’à nos clients européens. Nous sommes ouverts aux demandes d’améliorations et, d’ailleurs, nous pensons que nos baies sont à présent parmi les plus simples à utiliser. Elles sont opérationnelles cinq minutes après avoir été déballées », argumente-t-il.

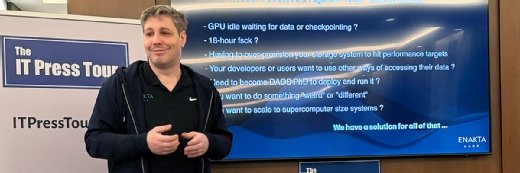

Rencontré à l’occasion d’un événement IT Press Tour centré sur les acteurs européens du stockage, Ali Kemal Yurtseven a expliqué au MagIT qu’il cherchait actuellement des revendeurs en Europe de l’Ouest, après avoir noué de nombreux contrats au Moyen-Orient.

Un usage intensif des caches

Techniquement, les baies de NGX sont morcelées. Sur le réseau, des nœuds de partage (les « contrôleurs ») se répartissent les accès et communiquent les données à des nœuds de stockage, auxquels ils sont tous reliés via un switch Ethernet RoCE qui transporte un protocole Infiniband. Du point de vue des contrôleurs, les nœuds de stockage sont comme leurs SSD internes. Et, ce, que ces nœuds de stockage soient remplis de SSD ou de disques durs.

Cette architecture permet de faire croître tel ou tel composant selon les besoins : plus de contrôleurs pour maximiser les accès parallèles, plus de tiroirs de SSD pour maximiser la vitesse, ou plus de tiroirs de disques pour maximiser la capacité. Selon NGX, il est par exemple possible de se doter de 20 Po de stockage en ne déployant que deux contrôleurs. Chaque contrôleur communique ses données sur le réseau à la vitesse de 9 Go/s et avec une latence de l’ordre de la milliseconde, que ce soit via des liens Ethernet 100 Gbit/s ou FC 32 Gbit/s.

Les contrôleurs font un usage intensif de leur RAM et de modules Optane pour stocker les métadonnées qui permettent de retrouver plus rapidement les blocs de données. En l’occurrence, un volume ne sera pas attribué à un disque ou un SSD dans un tiroir, mais morcelé entre plusieurs tiroirs afin de limiter la latence. De plus, la modification d’un bloc va créer un nouveau bloc à un endroit libre, puis effacer le bloc précédent quand il y aura suffisamment de temps de calcul disponible. Ce système fait aussi office de RAID ; il nécessite la présence d’au moins trois nœuds de stockage.

Parmi les autres fonctions des contrôleurs, citons la compression, la déduplication et le Thin provisionning qui se font tous en temps réel. On trouve aussi des fonctions de snapshots.

Du côté des nœuds de stockage, ceux composés de disques durs intègrent un cache sur des SSD en SAS, tandis que ceux qui contiennent des SSD SAS ont un cache sur des SSD NVMe. Les écritures passent d’un cache à l’autre, tandis que le système évalue les blocs qui doivent demeurer dans un type ou l’autre de stockage, selon l’application utilisée et la probabilité que ces blocs aient besoin d’être souvent relus.

Bientôt du SDS, du NVMe-oF et de l’objet

Depuis qu’il a été fondé en 2015 à Ankara, NGX aurait vendu 200 clusters de stockage et son chiffre d’affaires annuel tutoierait à présent les 20 millions d’euros.

NGX explique surtout avoir de nombreux projets dans ses cartons. Sous peu, il déclinera sa solution sous une forme uniquement logicielle – un SDS en somme – potentiellement utilisable depuis un cloud. « Dès le début de cette année 2023, vous nous trouverez chez AWS, Amazon ou Google », promet Ali Kemal Yurtseven.

Plus tard cette année, NGX devrait commercialiser une version de son offre qui supporte d’être utilisée comme un SAN NVMe-over-Fabrics (NVMe-oF). Il s’agira sans doute de NVMe/TCP, pour les déploiements en Ethernet, puis de NVMe/FC, pour ceux utilisant un réseau Fiber Channel. Basé sur des bibliothèques fournies par Intel, ce nouveau protocole pourrait s’accompagner de pilotes CXL, lesquels permettraient aux clusters NGX d’aller chercher de la mémoire cache ailleurs sur le réseau.

Enfin, la solution devrait bientôt intégrer directement un fonctionnement en mode objet. Pour l’heure, les déploiements de baies NGX qui supposaient un accès S3 aux données s’accompagnaient de passerelles S3 fournies par MinIO.