IA : Nvidia passe des composants aux environnements

Reconnaissance du langage, jumeaux numériques, automobile : Nvidia affiche des ambitions dans l’intelligence artificielle qui vont désormais au-delà de la simple fourniture de GPUs.

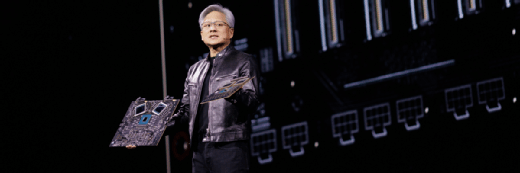

La conférence GTC 21 de Nvidia a été l’occasion du constructeur de démontrer ses ambitions en termes d’intelligence artificielle. Jensen Huang, fondateur et PDG de Nvidia, a présenté Jarvis, un moteur de deep learning dédié à la reconnaissance du langage naturel. Avec l’aide des GPUs du constructeur, Jarvis retranscrit et traduit le langage naturel en cinq langues, dont le français. Son taux de reconnaissance des langages – issu d’un entraînement sur 60 000 heures de conversation et 1 million de pages de texte – serait de 90 %. Surtout, il est possible de paramétrer Jarvis pour lui donner un semblant d’émotions artificielles : accueillir avec un ton avenant un client venant faire une réclamation, ou adopter un ton insistant quand il s’agit de vendre un produit.

Intrinsèquement, les GPUs, dont Nvidia est le spécialiste, sont mieux adaptés à l’IA de par leurs capacités en calculs parallèles, bien supérieures à celles d’un processeur généraliste. Et Nvidia l’a non seulement compris, mais a réussi à le mettre en œuvre. Il suffit de regarder le Top 500, le palmarès des supercalculateurs : au classement de juin 2020, huit des dix plus puissants ordinateurs de la planète étaient accélérés par les puces du constructeur. Rien d’étonnant dès lors, que Nvidia prolonge ses solutions matérielles par des développements logiciels.

L’automobile, une cible à privilégier

Le marché de l’automobile est une autre cible des ambitions de Nvidia en matière d’IA. Sur deux points. Primo, la création de jumeaux numériques. Autrement dit, concevoir une usine entière sur ordinateur avant de la construire réellement. BMW a fait une démonstration de cette technologie.

Deuxio, la configuration des véhicules autonomes. Sur ce point, Nvidia a présenté une expérience menée avec Mercedes de taxis robotisés, c’est-à-dire sans chauffeur. Dans les deux cas, ces projets reposent sur Omniverse, l’environnement de développement dédié aux GPU. Omniverse se veut l’univers collaboratif de Nvidia, exploitable dans n’importe quel secteur, et sensible aux paramètres physiques. Il est de fait tout autant capable de simuler des usines que de rassembler des informations routières (provenant d’autres véhicules par exemple).

« L’industrie automobile va devenir entièrement programmable, avec des logiciels créés par tous les constructeurs. Elle va s’appuyer sur les jumeaux numériques, sur la réalisation de nouvelles cartes routières interactive. Avec les taxis robotisés, ce sont aussi les camions qui sont autonomes. Il y a 20 ans, c’était de la science-fiction. Il y a 10 ans, c’était un rêve. Aujourd’hui, nous allons le vivre », prédit Jensen Huang.

Développer l’IA pour vendre plus de composants

Derrière l’offre logicielle, il y a l’idée d’un cercle vertueux : Nvidia mise sur les développements réalisés avec ses outils pour vendre au marché de l’automobile des capteurs qui fonctionnent sur ses GPUs. Le constructeur cite par exemple l’aide à la conduite : la reconnaissance des panneaux permettrait d’indiquer au véhicule ou au conducteur la direction à suivre. Nvidia prévoit à ce titre une nouvelle puce, le DRIVE Atlan, un SoC (System-on-a-chip) qui s’appuie sur des cœurs ARM.

Pour réaliser ses ambitions en matière d’IA, Nvidia a pour l’heure mis à jour ses serveurs à base de GPU. Les derniers clusters Superpod embarquent désormais jusqu’à 140 systèmes DGX A100, chacun pouvant comporter huit GPU A100. En entrée de gamme, les postes DGX Station A100 sont désormais disponibles à la location, moyennant 9 000 $/mois. Pour rappel, la puce A100 intègre directement des fonctions de calcul matriciel, dédiées à l’intelligence artificielle.