Arjuna Kodisinghe - Fotolia

Coldago prédit l’arrivée d’une classe de stockage HPC en entreprise

Le bureau d’études publie la cartographie des fournisseurs de stockage capables de répondre aux entreprises dont les applications ont aujourd’hui besoin des mêmes I/O que les projets scientifiques.

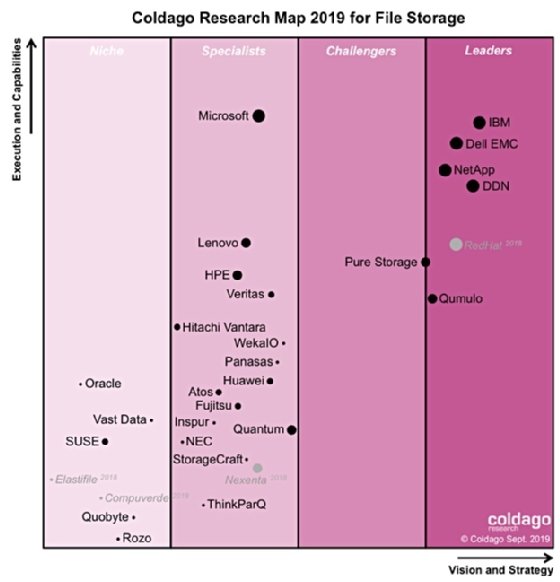

Il existe désormais un palmarès des fournisseurs de systèmes de fichiers pour entreprises. Le bureau d’études Coldago Research a dressé un graphique – une « Map » dans la nomenclature des analystes – qui les classe selon leur importance sur le marché, la pertinence de leur stratégie et les moyens à leur disposition pour tenir leurs promesses. Tout l’intérêt de cette étude est qu’elle recense toutes les solutions qui fonctionnent en cluster, alors que les autres analystes classent encore de nombreux systèmes de ce type dans la niche des supercalculateurs.

« Le HPC est de plus en plus utilisé dans l’entreprise. On voit ainsi des fournisseurs de solutions HPC comme Lustre et GPFS qui quittent le monde scientifique pour s’adresser aux métiers », indique au MagIT Philippe Nicolas, l’analyste responsable de l’étude.

« L’utilisateur de ces solutions est à présent un commercial qui a besoin d’une puissance de calcul qui était historiquement réservée à des entités de recherche. Prenons l’exemple de l’automobile. Il y a là des gens qui font de la simulation et qui ont désormais besoin d’autant d’I/O que les supercalculateurs. Techniquement, il s’agit de HPC, mais l’application sort du giron scientifique », illustre-t-il.

L’étude de Coldago met aussi en lumière le phénomène inverse : l’utilisation de NAS distribués, cette fois-ci pour le supercalcul scientifique. « C’est une tendance que nous avions identifiée au cours de cette année et qui vient d’être confirmée par le dernier IO500, le palmarès qui classe le stockage des supercalculateurs selon la quantité d’I/O. À partir de la 18e place, on se rend compte que le campus scientifique de Janelia a déployé, sur un projet, le NAS distribué de Vast Data et, sur un autre, celui de Qumulo. »

« C’est-à-dire que grâce aux disques NVMe, grâce à la connectique NVMe-over-Fabrics, il y a aujourd’hui des approches NFS qui sont suffisamment performantes pour éviter de partir sur une architecture complexe, comme le sont les solutions Lustre ou Matrix de WekaIO. »

Un classement par fournisseurs, car les entreprises factorisent leurs projets

On notera que Coldago a préféré classer les fournisseurs, plutôt que les produits. « La raison est que les entreprises vont avoir plusieurs projets, auxquels vont répondre des systèmes de fichiers différents et qu’elles ont tout intérêt à factoriser leurs achats », explique Philippe Nicolas.

Et de citer quelques exemples : si Dell EMC met bien valeur dans son catalogue sa solution Isilon, cela ne l’empêche pas de commercialiser aussi les systèmes Lustre, BeeGFS, ou encore Parallel-NFS. Lenovo, de même, n’a pas de système de fichiers distribué en propre, mais propose Lustre, Spectrum Scale (ex-GPFS) et, aussi, Parallel NFS.

Par le jeu du nombre de solutions au catalogue, des acteurs comme IBM ou DDN se retrouvent ainsi aux meilleures places de l’étude, au détriment de grands noms du stockage comme HPE ou Pure Storage.

« IBM est situé tout en haut à droite de notre Map, car nous agrégeons désormais son potentiel à celui de Red Hat, qu’il a racheté. Il en va de même pour DDN qui obtient un très bon score puisqu’il a acquis cette année Tintri et Nexanta. Ainsi, DDN pourrait par exemple proposer son offre historique EXAscaler à un département de simulation et Tintri à un autre qui utilise des applications en machines virtuelles. »

Évaluer la vision, les moyens et l’importance sur le marché

La Map de Coldago représente chaque fournisseur avec un point de différente taille et les place à la croisée de leurs scores en matière de vision (axe des abscisses) et de capacité à l’exécuter (axe des ordonnées). Le score de la vision est calculé selon différents facteurs. Coldago prend d’abord en compte l’historique de l’entreprise, celui de ses fondateurs, les fonds qu’elle a levés.

Ensuite, le bureau a analysé leur capacité à mettre leur produit sur le marché : quel est le poids des alliances, des intégrateurs, des revendeurs, etc. Enfin, Coldago a évalué l’intérêt des cas d’usage proposés, ainsi que la fraîcheur et la richesse fonctionnelle des produits.

Le score de la capacité est calculé selon les ressources mises à disposition pour développer le produit et dans quelle mesure ces moyens présentent un intérêt stratégique. « Certains fournisseurs peuvent avoir une capacité très importante, mais une vision limitée. C’est par exemple le cas de Microsoft qui est l’un des principaux contributeurs du système de NAS SMB/CIFS, mais qui paraît assez en retard sur les efforts commerciaux », explique Philippe Nicolas. « À l’inverse, WekaIO a une belle vision, mais reste une toute petite société, avec un produit encore assez pauvre sur les fonctions de NAS NFS. »

La taille du point qui indique la position de chaque acteur est fonction quant à elle de la visibilité sur le marché. Coldago a pris en compte la perception d’un acteur par ses partenaires, par les utilisateurs et par les revendeurs. Ainsi que, bien entendu, le nombre de déploiements : un acteur récent a nécessairement un point de petite taille. À ces critères d’accélération s’en ajoutent d’autres, de décélération ; il s’agit typiquement des désinstallations d’un système de fichiers par les entreprises pour le remplacer par celui d’un autre fournisseur.

« Oracle par exemple, a annoncé l’arrêt des baies Flash Pillar Data Systems, ce qui signifie qu’ils ne croient plus à ce stockage-là. Les produits que nous avons retenus les concernant sont les appliances ZFS. Leur adoption est assez limitée. Et cela est paradoxal parce qu’Oracle a pourtant les moyens de vendre bien mieux ces produits. On comprend que ce n’est pas un axe stratégique du fournisseur : Oracle ne parle plus de stockage durant ses OpenWorld. D’ailleurs, ils avaient racheté Sun qui était détenteur de Lustre, mais ils s’en sont débarrassés », juge avec sévérité Philippe Nicolas.

Des agents pour paralléliser les écritures… en attendant Parallel NFS

Coldago se défend en revanche de donner un classement des systèmes de fichiers eux-mêmes. « Chacun bénéficie de développements tels, qu’un tel sera en avance sur les autres pendant six mois, puis ce sera au tour d’un autre, etc. », prévient Philippe Nicolas. En revanche, il note que certains critères deviennent fondamentaux.

Il y a évidemment la richesse fonctionnelle de ces systèmes de fichiers sur les services de données. On parle ici des moyens de protection – au-delà de la simple réplication, on pense surtout à l’erasure coding – mais aussi du tiering automatique, de la faculté de gérer du PRA avec une extension S3, ou encore de la prise en charge d’au moins trois ou quatre types de métadonnées. Philippe Nicolas cite les métadonnées système associées aux fichiers (les dates, notamment), celles qui se trouvent dans le fichier selon sa nature, ou encore celles ajoutées par les applications ou les utilisateurs.

« Mais le premier critère important aujourd’hui pour les entreprises est le type de parallélisme, car il est la clé pour servir les utilisateurs qui ont besoin d’un débit fort. La tendance est de décliner le modèle parallèle de Lustre sur des architectures NVMe-over-Fabrics qui supportent un tel fonctionnement. »

En l’occurrence, les systèmes de fichiers cités dans l’étude de Coldago sont de deux types : ceux qui exposent leurs contenus en NFS ou SMB/CIFS directement aux serveurs d’applications et ceux, plus performants, qui fonctionnent avec un agent installé sur ces serveurs (ou sur les postes) pour consommer le système de fichiers distribué, à la manière de Lustre.

Dans tous les cas, on trouve aussi un serveur de métadonnées, qui indexe les contenus, et des serveurs de données qui contiennent l’information et l’exposent via plusieurs protocoles (NFS, SMB/CIFS...). Lorsqu’une machine cliente souhaite accéder aux données, elle commence par interroger le serveur de métadonnées, lequel renvoie un pointeur vers les serveurs qui contiennent les données à lire. Néanmoins, notre Philippe Nicolas, les systèmes avec agent sont pour l’heure plus performants.

« L’intérêt d’un système de fichiers distribué est de gagner en débit en lecture, comme en écriture, en accédant à des fichiers qui sont répartis sur tous les serveurs de données. Lorsqu’il y a un agent, celui-ci se charge au niveau de la machine cliente de découper le fichier en morceaux et d’envoyer chacun de ceux-ci, en parallèle, sur plusieurs serveurs. C’est une différence fondamentale avec un serveur NFS, où l’ensemble des fichiers à écrire arrive sur une seule tête », décrit Philippe Nicolas.

Entre les lignes, on comprend que le système Isilon de Dell EMC, par exemple, accuse un certain retard technologique selon les critères de Coldago : s’il permet bien de paralléliser les lectures, les écritures s’y font en revanche toutes sur une seule tête, partagée en NFS.

Philippe Nicolas prédit néanmoins le développement du protocole Parallel NFS en guise d’alternative. « Parallel NFS est présent dans la dernière version de NFS. Il permet aux machines clientes de communiquer sans agent avec plusieurs serveurs de données en lecture comme en écriture. Son immense intérêt est d’être standard, c’est-à-dire directement intégré aux serveurs d’applications. Il est regrettable qu’il ne soit pas encore beaucoup utilisé », conclut-il, en laissant penser que cela pourrait bientôt changer.