IBM veut industrialiser la détection des défauts de l’AI

Ce service se repose sur une série d’algorithmes open source qui identifie et score les biais des modèles d’intelligence artificielles et permet de les corriger. Il rend explicable l’inexplicable…de façon industrialisée.

Une tour de contrôle algorithmique. C’est ainsi que pourrait être présenté IBM AI Trust and Transparency, un service que Big Blue a fait atterrir la semaine dernière sur son cloud. Ce service, qui prendra à terme le nom officiel d’AI OpenScale au catalogue du groupe, vise à restaurer la confiance des entreprises en l’intelligence artificielle afin d’en accélérer les usages et l’intégration dans les SI des entreprises. En somme, il s’agit là d’en finir avec ces « boîtes noires », comme l’indique lui-même IBM. Ces boîtes noires sont les modèles d’AI développés à partir de technologies telles que Watson, AzureML, AWS SageMaker ou encore SparkML (open source) et Tensorflow (open source).

Car aujourd’hui, l’intelligence artificielle, et l’ensemble des technologies qui peuplent ce concept (Cognitif, Machine Learning, Deep Learning) font plutôt douter les entreprises. Selon les chiffres d’IBM, si, certes, elles sont 94 % à penser que l’AI est importante pour leur avenir, elles ne sont que 35 % à avoir confiance dans les indicateurs que leur remontent ces opaques AI. Doute et méfiance sont donc encore bien ancrés dans plus de 60 % d’entre elles. Ce qu’IBM considère bien comme un frein et « une barrière » à l’usage de l’intelligence artificielle - et de Watson - , indique Jean-Philippe Desbiolles, vice-président Watson pour la France.

Evidemment, l’opacité de la mécanique AI n’est pas nouvelle. Mais jusqu’alors, le travail qui consistait à décortiquer les prises de décision issues de l’AI étaient manuelles et donc artisanales, confie le responsable. Il faut également comprendre qu’elles étaient difficilement applicables. Mais pour passer l’AI à l’échelle, il convient d’industrialiser ces processus, poursuit-il.

Là est la démarche d’IBM avec ce service. Concrètement, celui-ci apporte outillage et méthode de data science pour observer le chemin emprunté par les données, embarquées dans les moulinettes algorithmiques. Il permet d’abord d’expliquer en temps réel les modèles en place pour comprendre comment les décisions ont été prises. Puis - et là est la clé du service -, ce service détecte les « biais » en temps réel, souligne Jean-Philippe Desbiolles, et émet des recommandations pour justement les minimiser. « Ces biais sont qualifiés, scorés et des solutions pour résoudre le problèmes sont proposées. »

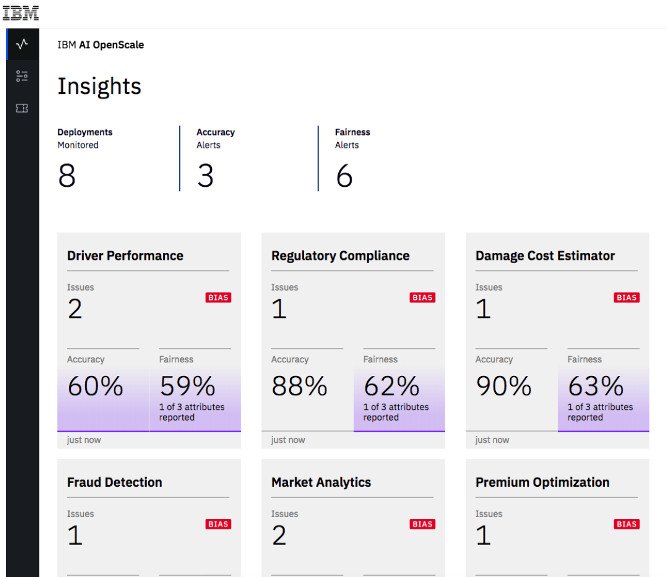

« On identifie le biais et on identifie les données qui posent problème », ajoute-t-il. Cela est réalisé via un modèle statistique. Le biais en question peut par exemple porter sur une sur- ou sous-représentation d’une population. Le service explique comment l’AI est arrivée à cette décision, affiche les critères pris en compte et identifie les éventuels écarts qui « ne sont pas statistiquement justifiables ». Les résultats de ces analyses sont ensuite livrés sous la forme de tableaux de bord pour permettre aux métiers de les utiliser. Ces tableaux de bord permettent également de contrôler la bonne santé de l’ensemble en observant par exemple les performances de l’exécution des modèles.

Ce n’est pas une boîte noire qui analyse une autre boîte noire

Des algorithmes qui en observent d’autres en somme ? Oui, mais ceux qui observent et sont donc à la base des moteurs d’AI OpenScale (AI Trust and Transparency), font justement partie d’une série d’outils algorithmiques et de bibliothèques développés par IBM Research et versés à la communauté open source sous le nom de AI Fairness 360. Cette boîte à outils est également composée de bonnes pratiques et de tutoriels à destination du monde académique, scientifique et de la data science. L’idée est de leur permettre d’intégrer, dès la conception des modèles d’AI, cette notion de détection de biais, résume Big Blue.

IBM s’y appuie donc pour son service cloud AI OpenScale qui vient livrer ce degré de services, de BI et d’industrialisation pour au final, rendre consommable cette détection des biais.