IA : Avec son Apollo 6500 Gen10, HPE fournit une alternative au DGX-1 de Nvidia

HPE vient de dévoiler le serveur Apollo 6500 Gen10, un système capable d'accueillir jusqu'à 8 accélérateurs Tesla V100 et optimisé pour les applications de machine learning, d'IA et de calcul intensif. Plus performant que le DGX-1 de Nvidia, l'Apollo 6500 Gen10 en reprend les principes d'architecture.

Dans le cadre d’une annonce plus large sur le machine learning et l’intelligence artificielle, HPE a dévoilé aujourd’hui son serveur Apollo 6500 Gen 10, une machine haut de gamme optimisée pour les applications de calcul, de machine learning et d’IA.

HPE positionne son dernier-né comme la machine idéale pour des applications d’apprentissage de machine learning, mais aussi pour des applications de reconnaissance du langage, d’analyse génomique ou de calcul à haute performance.

Le lancement de la machine est complété par l’arrivée d’une gamme de services PointNext visant à accompagner les entreprises dans la mise en œuvre de technologies analytiques avancées, à base d’IA et d’apprentissage machine.

Une architecture calquée sur celle du DGX-1 de Nvidia

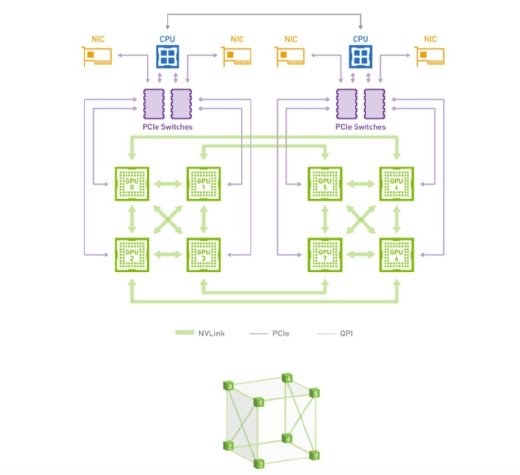

Architecturalement, l’Apollo 6500 Gen10 reprend les canons de design du DGX-1, l’appliance de calcul à hautes performances conçues par Nvidia autour de ses cartes accélératrices Tesla P100 et V100.

Le serveur d’HPE s’appuie sur une architecture en tous points similaire à celle du DGX-1. Comme lui, il est capable d’accueillir jusqu’à 8 accélérateurs Tesla P100 ou V100 au format Mezzanine (Module SXM).

Comme Nvidia dans son DGX-1, le constructeur californien dirigé par Antonio Neri a semble-t-il groupé les GPU par cluster de quatre, reliés chacun à un CPU par le biais de commutateurs PCIe. Les GPU eux-mêmes sont configurés dans une topologie de cube hybride maillée et reliés entre eux par des liens NV-Link 2.0.

Cette configuration a le double mérite d’optimiser la bande passante entre les GPU et de soulager les liens PCIe tout en maximisant la performance. Les échanges entre GPU n’ont en effet pas à transiter via le bus d’interconnexion entre CPU lorsque les membres des deux clusters de GPU doivent échanger entre eux.

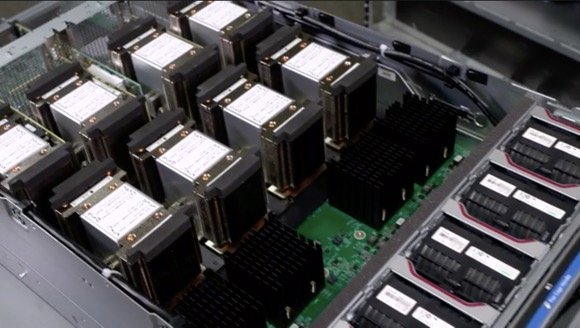

L'Apollo 6500 Gen10 peut accueillir jusqu'à 8 GPU (les 8 GPU à gauche et les 4 commutateurs PCI au centre)

L'Apollo 6500 Gen10 peut accueillir jusqu'à 8 GPU (les 8 GPU à gauche et les 4 commutateurs PCI au centre)

Une machine optimisée pour la performance

Moins dense que le DGX-1, l’Apollo 6500 Gen10 se présente sous la forme d’un châssis de 4U (contre 3U pour le DGX-1), mais sa partie compute est bien plus musclée que celle de Nvidia. La machine s’appuie ainsi sur deux Xeon Scalable Platform de dernière génération, contre deux Xeon E5 v4 pour le DGX-1.

Autre atout de la machine d’HPE, sa partie stockage est bien plus musclée puisqu’au lieu des 4 SSD du DGX-1, HPE propose 16 emplacements pour SSD dont 4 au format NVMe. De quoi alimenter la machine en données ou servir de buffer rapide de très grande capacité.

La connectivité est aussi plus souple. Là où Nvidia a fait le pari de l’utiliser qu’Infiniband pour la connectivité externe, HPE propose le support d’Infiniband (EDR), d’Intel OmniPath et de l’Ethernet à 100 Gigabit.

Toujours côté matériel, HPE a prévu plus de marge que Nvidia en matière d’alimentation, puisque sa machine est capable d’accueillir 4 alimentations de 2200W contre 4 alimentations de 1600W pour Nvidia. Cette générosité permet le support de 2 puces Xeon avec un TDP de 165W (c’est à dire les plus performants des Xeon SP Gold et Platinum avec 28 cœurs)

Un design loin des canons du genre

Le tiroir 1U inférieur de l'Apollo 6500 Gen10 accueille les CPU et la mémoire

Le tiroir 1U inférieur de l'Apollo 6500 Gen10 accueille les CPU et la mémoire

Physiquement, le design de la machine est loin d’être académique puisque sur l’ensemble des 4U, le tiroir 1U inférieur du châssis est occupé par la carte mère serveur, ses deux CPU ainsi que les quatre alimentations positionnées en frontal du serveur.

Ces blocs d’alimentation sont reliés à l’arrière du serveur par un arsenal de câbles d’alimentation mâle/femelle assez peu orthodoxe. La partie mâle des câbles s’insère dans les alimentations et les câbles courent à l’intérieur du châssis. À l’arrière de ce dernier, deux encoches permettent de faire sortir les câbles en question afin d’exposer leur partie femelle et permettre le raccordement à des PDU.

La face avant du serveur Apollo 6500 Gen10 avec ses 4 alimentations et ses rallonges mâle/femelle

La face avant du serveur Apollo 6500 Gen10 avec ses 4 alimentations et ses rallonges mâle/femelle

déportant le raccordement électrique à l'arrière du serveur (ce qui permet d'avoir une ventilation de l'avant

La carte serveur accueille aussi 4 ports Gigabit Ethernet et dispose d’un emplacement pour carte PCIe Gen3 16x (pleine hauteur, demi-largeur).

Les 3U supérieurs accueillent une carte fille servant de support aux 8 accélérateurs — et à leurs radiateurs massifs — ainsi qu’aux 4 commutateurs PCIe reliés par paire aux deux CPU sous-jacents.

Ils hébergent également les 16 emplacements de stockage 2,5 pouces ainsi que 10 ventilateurs chargés de refroidir l’ensemble. Dans cette partie supérieure, on trouve aussi 4 emplacements pour cartes PCIe (utilisés notamment pour la connectique réseau Infiniband, OmniPath ou Ethernet).

L’ensemble est validé avec la plupart des distributions Linux du marché (Red Hat, SUSE, CentOS) et peut délivrer jusqu’à 125 TFlops de performance en calcul simple précision, selon les données publiées par HPE.