Red Hat ajoute le tiering et l'erasure coding à Intank Ceph

Moins de trois mois après le rachat d'Inktank, le principal développeur de Ceph, Red Hat dévoile la version 1.2 avec le support de l'erasure coding et du tiering de données.

Moins de trois mois après l’annonce du rachat d’Inktank, Red Hat a annoncé en juillet la sortie de la version 1.2 d’Inktank Ceph Enterprise (ICE), une nouvelle mouture de sa solution de stockage distribuée qui inclut le support de l’erasure coding, du tiering ainsi que de nouveaux outils d’administration de cluster. Red Hat ICE 1.2 s’appuie sur la dernière version dite « Firefly » du code open source de Ceph.

Inktank Ceph Enterprise est présenté par Red Hat comme la solution de stockage idéale pour fournir des services de données en mode objet et en mode bloc pour les cloud OpenStack, et devrait pour cet usage être désormais préféré à Red Hat Storage (ex Gluster-FS), l’autre solution de stockage distribuée libre de l’éditeur.

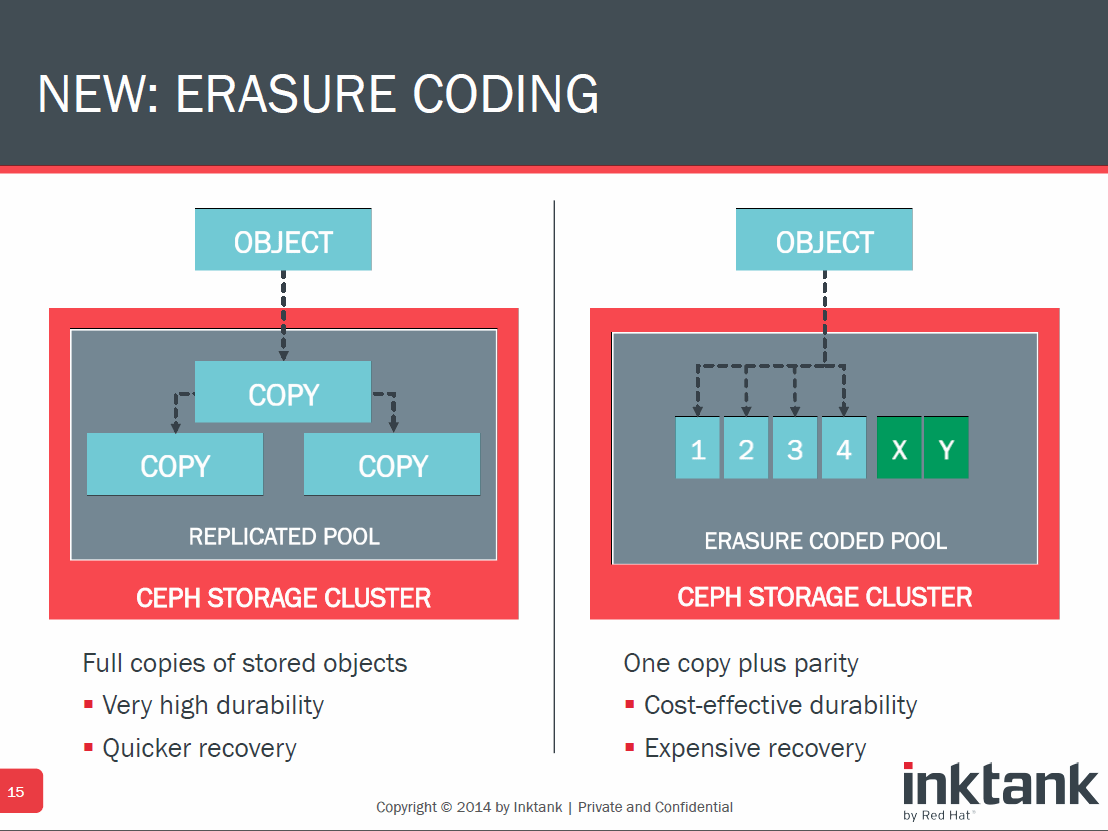

L'erasure coding pour réduire les coûts de stockage

Selon Dan van der Ster, un administrateur stockage du Cern, à Genève, le support de l’erasure coding est une fonction importante de la nouvelle mouture : « C’est la seule façon de construire un cluster durable et économique à l’échelle du Pétaoctet » a indiqué van der Ster en réponse à des questions envoyées par email. "Mais les calculs compliqués [qu’implique l’erasure coding] ont aussi pour conséquence un impact important sur la performance. C’est pourquoi nous sommes très intéressés pour tester la nouvelle fonction de tiering entre pools de données de Ceph, pour voir si la combinaison entre l’erasure coding et le tiering est adaptée à nos cas d’utilisation en mode bloc et pou r nos jeux de données physiques. »

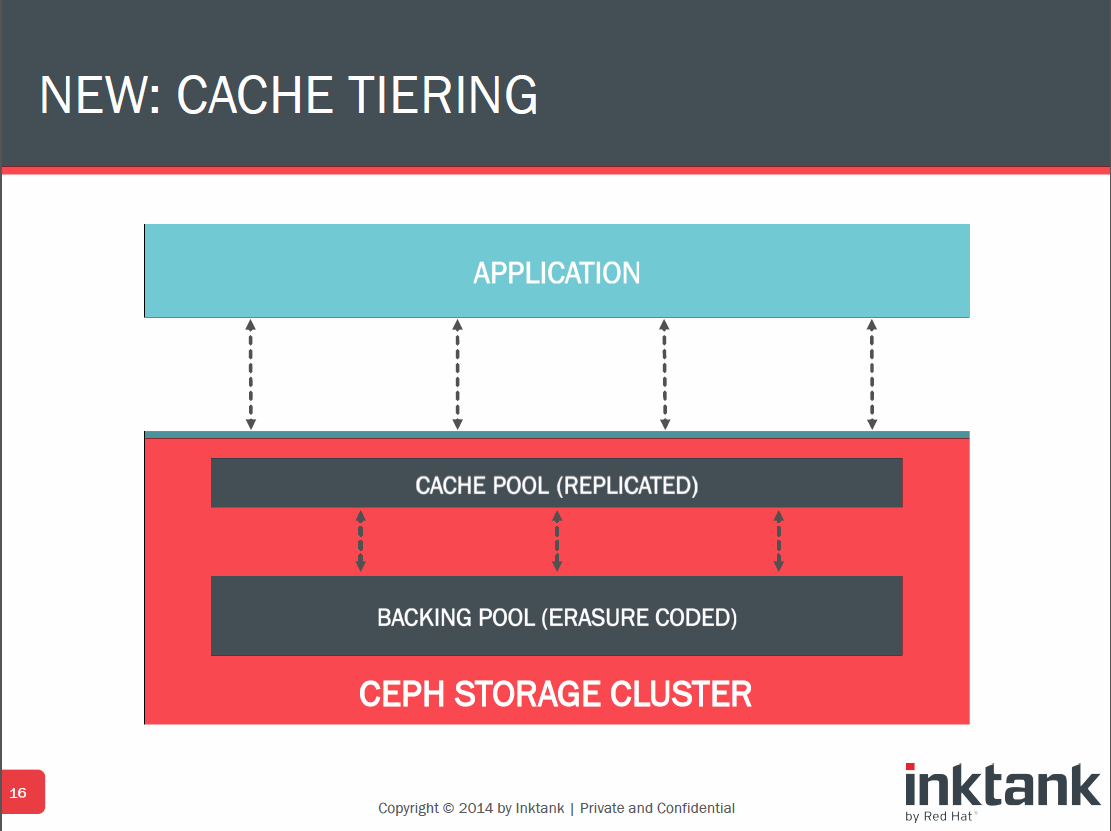

Des fonctions de tiering pour doper la performance

Red Hat recommande aux clients qui souhaitent allier performance et erasure coding d’envisager l’utilisation de la fonction de tiering pour assurer que les données les plus actives restent stockées sur les supports les plus rapides. La fonction permet dans la pratique de transformer un pool rapide à base de SSD en un cache en mode write back pour un autre pool à base de disques durs plus lents.

Il est à noter que Ceph s’appuie par défaut sur la librairie Jerasure pour ses fonctions d’erasure coding, avec un paramètre par défaut de 2+1 ce qui veut dire que le système découpe les données en deux parties et crée une donnée de parité additionnelle avant de stocker ces trois éléments sur trois périphériques différents. Red Hat estime que nombre de clients utiliseront un autre réglage, tel que 12+2 qui assure une plus grande distribution des données et tolère la panne de jusqu’à deux nœuds sans surcoût excessif en matière de stockage.

Une autre fonction intéressante de ICE 1.2 est l’évolution de la console d’administration Calamari (désormais open-source) qui permet de suivre la santé du cluster, d’analyser les performances par disque et par pool, etc…

En l’état Red Hat n’a pas ajouté à ICE le support du mode fichier, jugé encore non mature. D’autres fonctions sont aussi toujours en cours de développement comme l’intégration LDAP et Kerberos, le support d’ISCSI ou le support (à plus long terme) de VMware et Hyper-V.

En l’état Red Hat, supporte Red Hat Enterprise Linux (RHEL) 6.5 et 7, Ubuntu 12.04 et 14.04, ainsi que CentOS 6.5 pour le déploiement d’ICE. Les OS clients supportés pour la connexion à ICE sont RHEL OpenStack Platform 4 et 5, RHEL 7 Kernel Rados Block Device (RBD), Ubuntu OpenStack et Mirantis OpenStack.

ICE 1.2 est facturé à la capacité et non au nœud, comme l’est Red Hat Storage. Red Hat cible un coût de l’ordre de 1 cent par Go pour des installations à l’échelle du Pétactet. Ce coût est plus élevé pour les plus petites installations.

Adapté d’un article de Carol Sliwa, SearchStorage.com