B.Ourghanlian, Microsoft :"l'hyperviseur client, c'est la fin des problèmes de déploiement"

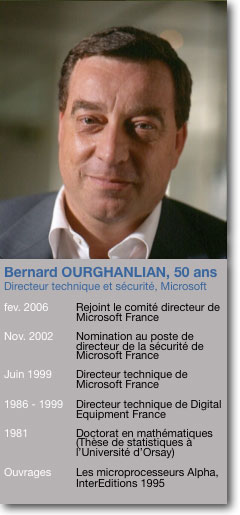

A l'occasion des Tech Days qui se déroulaient la semaine passée à Paris, LeMagIT a rencontré Bernard Ourghanlian, le directeur technique et sécurité de Microsoft France. Alors que Phoenix vient d'annoncer son hyperviseur client et que Citrix et Intel ont annoncé une collaboration sur le sujet, Bernard Ourghanlian évoque les travaux de Microsoft en la matière et explique pourquoi la mise en place d'un hyperviseur client est susceptible de mettre un terme aux problèmes de déploiements auxquels font face les entreprises

A l'occasion des Tech Days qui se déroulaient la semaine passée à Paris, LeMagIT a rencontré Bernard Ourghanlian, le directeur technique et sécurité de Microsoft France. Alors que Phoenix vient d'annoncer son hyperviseur client, que Citrix et Intel ont annoncé une collaboration sur le sujet et que VMware travaille a son propre hyperviseur pour poste de travail, nous avons demandé à Bernard Ourghanlian quelle était la stratégie de Microsoft en la matière. Compte rendu d'un entretien prospectif où le directeur technique de Microsoft décrit l'état des travaux de Microsoft en matière de virtualisation et imagine ce que pourrait être le futur de Windows à quatre ou cinq ans.

A l'occasion des Tech Days qui se déroulaient la semaine passée à Paris, LeMagIT a rencontré Bernard Ourghanlian, le directeur technique et sécurité de Microsoft France. Alors que Phoenix vient d'annoncer son hyperviseur client, que Citrix et Intel ont annoncé une collaboration sur le sujet et que VMware travaille a son propre hyperviseur pour poste de travail, nous avons demandé à Bernard Ourghanlian quelle était la stratégie de Microsoft en la matière. Compte rendu d'un entretien prospectif où le directeur technique de Microsoft décrit l'état des travaux de Microsoft en matière de virtualisation et imagine ce que pourrait être le futur de Windows à quatre ou cinq ans.

L'état de la virtualisation dans l'environnement Windows

Sur les serveurs, nous proposons notre propre hyperviseur, Hyper V aujourd'hui en version 1 et qui sera disponible en version 2.0 lors de l'arrivée de Windows 2008 Server R2. Si l'on regarde les serveurs les scénarios d'usage de la virtualisation sont connus. Ce sont essentiellement la consolidation de serveurs ou, quand on est un peu plus avancé, la mise en oeuvre de plans de reprise d'activité ou de la continuité d'activité. Tous ces scénarios apportent de vrais bénéfices mais on ne peut pas dire qu'ils soient particulièrement innovants [au sens où cela fait plus de 30 ans que les mainframes offrent des scénarios similaires et au sens ou les environnement Unix proposent des outils de partitionnement et de virtualisation depuis plus de 10 ans, NDLR]. C'est à mon avis sur le poste travail que l'on peut espérer à terme les plus grands bénéfices.

En ce qui concerne la virtualisation sur le poste de travail, pour l'instant Microsoft propose Virtual PC qui aura une nouvelle version pour Windows 7. Nous avons aussi un environnement de virtualisation que nous appelons MEDV [qui est l'un des composants du Microsoft Desktop Optimization Pack, un ensemble de technologies destinées à optimiser l'administration des PC de bureau au travers notamment de l'usage de la virtualisation d'applications – avec App-V, ex SoftGrid – et MED-V, ex-Kidaro, NDLR] qui permet d'héberger de façon transparente sur le bureau des applications virtualisées au côté d'applications non virtualisées. Enfin nous proposons des scénarios plus classiques de virtualisation d'applications avec App-V et Windows Terminal Services.

Pourquoi Windows 7 n'incluera pas encore un hyperviseur client

En réfléchissant à moyen terme, il est facile d'imaginer un environnement d'hypervision pour poste de travail que l'on pourrait baptiser Hyper-V 3. Pour qu'un tel hyperviseur apparaisse, nous avons besoin de terminer nos travaux de nettoyage du noyau Windows pour arriver à ce que nous appelons « MinWin ». On a besoin d'avoir un noyau Windows minimal, sujet sur lequel on travaille déjà depuis longtemps, qui soit modulaire de façon à ce que l'on puisse débrayer des composants comme Internet Explorer ou le Shell [Ce que Bernard Ourghanlian appelle ici Le Shell est en fait l'interface graphique de Windows, l'équivalent du Finder de Mac OS X ou de KDE pour Linux, NDLR]. Windows 7 commence à intégrer les résultats de certains travaux venant de MinWin, mais il existe toujours des dépendances cycliques entre le noyau, Internet Explorer et le Shell [Du fait d'incohérences dans le développement de Windows, la couche n de l'OS peut appeler des fonctions de la couche n-1 qui elle-même appelle des fonctions de la couche n+1. MinWin vise à redéfinir une architecture OS saine ou le noyau est autosuffisant et ou les couches qui se situent au dessus de lui sont redécoupées de façon cohérente. Voir à ce propos une interview très instructive de Mark Russinovich, l'un des architectes de Windows sur Channel 9, le site développeur de Microsoft, NDLR]. Nous souhaitons aboutir à la suppression de ces dépendances afin, par exemple, de permettre le remplacement du shell standard par un autre. Par exemple, cela permettrait d'avoir un shell différend sur Surface qui n'ait pas de croix à droite pour fermer une fenêtre ou des choses de ce type qui n'ont pas forcément de sens pour une interface multitouch.

Il faut également que ce nouveau noyau soit capable de fonctionner sans shell. A partir de ce moment, on aura un noyau d'exécution minimal et qui sera adapté à l'accueil d'un hyperviseur. Il faudra ensuite adapter cet hyperviseur aux contraintes d'usage d'un poste client. Emuler une carte VGA comme on le fait aujourd'hui avec Hyper-V n'est par exemple pas acceptable pour un hyperviseur client du fait de l'impact sur les performances. De même il faudra implémenter des capacités d'entrées sorties directes utilisant les extensions des processeurs AMD et Intel car ces fonctionnalités sont très intéressantes pour un usage Desktop. Sur un portable où par exemple les disques durs ne sont déjà pas très rapides, elles éviteront de perdre beaucoup de performances en matière d'entrées sorties. Tous ces travaux sont en cours...

Pourquoi les hyperviseurs clients révolutionneront la pratique informatique des entreprises...

Le scénario majeur sur les postes de travail, c'est non seulement la problématique du déploiement, mais aussi de mettre un terme au cauchemar de migration que représente l'arrivée d'un nouveau système d'exploitation dans l'entreprise. Avec la virtualisation, les entreprises peuvent reprendre le contrôle de leurs environnements et résoudre leurs problèmes de déploiements.

L'idée, c'est de dire : je n'ai plus à me poser la question de retester l'ensemble de mes applications pour le nouveau poste de travail. Cela coûte de l'argent, ne sert à rien et n'a pas de bénéfice pour l'entreprise. L'idée est de prendre ces applications avec leur OS et de les déployer dans l'environnement de virtualisation tout en migrant vers le nouvel OS pour profiter immédiatement de ses bénéfices pour les nouvelles applications. Un des modes d'usage qui me paraît aussi intéressant, et qui est un mode dont on n'a pas encore pris la mesure de l'importance, est un mode mixte dans lequel, si j'ai trois ou quatre image de systèmes d'exploitation, je couple la virtualisation du système d'exploitaiton à la virtualisation d'application et je streame mes applications virtualisées dans les images systèmes virtualis&eac ute;es [à l'instar de ce que propose déjà Citrix avec XenDesktop et de ce que propose Microsoft en couplant ses terminal Services avec App-V, au détail près que ce déploiement ne se fait pas dans des images virtuelles locales, NDLR]. Ce qui fait disparaître la problématique de déploiement du poste de travail.

Vers de nouveaux scénarios d'usage et un nouveau contrat entre l'entreprise et ses utilisateurs ...

Un scénario rendu possible par la virtualisation du poste de travail est celui ou l'entreprise dira aux salariés, vous achetez votre PC, vous en faites ce que vous voulez, vous vous occupez de la maintenance. En échange, je vous donne 1 000 ou 2 000 € par an et je vous fournis une machine virtuelle qui contient l'environnement de travail d'entreprise, verrouillé comme il le faut, avec les dispositifs de sécurité adaptés, et c'est ce que vous utilisez pour accéder au SI d'entreprise. Pour le reste, si vous voulez jouer chez vous, si vous voulez surfer sur internet, c'est votre environnement, vous en faites ce que vous en voulez, c'est à vous. Honnêtement c'est pour moi l'un des scénarios idéal. L'idée de vouloir enfermer les utilisateurs en verrouillant totalement leur environnement de travail est un modèle d'usage qui correspond à des nostalgiques du 3270 et qui n'est plus adapté aux modèles d'usages modernes. Le temps béni où le DSI contrôlait tout est révolu. Si vous voulez essayer de faire en sorte de simplifier la vie des utilisateurs et en même temps de contrôler votre environnement IT de tous les jours, la solution que je décrivais précédemment est très simple.

Tout casser, sans rien casser....

Accessoirement la beauté de l'arrivée d'un hyperviseur client sur les postes de travail est que si un jour il nous venait à l'idée de sortir un système d'exploitation totalement incompatible avec les applications existantes ce serait un moyen très commode de ne pas casser tout ce qui est en place dans les entreprises.

Un autre avantage des hyperviseurs est qu'ils vont sans doute aussi contribuer a permettre de tirer partie pleinement des architectures matérielles à venir. Il n'est pas absurde de penser que d'ici cinq ans, on disposera de plusieurs dizaines de coeurs processeur dans une machine. La probabilité de disposer d'applications capables de tirer partie de ses coeur très franchement est quasi-nulle. On peut donc imaginer un scénario ou l'hyperviseur permettra d'allouer 4 ou 5 coeur à une machine virtuelle X, 4 ou 5 coeurs à une machine virtuelle Y et ainsi de suite, chacune disposant grosso modo des performance d'une machine d'aujourd'hui, la seule différence c'est qu'on n'est pas embêté a passer son temps à tester des dizaines d'applications ou à devoir effectuer un n-ième portage des applications pour les adapter à une nouvelle plate-forme...

Comment assurer la sécurité future dans un tel environnement d'exploitation ?

Avec les technologies déjà présentes dans les puces Intel, on dispose des fondations pour envisager des scénarios intéressants. On sera par exemple capable d'encrer la confiance dans le TPM. On a la signature du Bios, on vérifie qu'elle est valide et on autorise le chargement du Bios puis de proche en proche on procède de même pour le master boot record, les couches basses de l'OS, le moniteur de machines virtuelles, les machines virtuelles... Si j'imagine de monter jusqu'au haut de la pile logiciel, je suis capable alors d'avoir un environnement signé du noyau jusqu'aux applications en passant par la couche de virtualisation . Il y a encore du travail pour aller jusque là mais c'est sans doute une voie d'évolution pour l'avenir.

En savoir plus :

Le Bilan 2008 du MagIT sur la virtualisation du poste client

Notre article sur l'annonce par Citrix et Intel d'un futur hyperviseur pour postes clients