GreenPlum fait converger Hadoop et sa base de données MPP dans Pivotal HD

GreenPlum a dévoilé la semaine dernière sa nouvelle distribution Hadoop, Pivotal HD, dont l'objectif est de proposer une plate-forme de gestion de données bien plus généraliste que les plates-formes Hadoop traditionnelles. Pour cela, Greenplum couplé à Hadoop un nouveau moteur de donnée baptisé Hawq, qui est en fait un portage de sa base de données massivement parallèle sur la plate-forme de données open-source.

Même si EMC reste encore assez discret sur ce que sera le périmètre futur de sa division Pivotal, cette nouvelle entité a commencé à faire parler d’elle la semaine dernière avec l’annonce d’une nouvelle distribution Hadoop, baptisée Pivotal HD. Pivotal HD est le fruit des travaux de GreenPlum et est une évolution de la distribution GreenPlum HD lancée en 2011 à EMC World.

Pour en savoir plus sur cette distribution, LeMagIT a pu s’entretenir avec Saravana Krishnamurthy, en charge du Product Management d’Hadoop chez Greenplum. Comme l’explique Krishnamurthy, l’objectif de Greenplum avec Pivotal HD a été d’élargir de façon significative le périmètre fonctionnel d’Hadoop pour en faire une plate-forme de gestion de données bien plus généraliste que les plates-formes Hadoop traditionnelles. L’innovation clé de la société est l’inclusion dans sa distribution d’un nouveau moteur de données baptisé Hawk et qui n’est en fait ni plus ni moins qu’un portage de la base de données massivement parallèle de Greenplum au-dessus du système de fichier en cluster HDFS. Avec Hawq, l’ambition de GreenPlum est de fournir la capacité d’analyser des données quelle que soit leur nature, leur structure ou leur provenance.

Un nouveau moteur de données dérivé de la base de données massivement parallèle Greenplum DB

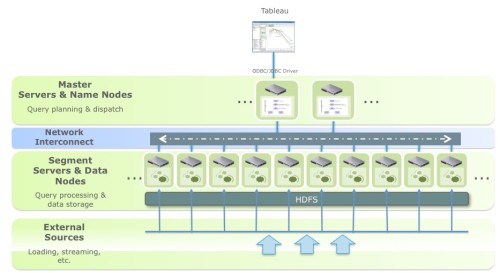

Pour créer Pivotal HD, GreenPlum s’est appuyé sur un socle de code open-source dérivé d’Apache Hadoop 2.x. Cette branche du code a été choisie car elle représente le futur d’Hadoop, mais aussi parce qu’elle apporte de multiples améliorations au système de gestion de fichiers en cluster HDFS nécessaire au bon fonctionnement de Hawq. Pivotal HD apporte tous les services habituels d’une distribution Hadoop notamment le support de Mapreduce, Hive Pig… mais aussi Hawk - dont le code reste propriétaire. Hawq est une vraie base de données SQL au dessus d’HDFS. Cela veut dire qu’elle peut stocker toute forme de données structurées. Le mécanisme de query d’Hawq peut attaquer toute forme de données stockées dans Hawq, mais aussi accéder des données non structurées stockées directement au-dessus de HDFS via un mécanisme baptisé GPXF (Greenplum Extension Framework).

Dans la pratique, Hawq supporte ce que Greenplum appelle des "external tables", qui permettent de décrire la structure de fichiers textes, de logs… et donc de les interroger via son mécanisme de query SQL. Hawq peut aussi interagir avec les données stockées dans Hbase.

L'architecture de Hawq permet à Greenplum de proposer un mécanisme unifié pour l'interrogation de données structurées et non structurées[/caption] Comme l’explique Krishnamurthy, Hawq s’appuie sur le savoir faire MPP de Greenplum et permet de stocker des données en format colonne ou ligne. La base de données permet un partitionnement transparent des données afin de segmenter les données pour optimiser certains query. La base de données embarque aussi toute l’expertise de Greenplum en matière d’optimisation des requêtes. Cela permet à Pivotal HD d’afficher des performances très supérieures à des mécanismes comme Hive ou Impala (d’une dizaine à plusieurs centaines de fois supérieures selon les tâches selon GreenPlum).

Une plate-forme Hadoop qui vise à permettre la réutilisation des compétences analytiques existantes des entreprise

Le tout est compatible avec les standards SQL92 et SQL99 ainsi qu’avec les extensions OLAP de SQL 2003 (au passage la base maintient une compatibilité totale avec PostgreSQL 8.2). Selon Krishnamurthy, cette comptatibilité permet de fournir aux utilisateurs de sa distribution Hadoop le meilleur des deux mondes. Les utilisateurs formés à Mapreduce et aux outils traditionnels d’Hadoop peuvent utiliser ces mécanismes pour analyser les données non structurées stockées sur HDFS. Les utilisateurs d’entreprise traditionnels peuvent quant à eux réutiliser leurs compétences SQL et les compétences déjà développées sur la base de données GreenPlum HD. Un support complet d’ ODBC et de JDBC permet aussi de s’interfacer avec les outils BI existant comme Tableau ou QlikView.

Dans la pratique, Hawk est une option payante au-dessus de la distribution Pivotal HD Entreprise. Cela veut dire qu’il est tout à fait possible de déployer un cluster Hadoop de 500 nœuds dont une centaine seulement pour Hawq. Un des bénéfices est que Pivotal HD peut être utilisé pour consolider des clusters Hadoop existant tout en « réservant » certains nœuds pour le stockage et l’analyse de données structurées ou semi-structurées.

Aller au-delà des limites des bases de données MPP traditionnelles

Interrogé sur les limites d’Hawq, Krishnamurthy indique que la base a déjà été testée sur des configurations en centaines de nœuds et que l’éditeur travaille actuellement à sa validation sur son cluster de test comprenant un millier de nœuds. « On a fait le choix de porter notre base sur HDFS car on pense que l’on peut aller au-delà des limites des bases MPP traditionnelles » explique le responsable produit. Hawq devrait en fait être très flexible. Il lui sera possible de fonctionner sur de « petits » clusters associés à un stockage « centralisé » comme celui proposé par les clusters Isilon avec leur couche HDFS. Il sera aussi possible de déployer la technologie sur de grands clusters Hadoop.

Côté architecture, Krishnamurthy indique que la technologie fonctionnera avec des liens Gigabit mais qu’elle donnera des résultats d’autant plus élevés que la technologie de connectivité sous-jacente sera performante. Cela veut sans doute dire que pour donner son meilleur, Hawq nécessitera une connectivité 10Gigabit ou Infiniband entre les nœuds.

Une distribution Hadoop complète, pour concurrencer les plates-formes d'HortonWorks, Cloudera et MapR

Comme l’ensemble des développeurs de distributions Hadoop, Greenplum package l’ensemble des composants Hadoop open-source les plus utilisés, dont MapReduce, Pig, Hive et Mahout. L’éditeur y ajoute aussi un certain nombre d’outils d’administration et de déploiement dont son outil Command Center pour la gestion et la supervision HDFS, MapReduce et Hawq et ICM (Installation/Configuration/Management), pour l’administration du cluster Hadoop lui-même. Greenplum a aussi inclus les composants Spring Hadoop pour l’intégration d’Hadoop avec le Framework Java Spring – SpringSource, comme GreenPlum, devrait être fondu dans la future structure organisationnelle Pivotal qu’EMC et VMware annonceront ce printemps.

Notons enfin que Pivotal HD embarque les composants nécessaires à son déploiement sur une architecture virtualisée avec VMware (composants développés dans le cadre du projet de virtualisation d’Hadoop, connu sous le nom de code Serengeti). Pivotal HD sera disponible à la fin du mois de mars - sans doute lorsque VMware et EMC auront officialisé la structure finale de l'initiative Pivotal, qui vise à réunir au sein d'un même éditeur de logiciel les équipes de GreePlum, SpringSource, GemFire, Cloud Foundry et Cetas).

Le logiciel sera commercialisé en parallèle des distributions existantes de Greenplum à savoir GreenPlum HD (dérivé d'Apache Hadoop) et GreenPlum MR (une version OEM de la distribution M5 de MapR). Le prix de la nouvelle distribution n’a pas encore été annoncé, mais selon Krishnamurthy, les licences de Hawq seront vendues à un prix inférieur à celle de la base de données GreenPlum.