Cisco en dit un peu plus sur UCS et s'allie avec NetApp

Cisco a dévoilé un peu plus d'informations sur son système Unified Computing lors d'un webcast organisé hier. L'occasion d'en savoir un peu plus sur la technologie d'extension mémoire utilisée dans les serveurs du constructeur mais aussi d'avoir une idée du prix de la solution promue par Cisco. Sans surprise, les gains de ROI avancés par Cisco s'appuient essentiellement sur les économies réalisées au niveau de l'infrastructure réseau et non pas sur ses serveurs font le prix est comparable à ceux des concurrents.

Cisco avait invité la presse hier à un webcast censé donner plus de détails sur l'offre Unified Computing Systems et notamment sur son prix. Surprise : en lieu et place d'un briefing sur les avantages et les mérites de la solution, Cisco nous a proposé un Talk-Show impliquant notamment Soni Jiandani, la vice presidente du marketing du Groupe Server Access Virtualization de Cisco et David Lawler, le vice-president du marketing produit du même groupe. Une prestation scénarisée, dopée au marketing et qui à de rares exception n'aura au final pas permis d'en apprendre beaucoup plus sur la solution du géant. Seuls éléments intéressant, des informations sur les capacités mémoire des serveurs et des indications sur le coût de l'architecture de DataCenter promue par le constructeur.

Cisco Extended Memory Technology : Entre plus de mémoire et plus de serveurs il faut choisir...

La session aura toutefois fourni quelques informations intéressantes. Cisco a notamment indiqué que ses lames pleine hauteur disposent de 48 emplacements pour barettes de mémoire DIMM standard et peuvent donc accueillir un maximum de 384 Go de RAM. Dans notre article rédigé après le lancement des lames UCS B, nous nous étions interrogés sur l'origine de la technologie d'extension de mémoire utilisée par Cisco : Développement interne ou déclinaison pour processeurs Xeon de la technologie Scalable Buffer Memory d'Intel?

Le Talk-Show Marketing du constructeur n'a apporté aucune réponse. En revanche, un livre blanc technique sur la technologie, publié sur son site web par le constructeur, semble indiquer que la technologie a été développée en interne. Dans la pratique elle permet de muliplier par quatre le nombre de barrettes mémoires gérées par un Xeon Nehalem au prix toutefois d'un accroissement de la latence. Cisco note pudiquement que cet accroissement est « marginal » sans toutefois en dire plus.

Le constructeur ne précise pas non plus l'impact des ASIC utilisés sur la consommation des lames. On se souvient que l'usage par Intel de barettes FBDimm dans la génération précédente de Xeon avait un impact non négligeable sur la consommation des mémoires. Au crédit de Cisco, on peut toutefois noter que l'usage de cette technologie d'extension apporte plusieurs bénéfices. Elle permet notamment d'envisager l'exécution d'applications très gourmandes en mémoire (bases de données, BI) sur des lames bi-socket, ce qui était alors une prérogative de serveurs en rack quadri-socket.

De plus, pour ceux qui n'ont besoin que d'une centaine de Go de RAM, elle permet d'abaisser les coûts d'achats de la mémoire. On peut par exemple n'utiliser que des barettes de 2 Go, très économiques sur les 48 slots mémoire, plutôt que de remplir les 12 ou 18 slots mémoires habituelles des lames concurrentes de barettes 8 Go abominablement plus coûteuses.

Reste que les lames serveurs UCS-B250B-M1 Extended Memory ont aussi l'inconvénient de remplir très vite les châssis Cisco. Quatre de ces lames suffisent en effet à peupler un châssis UCS alors que ce dernier peut accueillir jusqu'à 8 lames serveurs standard UCS-B200-M1 (limitées à 12 slots mémoire).

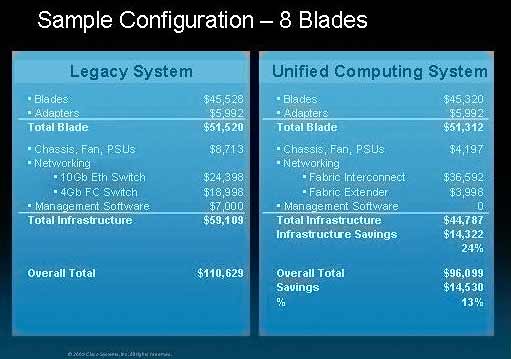

Cisco met en avant un prix unitaire et un ROI inférieurs à ceux des concurrents

A défaut de fournir des informations techniques intéressantes, le Talk Show de Cisco a permis d'en savoir un peu plus sur les prix que pratiquera le géant. Une configuration complète avec huit lames UCS et ses éléments de commutation réseau devrait ainsi coûter environ 96 000 $ (dont 55 000 $ pour le seul châssis avec ses lames et les adaptateurs réseaux). Les prix des serveurs lames de Cisco seraient donc équivalents à ceux des concurrents.

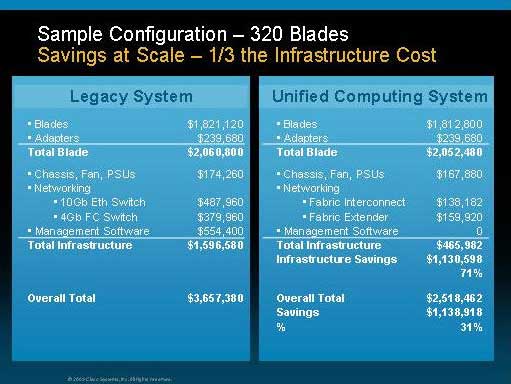

Le constructeur note toutefois que son usage d'un réseau unifié pour la partie réseau IP et pour le stockage génère des économies significative au niveau de l'infrastructure de commutation, puisqu'il n'est plus nécessaire de disposer de commutateurs Fibre Channel. Cisco estime l'économie à environ 24%, outils de management compris. Au total le géant met donc en avant une économie de l'ordre de 13% pour sa solution à 8 lames par rapport à une solution à 8 lames concurrente. A l'échelle d'un datacenter avec 320 lames, Cisco estime que son avantage ne fait que s'accroître et met notamment en avant un coût d'infrastructure en baisse de 71% par rapport à une infrastructure traditionnelle mixant Ethernet pour la partie réseau et Fibre Channel pour la partie stockage.

Reste que cet argument pourra largement être mis à plat par les concurrents dès qu'ils mettront des adaptateurs convergents FcoE (Fibre Channel over Ethernet) et des commutateurs CEE (Convergence Enhanced Ethernet ) à leurs catalogues, Ce qui ne devrait pas tarder, QLgic et Emulex disposent déjà de CNA (Converged Networkd Adapters, des cartes Ethernet supportant à la fois le traffic IP standard et l'encapsulation du trafic Fibre Channel sur Ethernet) tandis que Brocade a profité du dernier Storage Networking World pour dévoiler ses propres CNA et ses commutateurs CEE. Rappelons au passage que toutes les implémentations FCoE et de CEE actuellement sur le marché– Cisco utilise l'appelation DCE- sont encore pré-standards. FCoE comme CEE font en effet encore l'objet de discussions au sein des organismes de normalisation.

Notons pour terminer sur le sujet de l'architecture Unified Computing de Cisco que Jiandani et Lawler se sont évertués sur la fin de leur intervention à dissiper ce que Cisco considère comme les mythes diffusés par ses concurrents et par la presse sur sa solution. Pour faire vite, le systèmes UCS est donc innovant, il n'est pas propriétaire et s'appuie sur des technologies pré -standards. Il n'est pas plus cher que les solutions concurrentes et bien adapté aux déploiements à grande échelle. Enfin, il offre des avantages en matière d'administration et son usage n'est pas réservé aux seules applications virtualisées. Nos lecteurs ne pourront toutefois pas admirer l'intervention de Jiandani et de Lawler, qui n'est aujourd'hui plus en ligne sur le lien que nous avait fourni Cisco.

NetApp et Cisco partagent un intérêt pour les réseaux convergents

Ironiquement une autre intervention vidéo impliquant NetApp, Ed Bugnion, le patron de l'entité dans laquelle oeuvrent Jiandani et Lawler, s'évertue à répéter que l'architecture de Cisco a été optimisée pour les environnements virtualisés et "multi-tenants". Cisco et NetApp y détaillent leur partenariat et expliquent leur intérêt pour faire converger les infrastructure de réseaux des datacenters sur Ethernet. NetApp n'a jamais fait de mystère quant à son aversion pour Fibre Channel (même s'il a intégré le support du protocole dans ses baies) et a été le premier a proposer une connexion FCoE native à ses baies FAS (il avait aussi été parmi les premiers à supporter iSCSI). Le constructeur a déjà certifié ses baies avec les commutateurs unifiés Nexus de Cisco et il entend intensifier sa collaboration avec Cisco pour éduquer les masses aux vertus de la convergence des réseaux de stockage et des réseaux de données sur Ethernet. Mais cette collaboration n'a rien d'exclusif, Cisco et EMC ayant également intensifié leur collaboration autour du stockage et de la virtualisation.