HP structure son offre autour d'Hadoop

HP a profité de sa conférence Discover au mois de mai à Las Vegas pour structurer son offre autour du framework analytique Hadoop. Avec LeMagIT, Marc Padovani, le CTO de la division ESSN d'HP France revient sur les dernières annonces.

HP a récemment levé le voile lors de sa conférence annuelle Discover sur une série de solutions d’infrastructure, de logiciels et de services destinés à simplifier le déploiement d’Hadoop en entreprises. LeMagIT a pu faire le point sur ces solutions dans le cadre d’une discussion avec Marc Padovani, le CTO de la division ESSN (Enterprise Servers, Storage and Networking) d’HP.

Concrètement, HP a défini une série d’architectures de référence basées sur ses solutions d’infrastructures et sur ses logiciels pour accélérer le déploiement de Cluster Hadoop et a aussi développé une série de services pour aider les entreprises à adopter plus rapidement le framework analytique libre. Ces architectures sont basées sur l’expertise accumulée tout au long de déploiements Hadoop effectués par HP, comme le projet Mercury chez eBay (deux clusters Hadoop de 24 Po).

HP propose une série d’architectures de référence pour les distributions Hadoop de Cloudera et de MapR, et entend aussi ajouter à son catalogue très rapidement une architecture de référence pour HortonWorks. Ces architectures de références s’appuient sur des serveurs Proliant, sur Red Hat Linux 6.2 et sur la distribution du choix du client. HP fournit aussi son outil de gestion de grands clusters Insight Cluster Management Utility, un outil dont le développement est réalisé à Grenoble au sein du centre d’expertise HPC de la firme. Le site de Grenoble accueille d’ailleurs aussi le très récent centre d’expertise Hadoop d’HP en Europe.

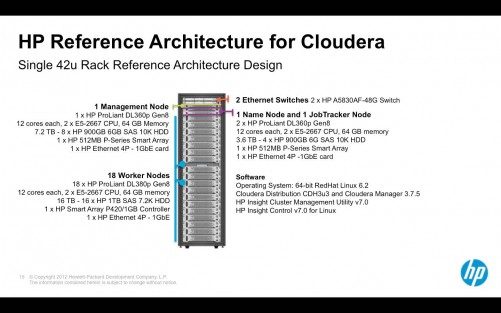

Une architecture pour Cloudera orientée performance

L’architecture HP pour Cloudera s’appuie sur un rack type, préconfiguré. Il inclut 18 nœuds Proliant DL380p Gen8 équipés de Xeon E5-2667, de 64 Go de RAM et de 16 disques durs SAS 7,2K (16 To de capacité par serveur) pour le rôle de « Worker Node », les nœuds qui effectue les calculs dans Hadoop. Le name node et le JobTracker Node, qui gèrent respectivement les métadonnées du file system HDFS et la distribution du travail entre les nœuds sont quant à eux des Proliant DL360p avec 4 disques SAS 10K. Enfin le nœud d’administration est lui aussi un DL360p avec 8 disques SAS 10K. Chacun de ces nœuds dispose de 4 ports Gigabit Ethernet et le tout est interconnecté par deux commutateurs HP5830AF à 48 ports.

(cliquer sur l'image pour agrandir)

Le rack est géré par HP Insight Control for Linux (en v 7.0) et par Insight CMU 7.0. Chaque serveur est motorisé par Red Hat Linux 6.2 et la distribution cloudera mise en œuvre est la CDH3u3, avec Cloudera Manager 3.7.5.

Selon HP il est possible de décliner une version multi-rack de l’architecture de base, mais dans ce cas les racks additionnels ne comprennent que des worker nodes (19 par rack) et deux commutateurs Gigabit. Selon HP, près de 800 nœuds peuvent être provisionnés en quelques minutes avec son architecture de référence, le tout avec une grande simplicité et avec une visibilité sans comparaison sur le fonctionnement du cluster du fait de l’intégration d’Insight CMU.

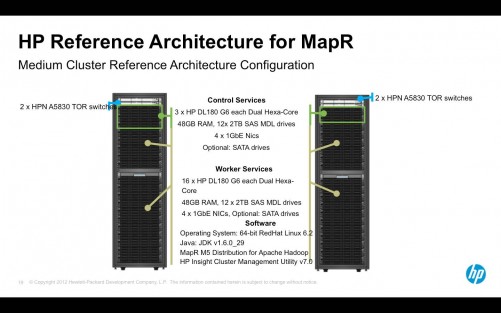

Une architecture différente pour MapR

Étonnamment, HP a conçu une architecture assez différente pour la distribution Hadoop de MapR. Une partie des différences tient aux particularités de la distribution MapR et notamment son file system propriétaire qui élimine le besoin du name node qui est distribué entre les nœuds. Mais selon Marc Padovani les différences tiennent aussi aux scénarios dans lesquels est utilisée la distribution MapR. « On constate qu’avec MAPR il y a beaucoup d’utilisations qui sont moins intensives en termes de calcul qu’avec les autres configurations Hadoop. Le résultat est que l’architecture de référence pour MapR s’appuie sur des nœuds d’ancienne génération, des Proliant DL180G6.

Là encore HP s’appuie sur Red Hat Linux 6.2 et embarque son outil de gestion de cluster Insight CMU 7.0.

(cliquer sur l'image pour agrandir)

Hadoop : quelques entreprises matures et beaucoup en phase de POC

Interrogé sur le niveau de maturité des entreprises françaises quant à Hadoop, Marc Padovalni constate « que certaines entreprises sont déjà dans le plateau de la hype curve telle que définie par Gartner » et ont donc un usage mature d’Hadoop. Il cite par exemple de Crédit Mutuel Arkea, où Hadoop est utilisé pour traiter des données provenant d’application DB2/Cobol sur Mainframe à un coût sans commune mesure avec celui qu’il faudrait payer pour obtenir des résultats similaires sur un mainframe. Il faut dire que l’usage d’Hadoop est piloté chez Arkea par Mathias Herberts, un grand avocat du framework qui a aussi travaillé chez Google sur BigTable et est intervenu lors de plusieurs conférences Hadoop.

Mais Pour Marc Paadovani, nombre d’entreprises en sont encore au stade des POC (à plus ou moins grande échelle). Une des difficultés est la pénurie d’acteurs Hadoop, même si la France est plutôt bien positionnée du fait de la qualité de certains cursus de mathématiques et de statistiques.

Padovani souligne aussi qu’Hadoop est encore jeune et que le framework doit lui aussi mûrir. HP travaille par exemple sur plusieurs développements notamment afin de faciliter le dimensionnement des clusters Hadoop. « Nous avons dans nos labs des algorithmes qui aident à déterminer les tailles de clusters adaptées aux besoins de calculs des clients. L’idée est de déterminer quel type de machine il faut en fonction du problème à résoudre et vice-versa ». Pour l’instant, l’aide au dimensionnement est proposé sous forme de service dans le cadre d’un package baptisé HP roadmap Service for Apache Hadoop, dont l’objectif est d’aider une entreprise à planifier et dimensionner un déploiement du framework analytique libre.

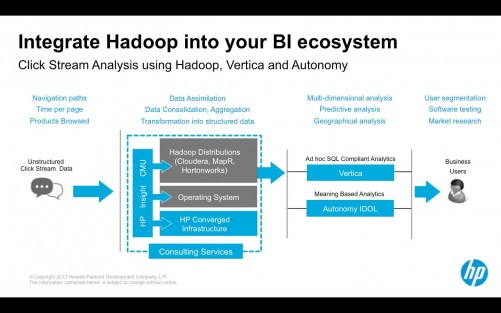

(cliquer sur l'image pour agrandir)

HP a aussi interfacé les outils Vertica 6.0 avec Hadoop de façon à pouvoir importer des jeux de données Hadoop dans son outil analytique. HP reproduit en cela les efforts de concurrents comme Teradata, Greenplum, SAS, IBM.... Notons pour terminer que le constructeur n'entend pas en rester au stade des architectures de référence et entend rapidement industrialiser un peu plus son offre. HP devrait ainsi très prochainement proposer des appliances Hadoop prêtes à l’emploi.