Dossier stockage : à chacun sa classe de service (1ere partie)

ILM, Thin Provisionning, déduplication, stockage sur mémoires Flash, stockage en cluster, consolidation de NAS à grande échelle sont autant de technologies en voie de banalisation dans les équipements des grands constructeurs. LeMagIT revient sur ces technologies et sur la façon dont elle pourraient faire évoluer les approches de stockage dans les datacenters des entreprises

AU SOMMAIRE...

- Introduction

- A chacun sa classe de service

- Déduplication : la guerre est ouverte

- La crise dope l'intérêt des entreprises et des constructeurs pour iSCSI

- FCoE : l'avenir de Fibre Channel s'arrête pour l'instant au sommet du rack

- L'ère des très grands NAS

- Thin Provisionning : l'art de se serrer la ceinture

- Lectra mixe iSCSI et FC

Sept ans après la vague marketing de la gestion du cycle de vie des informations (ILM) en 2002 et 2003, le discours des constructeurs est désormais en phase avec leurs offres - preuve qu'il ne faut désespérer de rien. A l’époque, et afin de faire face à l’explosion du volume des informations non-structurées dans l’entreprise (leur volume venait de dépasser celui des données structurées), les constructeurs recommandaient aux entreprises de travailler à la classification de leurs données en fonction des niveaux de services attendus. Ce travail effectué, ils conseillaient ensuite de diversifier la nature de leurs équipements de stockage afin de fournir des classes de services adaptées aux critères de performances et de coûts requis par chaque type d’information. Le problème est que leur offre de stockage était encore très largement monolithique.

Centre de ressources

Depuis les choses ont bien changé. Tout d'abord l'irruption des disques SATA dans les baies de stockage a permis aux entreprises de disposer au sein d'une même baie de plusieurs classes de stockage et en l'occurrence, d'une classe de stockage plus abordable et mieux à même d'héberger leurs Teraoctets voire peta-octets de données non structurées. Ensuite les mécanismes de gestion de la qualité de service et des performances se sont multipliés dans les baies de stockage. Parallèlement la gestion des baies de stockage s'est simplifiée et la mobilité des données au sein de ces équipements s'est accrue, ce qui a permis d'automatiser plus facilement les mouvements de données d'une classe de stockage à une autre. Aujourd'hui, rares sont encore les grandes entreprises qui gèrent encore leurs données de façon monolithique. La plupart structurent aujourd'hui leur stockage pour faire face aux besoins de leurs différentes applications (disques Fibre Channel pour les applications critiques à fort besoin de performance, disques SATA rapides pour les applications moins exigeantes, disques SATA ultra-capacitifs pour l'archivage...). Cette démarche commence aussi à s’appliquer à la connectique réseau et aux protocoles utilisés : ainsi si Fibre Channel reste l'interface privilégiée par les grands datacenters pour les applications critiques, iSCSI se fait peu à peu un chemin pour les applications moins critiques. En environnements virtualisés, NFS a même souvent sa carte à jouer. Bref, les entreprises apprennent peu à peu à jouer de la diversité et ajustent les technologies utilisées en fonction de la qualité de service attendue, mais aussi en ces temps de crise à leurs contraintes budgétaires. Et il en va de même en matière de politique de protection de données et de sauvegarde…Cette mise en pratique des concepts de l'ILM se fait en parallèle de l'irruption de la virtualisation dans les datacenters, un mouvement qui fait aussi peser de nouvelles contraintes sur le stockage et auquel les constructeurs répondent par l'innovation. Thin Provisionning, déduplication, stockage sur mémoires Flash, stockage en cluster, consolidation de NAS à grande échelle sont autant de technologies en voie de banalisation dans les équipements des constructeurs. Des innovations portées à l'origine par des start-ups et que les géants du secteur intègrent peu à peu à leurs solutions, soit par acquisition, soit par "mimétisme".

Dans ce dossier, nous avons voulu revenir sur l'évolution de la gestion des données au sein de l'entreprise avec notamment un point sur la gestion des classes de service au sein des infrastructures de stockage. L'occasion aussi de faire le point sur le décollage d'iSCSI et sur l'émergence de FCoE, deux protocoles en compétition pour remplacer l'actuel Fibre Channel au sein des datacenters. Le dossier aborde aussi la question de la déduplication, une technologie qui se banalise peu à peu à tous les étages des infrastructures de stockage. Enfin, nous revenons sur la multiplication des offres de NAS à grande échelle, des offres qui répondent à la fois au besoin de consolidation des grandes entreprises et aux besoins massifs de certains fournisseurs de services Internet et qui pourrait servir de base à l'émergence des premiers services de NAS en Cloud tant en interne dans les grands comptes que chez certains fournisseurs de services.

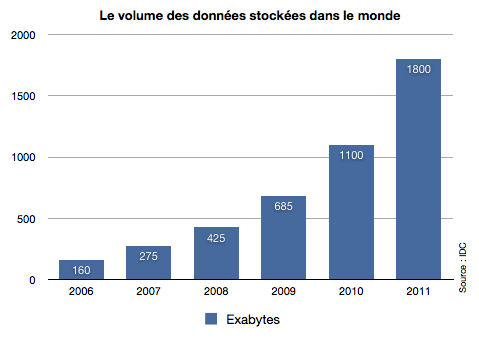

Le débat sur les classes de service et sur le coût de stockage des données n'est pas nouveau puisqu'il remonte aux débuts du stockage sur supports magnétiques. Mais il s'est accru au cours de la dernière décennie du fait de l'accroissement exponentiel des volumes de données des entreprises.

L'histoire des classes de service dans le stockage a en fait commencé dans les années 70 lorsque IBM a introduit la notion de Hierarchical Storage Management (HSM) dans son OS pour grand systèmes (MVS à l'époque, aujourd'hui z/OS). L'idée générale de DFHSM était de déplacer automatiquement les données entre des supports peu coûteux, les bandes, et des support plus chers (les disques durs), en fonction de critères définis par l'administrateur, critère généralement basés sur l'âge des données ou sur la fréquence des accés. Dans la pratique, DFHSM faisait d'une partie de la capacité disque un cache pour les données situées sur bande. DFHSM a permis l'apparition du concept de classes de stockage, Un concept qui n'a finalement été popularisé qu'au début des années 2000 avec le retour sur le devant de la scène de la notion de Gestion du cycle de vie de l'information (ILM). Le débat sur l'ILM a profité d'une conjonction favorable : la croissance exponentielle du volume de données non structurées dans les entreprises et l'apparition d'une nouvelle interface de disque dur d'entreprise, le Serial-ATA (SATA)

Cette arrivée a permis de mixer des disques durs offrants des profils de performance et de coûts différents au sein d'une même baie de stockage. De faisant, elle a ouvert la possibilité pour une entreprise de gérer la répartition de ses données au sein d'une baie de façon plus intelligente. Si les disques Fibre Channel à 15000 tr/mn restent l'apanage des applications transactionnelles exigeant un faible temps de latence, il n'est plus nécessaire d'utiliser ces disques coûteux pour des applications moins sensible qui peuvent très bien se satisfaire des caractéristiques de disques moins véloces comme les disques SATA à 7200 tr/mn. Pour les applications d'archivage, on peut même opter pour des disques SATA "green" à 5400 tr/mn, des disques qui offrent un ratio capacité/prix inégalé. L'arrivée récente des disques Flash (SSD ou Solid State Drives) ajoute un nouveau niveau de service offrant des performances exceptionnelles, mais avec un coût par Go encore très élevé.

La bonne nouvelle est qu'il n'est plus nécessaire d'avoir plusieurs baies de stockage, chacune équipée exclusivement d'un type de disque, pour profiter des bénéfices de l'ILM. Il est désormais possible de mixer ces supports de stockage au sein d'une même baie, qu'elle soit d'entrée de gamme ou de haut de gamme et de mettre en place des politiques de migration de données au sein même d'une baie.

La crise accélère la mise en place des classes de service dans les datacenters

Si certaines entreprises ont fait office de précurseurs dans le domaine de la gestion des classes de service de stockage, d'autres avaient jusqu'alors adopté une approche plus réservée, en continuant notamment à privilégier massivement l'usage de disques Fibre Channel pour leur baie de stockage selon un concept prudent : qui peut le plus, peut le moins.

La crise semble avoir fait évoluer les mentalités à un rythme accéléré. Interrogé par LeMagIT, Xavier Poisson Gouyou Beauchamps, le directeur de l'activité stockage d'HP en France, expliqua ainsi que "tout le monde a cherché à acheter moins cher". Et selon lui, c'est "l'introduction du concept de classe de stockage dans les baies de stockage qui a permis aux entreprises de mettre en oeuvre plus d'intelligence dans leur gestion de leurs données".

L'exemple d'EMC est ainsi emblématique de la révolution qu'a connu le marché du stockage en moins de 10 ans. En 2002, le constructeur réalisait 90% de son chiffre d'affaires avec une seule machine monolithique, le Symmetrix. Sept ans plus tard , solidement installé au premier rang mondial, le constructeur a désormais pour gamme phare les Clariion et les Celerra NS, et même le Symmetrix s'est converti à la religion du multi-niveaux avec le support des disques FC, SATA et des disques SSD. Signe des temps, les disques FC ne sont plus forcément indispensables. Ainsi, sur l'ensemble de son offre milieu de gamme, Hitachi Data Systems a pris l'option d'utiliser une combinaison de disques SATA et SAS.

De l'art de gérer le placement des données sur les bonnes classes de disques

Disposer de disques de classes différentes dans une baie est une chose, en faire usage de façon judicieuse en est une autre. Chez la plupart des grands constructeurs, les nouvelles baies sont équipées au minimum de fonctions de migration de LUN qui permettent de déplacer des données d'une catégorie de disque à une autre. Ce déplacement peut être plus ou moins automatisé selon les cas. Le constructeur offrant la technologie la plus avancée en la matière est sans doute Compellent. Les baies Storage Center du constructeur associent à chaque bloc de données un ensemble de métadonnées (fréquence d'accès, Volume associé, type de disque utilisé, type de RAID, type de données...). Ces informations peuvent ensuite être utilisées pour mettre en place des politiques automatisées de migration de données (Automated Tiered Storage).

Cette automatisation permet d'éviter d'avoir à réaliser manuellement la classification et la migration des données. Elle permet aussi à la baie d'optimiser les performances en tâche de fond, par exemple en migrant les données les plus accédées sur les disques les plus rapides et en repoussant sur les disques les plus lents les données les moins accédées, et ce sans que l'administrateur de la baie n'ait à se préoccuper d'administration.

Sans descendre au niveau du bloc, c'est un peu la même promesse que fait EMC avec sa technologie FAST (Fully Automated Storage Tiering) qui permettra la migration automatique de données d'une classe à une autre mais aussi, à terme, d'une baie EMC à une autre (par exemple d'un Symmetrix à un Clariion).

Les disques Flash chamboulent le marché

L'intérêt pour les technologies de déplacement automatisé de données entre les différentes classes de stockage est d'autant plus important que ces techniques sont vues comme un élément essentiel pour tirer parti des disques à mémoire Flash dans les baies de stockage. Les premiers SSD sont apparus dans les baies des grands constructeurs en 2008 et ils ont rapidement séduit. Leurs performances sont, il est vrai, exceptionnelles notamment pour les applications nécessitant des accès aléatoires et une très faible latence. Ce qui est par exemple le cas des grandes applications transactionnelles, mais aussi de certaines applications dans le calcul numérique nécessitant des accès disques à faible latence.

L'arrivée des disques SSD dans les baies de stockage a de facto créé une nouvelle classe de stockage, qualifiée de Tier 0 par certains, de Premium ou Diamond par d'autres. Si les disques Fibre Channel restent pour l'instant la classe haut de gamme par défaut dans bien des entreprises, cela pourrait changer du fait des nouvelles combinaisons que permet l'usage des SSD.

Comme l'explique Sébastien Verger, le directeur du conseil technique chez EMC, en insérant quelques poignées de disques SSD dans la configuration d'une baie standard, on peut sensiblement réduire le nombre de disques Fibre Channel et accroître le nombre de disque SATA. Sur une baie Clariion typique avec 55 To de capacité, un tel design permet de réduire le coût d'achat de 25% tout en offrant des performances accrues de 30 à 60% par rapport à un design alliant disques FC et SATA.

L'analyse est similaire chez HP qui indique que les gains sont encore plus élevés si l'on réserve l'usage des disques SSD aux données les plus critiques, telles que les index des grands entrepôts de données, les métadonnées associées aux fichiers… Compellent met aussi en avant l'intérêt des SSD couplés à sa technologie de classification et de déplacement automatique de données, qui permet d'en faire un usage optimal. Enfin, Pillar Data Systems, le constructeur détenu par Larry Ellisson indique que l'arrivée des tiroirs SSD à son catalogue devrait à terme sonner le glas de l'usage des disques Fibre Channel dans ses baies, la combinaison SSD, SATA permettant d'offrir des performances en hausse tout en abaissant le prix global du stockage. Notons pour terminer que NetApp se distingue de ses concurrents en utilisant les SSD à deux niveaux. Pour l'instant le constructeur propose d'utiliser la mémoire Flash comme cache de niveau 2 afin de doper les performances en frontal de disques SATA. Les cartes accélératrices PAM 2 permettent ainsi de doper les accès en lecture sur des volumes constitués de disques SATA. Mais NetApp devrait aussi rejoindre ses concurrents en intégrant prochainement des disques SSD à l'intérieur de ses baies. ce qui permettra aussi de profiter du potentiel des SSD en écriture.

Terminons en signalant qu'en l'état actuel de la technologie et de ses coûts, les disques SSD ne sont pas prêts de supplanter les disques mécaniques, ne serait-ce que parce que ces derniers offrent un rapport capacité/prix/consommation sans pareil. En revanche, la baisse des prix des SSD haut de gamme et l'accroissement de leurs capacités pourraient sonner le glas à assez court terme des disques FC haut de gamme, déjà menacés par les disques SAS...

Depuis 2006, la bataille fait rage entre les grands du stockage sur le lemarché de la déduplication de données. 2006 est une date clé pour ce marché avec l'acquisition d'Avamar par EMC. Avamar est une technologie de déduplication à la source qu'EMC a depuis intégré à ses solutions logicielles de backup et notamment Networker et Avamar Virtual Edition for VMware (sauvegarde d'environnements virtuels).

Mais depuis 2006, c'est surtout sur le marché de la sauvegarde sur disque et notamment des librairies de sauvegarde sur disque que se concentre la bataille entre grands du secteur. C'est en effet sur ces périphériques et sur le couplage entre sauvegarde et réplication que la technologie semble le plus prometteuse, puisque le couple réplication/déduplication pourrait démocratiser la réplication pour les sites distants mais aussi permettre l'extinction de l'usage des bandes magnétiques chez certaines entreprises.

Il est vrai que la technologie de déduplication a de quoi séduire. Elle permet en effet d'éviter que des données identiques soient stockées plusieurs fois sur le même espace ce qui permet de réduire significativement le volume occupé, avec des facteurs pouvant atteindre 25 à 50 x selon la nature des données. A ce jour, elle est essentiellement appliquée à l'univers de la sauvegarde, afin de restreindre l'espace occupé par les backup, mais aussi afin de réduire les temps de sauvegarde et restauration ainsi que les temps de réplication pour les données sauvegardées ou répliquées à distance. La technologie permet ainsi, en supprimant les informations redondantes à la source et en les reconstituant à destination, de réduire sensiblement les fenêtres de sauvegarde et de restauration de données entre deux sites distants.

Si la déduplication s'applique pour l'essentiel à des données sauvegardées, NetApp l'utilise aussi pour le stockage en ligne. Tout en reconnaissant que la technologie n'est pas adaptée à tous les scénarios, le constructeur explique qu'elle peut apporter des gains significatifs pour des applications de type bureautique, mais aussi dans des scénarios virtualisés où chaque machine virtuelle contient le même OS et les mêmes applications…

Un marché qui se consolide par acquisitions interposées

Comme tout marché porteur, la déduplication attire l'appétit des géants du secteur qui ont récemment multiplié les acquisitions. C'est IBM qui a déclenché les hostilités en avril 2008 avec le rachat de l'Israelien Diligent, Big Blue écartant au passage son partenaire de longue date en matière de VTL, Falconstor. En mettant la main sur Dligent, Big Blue s'est emparé d'une technologie reconnue et éprouvée et a aussi au passage écorné les stratégies de Sun, Hitachi Data Systems et Overland, tous dépendant de Diligent pour leurs fonctions de déduplication. Le résultat de l'acquisition est la gamme d'appliances de déduplication Protectier, une gamme qui s'est récemment enrichie de fonctions de réplication à distance.

En juin 2008, HP s'est lui aussi intéressé à la déduplication et a intégré à ses appliances de sauvegarde sur disque D2D la technologie de Sepaton, un constructeur avec lequel HP dispose d'un accord technologique depuis 2005. L'inclusion de cette technologie permet à HP d'annoncer un gain d'espace pouvant atteindre un facteur de 50 par rapport aux technologies de sauvegarde traditionnelles.

HP propose la déduplication dans deux séries de systèmes, tout d'abord les appliances de sauvegarde sur disques pour PME de la série StorageWorks D2D Backup System mais aussi sur les système de virtualisation de librairies de bandes Storageworks Virtual Library Systems (VLS).

EMC, de son côté, a répliqué dans un premier temps en nouant une alliance avec Quantum, dont la technologie a été intégrée aux librairies de sauvegarde du constructeur d'Hopkington. Mais la lune de miel n'a guère duré. Au printemps 2009, la tentative de NetApp de mettre la main sur Data Domain a ainsi servi de prétexte à une contre-attaque d'EMC. Au terme d'une longue bataille financière ce dernier a porté les enchères sur Data Domain à un niveau hors d'atteinte de son rival. L'acquisition de Data Domain par EMC prive NetApp d'une technologie dont il avait sans doute besoin pour améliorer son offre technologique actuelle, qui a le mérite d'exister mais l'inconvénient d'être assez fruste. NetApp se voit aussi privé d'une perspective de diversification sur laquelle il comptait pour asseoir son développement. À son rythme de croissance actuel, Data Domain pourrait en effet réaliser un CA de l'ordre de 400 M$ en 2009, un coup de pouce bienvenu aux 3,4 Md$ de CA que NetApp a réalisé au cours de sa dernière année fiscale achevée le 24 avril 2009.

Entre ses technologies de déduplication, EMC va devoir... dédupliquer

EMC, de son côté, gagne l'une des technologies les plus réputées du marché en matière de déduplication, mais a du pain sur la planche en matière d'intégration. Le constructeur se retrouve en effet à devoir gérer plusieurs technologies de déduplication, dont celles de DataDomain et Quantum, largement concurrentes. Le géant d'Hopkington dispose aussi, depuis le rachat d'Avamar en 2006, d'une technologie de déduplication dite à la source (la déduplication s'effectue à l'endroit d'où proviennent les données et non pas au niveau de l'équipement où elle seront stockées).

La première phase d'intégration pourrait voir EMC remplacer les sous-systèmes disuqes Xyratex actuellement utilisés dans les appliances de DataDomain par des sous-systèmes communs avec ceux de ses Clariion. Mais la vraie question concerne l'avenir des technologies de Quantum dans les librairies DL3D baties sur la technologie de déduplication de Quantum (voir ci-dessous).

On le comprend facilement ce dernier est le grand perdant du jeu de domino joué par les géants du secteur. Pourtant pionnier du secteur Quantum se retrouve dans une situation de grande fragilité financière qui pourrait en faire une proie de choix pour un des grands du secteur. Le choix de Data Domain par EMC, pourrait aussi menacer l'alliance nouée entre Dell et Quantum.

Pour approfondir sur Formats et Archivage

-

![]()

Les startups redoublent d’imagination pour concrétiser le stockage NVMe

-

![]()

Datera 3.2 ajoute le support du mode objet à celui du stockage en mode blocs

-

![]()

Avec PowerMax, Dell EMC donne un coup de jeune à son offre de stockage haut de gamme

-

![]()

La Flash en marche pour conquérir le stockage primaire et plus encore