Dossier infrastructures 2010 : la convergence au service de la réduction des coûts (1ère partie)

Si l'on en croit les prévisions des analystes et les déclarations des utilisateurs, 2010 devrait marquer une intensification des efforts de consolidation et de virtualisation dans les entreprises. Objectif principal : réduire les coûts d'exploitation, mais aussi accroitre la souplesse et la résistance du SI. Ces efforts devraient être appuyés par l'émergence d'une nouvelle génération de serveurs et d'infrastructures facilitant la convergence entre serveurs, stockage et réseaux. Si tout se passe comme prévu, convergence sera le maître mot de 2010

AU SOMMAIRE...

- La virtualisation dope la consolidation de serveurs

- Pour Intel et AMD, 2010 sera l'année des serveurs

- Power 7, Itanium, UltraSparc T3 : dans le monde Unix, 2010 s'annonce agité

- Stockage : les tendances de 2010

- 2010 année de la convergence des réseaux de données et de stockage ?

- La tentation du Cloud

En permettant la consolidation des infrastructures informatiques et la réduction des coûts, la virtualisation a émergé comme l’une des technologies phares au sein des entreprises. A tel point qu’elle est aujourd’hui le chantier prioritaire de la plupart des DSI pour 2010. L’effort de virtualisation ne devrait d’ailleurs pas être limité à cette seule année et devrait être massif sur les trois prochains exercices. Ainsi Gartner estime qu’à la fin 2009, seules 16 % des instances systèmes (ou workload) opérées dans les datacenters étaient virtualisées.

Cette part devrait passer à 50 % d’ici la fin 2012. Le nombre d’instances effectivement virtualisées devrait donc être multiplié par plus de trois. Une étude menée par nos partenaires de TechTarget entre juillet et septembre 2009 auprès de 900 administrateurs dans le monde indique que dans 16 % des entreprises, la virtualisation des infrastructures reste à initier, tandis que 51 % des répondants indiquent qu’il s’agira avant tout pour eux d’étendre les déploiements existants, notamment pour amener un plus grand nombre d'applications critiques sous le parapluie de la virtualisation.

Une autre tendance devrait aussi se traduire par plus de virtualisation côté serveur : l’adoption croissante de la virtualisation des postes clients conduit à centraliser l'exécution des environnements utilisateurs sur des fermes de serveurs virtualisés au coeur du datacenter. Et le tout se fait à une échelle qui est parfois sans commune mesure avec celle de l’infrastructure serveur en place. Ainsi une entreprise qui voudrait virtualiser 10 000 postes utilisateurs, doit se préparer à opérer au moins 10 000 machines virtuelles supplémentaires (VM) dans son datacenter (à supposer que chaque utilisateur n’ait accès qu’à une VM et pas à plusieurs...).

Une tendance accrue à la consolidation

Aujourd’hui, 58 % des répondants de l'enquête TechTarget déploient moins de 10 VM par serveur, tandis que 32 % d'entre eux déploient entre 10 et 20 VM par serveur virtualisé. Pour 10 % seulement, le nombre moyen de VM par serveur se situe dans une fourchette allant de 20 à 30. Ces chiffres sont assez conformes avec les pratiques des grandes entreprises françaises qui se sont attaquées à la virtualisation et montrent que les pratiques sont assez homogènes à l’échelle mondiale. Mais le plus intéressant dans les réponses fournies est l’accroissement graduel du nombre de machines virtuelles par serveur, qui montre l’appétit des entreprises pour davantage de consolidation (un appétit qui a sans doute été alimenté par la réduction des budgets en 2009).

Ainsi, 16 % des administrateurs ayant répondu à l’étude avouent un accroissement supérieur à 100 % du nombre de machines virtuelles par serveur, tandis que 30 % notent une augmentation de 50 à 100 %. 29 % indiquent avoir vu le nombre de VM par serveur progresser de moins de 50 %. Seuls 24 % des entreprises sondées par TechTarget n’ont rien changé. Pour l’anecdote, 1 % des répondants notent un recul du nombre de VM par serveurs.

Réduire les risques liés à la consolidation

Si l’accroissement du nombre de VM par serveur apporte des gains économiques perceptibles, il porte aussi son lot de risques et accroit notamment l’impact potentiel d’une panne de serveur sur le SI. La consolidation de serveur doit donc s’opérer avec discernement. Reste que les évolutions logicielles des hyperviseurs permettent aussi de limiter, sinon de palier ces risques.

Tous les hyperviseurs modernes proposent ainsi un mode dit de haute disponibilité qui permet le redémarrage automatique sur un autre serveur des VM affectées par une panne du serveur sur lequel elles résidaient. Ce redémarrage s’effectue toutefois au prix d’une courte interruption de service (qui peut toutefois se prolonger si la panne d’un composant logiciel en a affecté d’autres en cascade).

Un second mécanisme de protection est appelé à devenir plus courant, celui de la tolérance aux pannes. déjà, VMware propose un mode FT permettant à deux VM de fonctionner en mode «Lockstep» sur deux serveurs différents. en cas de panne du serveur principal, les machines protégées par le mode FT poursuivent leur exécution sans interruption de service sur le serveur secondaire. Un tel support de la tolérance au panne existait déjà chez Stratus (qui commercialise une version modifiée de Citrix XenServer) et devrait aussi apparaitre dans les prochaines moutures de XenServer. Les équipes de développement de l’hyperviseur libre Xen ont en effet dans leur trousse à outil plusieurs mécanismes de tolérance aux pannes. Restent que ces mécanismes de protection ont un impact sur les performances et apportent des contraintes supplémentaires d’homogénéité des serveurs physiques.

Cet accroissement n’est pas vraiment une surprise. Il va de pair avec l’amélioration des capacités des serveurs et notamment avec l’arrivée des puces quadri-coeurs Xeon 5500 « Nehalem » d’Intel et celle des hexa-coeurs Opteron « Istanbul » d’AMD. Deux familles de puces qui ont contribué à doper les performances des serveurs virtualisés. Comme nous le verrons plus loin, 2010 devrait encore apporter une vague impressionnante de nouveaux processeurs et de plates-formes optimisées pour la virtualisation. Ce qui ne devrait que renforcer la tendance à la consolidation.

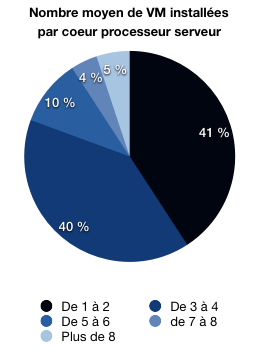

Car la plupart des administrateurs déploient aujourd’hui des VM en respectant un ratio de machines virtuelle par coeurs. Ainsi 39 % des répondants à l’étude TechTarget indiquent déployer une à deux VM par coeur, tandis que 40 % en installent 3 à 4. 13 % d'entre eux montent à 5 ou 6 VM par coeur. Et 4 % des entreprises font fonctionner 7 à 8 VM par coeur. Si ces métriques restent stables, 2010 devrait marquer une accélération de la consolidation, simplement en raison de l'accroissement du nombre de cœurs par puce. Intel va en effet faire passer ses Xeon bi-socket de 4 à 6 coeurs avec l’arrivée des Xeon « Gulftown » en 32 nm - attendus fin mars- et ses Xeon quadri-socket de 6 à 8 coeurs. AMD, de son côté, offrira 8 à 12 coeurs physiques par processeur avec ses puces Opteron 6000 « Magny-Cours », contre 6 pour les actuels composants de génération « Istanbul ».

Consolider complique l’administration

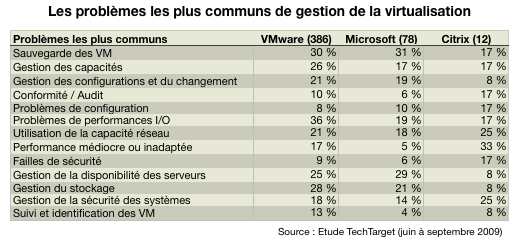

Si les administrateurs s’accordent sur les bénéfices de la virtualisation en matière de réduction des coûts et de flexibilité du SI, la plupart reconnaissent aussi qu’elle complique l’administration et pose de nouveaux problèmes en matière de gestion des entrées/sorties, de gestion des capacités ou de gestion du stockage.

2010 devrait d’ailleurs être mis à profit par de nombreuses entreprises pour s’interroger sur leurs outils de management et pour adapter leur instrumentation actuelle aux besoins des environnements virtualisés. Les principales difficultés remontées par les administrateurs portent notamment sur la sauvegarde des environnements virtualisés, sur la gestion des capacités, sur les problèmes de performances en entrées/sorties, sur la supervision des environnements virtuels et sur la gestion du stockage (voir tableau ci-dessous).

A ces problèmes, les constructeurs répondent en mettant en avant de nouvelles architectures « convergées » visant à simplifier la mise en oeuvre et l’exploitation de la virtualisation. Aiguillonés par l’irruption de Cisco sur le marché des serveurs et par l’alliance noué par le géant des réseaux avec EMC et sa filiale VMware, HP, IBM et Dell ont passé l’essentiel du second semestre 2009 a fourbir leur réponse à l’architecture convergente élaborée par l’alliance VCE (VMware, Cisco, EMC).

HP a été le premier à dégainer tout d’abord avec le lancement de son offre BladeSystem Matrix, puis avec le rachat de 3Com. IBM, de son côté, a noué d’étroits partenariats avec des spécialistes du réseau dont Brocade, Juniper et Blade Network, tandis que Dell faisait de même tout en renforçant sa propre offre de stockage iSCSI. La promesse de tous : simplifier le déploiement et l’exploitation d’infrastructures virtualisées en fournissant des solutions ou des architectures prêtes à l’emploi. 2010 devrait dire si ces premières tentatives tiennent leurs promesses.

Après une année difficile qui a mis sous pression les budgets informatiques et contribué à geler certains projets d’infrastructure, l’année 2010 pourrait voir une reprise des investissement côté serveurs, une reprise que devrait doper l’arrivée d’une nouvelle génération de processeurs serveurs chez Intel et AMD. Entre les deux fabricants, la bataille s’annonce plus tendue que jamais. Intel et AMD devraient en effet présenter leurs derniers nés en mars avec, chez Intel, l’arrivée des Xeon Nehalem EX pour les serveurs x86 à quatre socket et celle des nouveaux Xeon 5600 « Gulftown » en 32 nm pour les serveurs bi-socket.

AMD de son côté devrait riposter avec ses nouveaux Opteron 6000 « Magny-cours » à 8 ou 12 coeurs physiques, des processeurs annoncés comme environ 60 % plus performants que les actuels Opteron « Istanbul » en utilisation réelle. Surtout le lancement des puces Magny-Cours devrait coïncider avec l’adoption par les constructeurs dans leurs serveurs des nouveaux chipset AMD. Disponibles depuis l’été 2009, ces composants apportent le support de la virtualisation d’entrées-sorties (IOV), une technologie déjà disponible sur les plates-formes Xeon « Nehalem » et supportée partiellement par VMware vSphere et Hyper-V (Citrix a aussi fait une démonstration d’une future version de XenServer avec support de SR-IOV lors du dernier Intel Developer Forum en septembre 2009). Nehalem EX, Gulftown comme Magny-Cours devraient encore doper significativement les performances des serveurs x86 et permettre d'atteindre des niveaux de consolidation encore inconnus sur plates-formes x86. Leurs performances devraient aussi permettre d'envisager la bascule sur architectures x86 de certaines applications jusqu'alors largement réservées à des serveurs Unix plus coûteux.

AMD espère regagner du terrain sur Intel

Dans la bataille entre Intel et AMD, le premier a largement pris l’ascendant sur le second en 2009, grâce au succès de ses Xeon à architecture Nehalem. Intel a ainsi réalisé 89,9 % des ventes de processeurs pour serveurs et stations de travail (soit un gain de 3,2 points) pour l’année écoulée, contre 10,1 % pour AMD. Pour ce dernier, 2009 aura été une année de rémission, une année où le fondeur a passé une bonne partie du premier semestre à regagner la confiance des constructeurs et des entreprises après le fiasco de ses premières puces quadri-coeurs Barcelona en 2008. Finalement, ce n’est qu’au second semestre 2009 avec l’arrivée de ses puces Opteron Istanbul dans les serveurs, qu’AMD a recommencé à regrignoter du terrain sur son concurrent. Reste que le lancement d’Istanbul n’a pas suffi pour permettre à AMD de concurrencer efficacement Intel sur le marché des serveurs bi-socket, qui représente plus de 80 % des livraisons de serveurs x86. Il lui a, en revanche, permis de conserver sa domination sur le marché des serveurs quadri-socket et plus, un marché lucratif où ses puces écrasent celles d’Intel.

Quadri-socket : Intel veut reprendre le leadership sur AMD

2010 se présente sous un nouveau jour. Sur le marché des serveurs quadri-socket et plus, Intel entend briser la domination d’AMD en lançant le Xeon 7500 « Nehalem EX », la première déclinaison de ses puces Xeon haut de gamme équipée d’un contrôleur mémoire intégré et du bus QuickPath (QPI). En amenant sur les grands serveurs x86 les technologies qui ont fait son succès en 2009 sur le marché des serveurs bi-socket, Intel devrait sensiblement doper les performances de ses serveurs. Reste qu’en face, AMD ne s’endort pas sur ses lauriers.

|

| Bande passante mémoire comparée des puces serveurs (cliquer ici pour agrandir) |

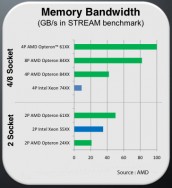

Face aux Xeon 7500 à huit coeurs, le fondeur texan ripostera avec ses puces Opteron « Magny-Cours » à douze coeurs, des puces qui profiteront non seulement du nombre plus élevé de coeurs, mais surtout d’un bond considérable de la bande passante mémoire. Ainsi un système à quatre puces Opteron 61xx « Magny-cours » offrira une bande passante mémoire près de 2,5 fois supérieure à celle d’un système à quatre puces Opteron 84xx, mais aussi 25 % supérieure à celle d’un système à huit sockets Opteron 84xx. La bataille entre Intel et AMD devrait donc se poursuivre, et à couteaux tirés.

Bi-socket : AMD veut contrer les Xeon Nehalem

Sur le marché des serveurs bi-socket, l’affrontement entre les deux fondeurs devraient être encore plus saignant, AMD ayant l’ambition de renouer avec sa position d’il y a 4 ans, c’est à dire près de 20 % du marché. Sur le marché des serveurs d’entreprise, la bataille opposera les puces « Magny-Cours » à huit et douze coeurs physiques aux nouveaux Xeon GulfTown à quatre et six coeurs. AMD compte sur la bande passante accrue de ses processeurs et sur leur plus grand nombre de coeurs pour rivaliser en performance avec les systèmes Intel, notamment sur les environnements virtualisés, qui ont montré leur sensibilité à la performance mémoire et leur capacité à tirer parti des processeurs multi-coeurs.

AMD estime qu’un serveur bi-processeur Opteron 61xx devrait afficher une bande passante mémoire de 50 Go/s contre 32 à 37 Go/s pour les actuels Xeon 5500 (à titre de référence, un système bi-socket Opteron « Istanbul » actuel plafonne à 20 Go/s de bande passante mémoire). AMD s’attend à des gains de l’ordre de 60 % sur des applications traditionnelles et espère des gains encore supérieurs en environnements virtualisés. Rappelons que l’accroissement de la bande passante mémoire (3 à 3 fois et demi par rapport aux Xeon 5400) a largement contribué aux performances des Xeon 5500 « Nehalem ».

Consommation énergétique : un autre champ de bataille

Intel devrait donc perdre son principal avantage sur AMD, mais a encore quelques atouts dans sa manche. Le fondeur californien pourra notamment riposter sur deux axes. Grâce à la réduction de la gravure de ses puces à 32 nm, Intel pourrait enfin revenir à la hauteur d’AMD en matière de consommation énergétique. Si la consommation moyenne d’un Xeon 5540 est raisonnable - avec une enveloppe thermique ou TDP de 80W -, cette même puce poussée dans ses derniers retranchements peut allègrement consommer 130 W, soit environ 30 % de plus qu’un Opteron « équivalent ».

Intel aura aussi l’avantage de fréquences plus élevées ce qui pourrait payer pour certaines applications : AMD prévoit ainsi des puces cadencées entre 1,7 et 2,4 GHz, tandis qu’Intel envisage des fréquences entre 2,2 et 2,9 GHz pour ses puces hexa-coeurs. Sauf accident industriel chez l'un des deux fondeurs, les premiers systèmes équipés de ces nouvelles puces devraient faire leur apparition chez la plupart des grands constructeurs au début du printemps.