Virtualisation de serveurs : l'âge industriel

En 2008, le nombre de machines virtuelles déployées dans le monde a dépassé pour la première fois le nombre de serveurs physiques vendus par les constructeurs. Désormais utilisés à l'échelle industrielle, les hyperviseurs devraient être déployés sur 21% des serveurs vendus en 2009. Dans 4 ans, IDC estime que 60% des serveurs vendus seront virtualisés. Consolidation, Green IT, accroissement de la disponibilité et flexibilité des infrastructure sont autant d'arguments qui prêchent en faveur de la technologie. Dans ce dossier, LeMagIT fait un point sur le phénomène de la virtualisation, sur ses grands acteurs et sur les écueils à éviter dans le cadre d'un projet de virtualisation.

Au Sommaire de ce dossier...

- Virtualisation de serveurs : l'âge industriel

- Virtualisation de serveurs : l'âge industriel (2)

- Citrix, Microsoft et Oracle font la chasse à Vmware

- VMware : après le datacenter, les nuages…

- XenServer 5.5 : Un challenger solide

- Hyper V 2.0: la maturité ?

- Bonnes pratiques : les principaux obstacles à éviter

- Trois Questions à ... François Besson, Systar

Pour la première fois en 2008, le nombre de machines virtuelles mises en service sur des serveurs x86 virtualisés a dépassé le nombre de serveurs physiques vendus dans le monde. Ce chiffre d'IDC en dit long sur la révolution qui frappe actuellement les centres informatiques des entreprises. Selon IDC, un peu plus d'un serveur sur 5 vendu dans le monde en 2009 sera virtualisé et ce chiffre devrait atteindre 60% en 2013. à ce stade, l'essentiel de la production informatique mondiale tournera dans des machines virtuelles.

L'ironie est que cette adoption de la virtualisation dans l'univers des serveurs AMD et Intel est en quelque sorte un retour aux sources. Née il y a près de 40 ans dans le monde des grands systèmes IBM avec l'apparition de VM, la technologie a fait un retour progressif dans le monde des systèmes distribués au cours des années 90 avec les premiers pas des systèmes de partitionnement logique pour grands serveurs Unix. Aujourd'hui c'est l'univers des serveurs banalisés, sur processeurs Intel ou AMD, qui connaît à son tour un engouement pour la virtualisation, un engouement dopé par la popularité de VMWare - dont les technologies seraient utilisées sur 80 à 90% des déploiements sur le marché français selon les intégrateurs et constructeurs que nous avons interrogé -, mais aussi par la montée en puissance de ses concurrents, au premier rang desquels Citrix, avec XenServer, mais aussi Microsoft, Avec Hyper-V, et Oracle avec Oracle VM.

Des environnements de test à la production

Les débuts de la virtualisation de serveurs se sont effectués dans les environnements de test et de développement, un scénario logique, étant donné que de nombreux développeurs utilisaient déjà des outils de virtualisation sur leurs postes clients à des fins de test et avaient pu valider les bénéfices de ces outils. Pour de tels environnements, la virtualisation avait plusieurs bénéfices, le principal étant sans doute l'activation très rapide d'un nouveau serveur de développement. Avec un hyperviseur, il est en effet très facile de constituer une bibliothèque d'environnement prêt à l'emploi que l'on peut déployer d'un simple clic. Cela permet d'activer en quelques minutes un environnement de test, mais aussi de le détruire en quelques minutes si besoin. Une quasi-instantanéité à comparer aux heures ou aux jours qu'il fallait autrefois pour configurer un serveur de test. Il est aussi très simple de cloner un environnement actif pour tenter une manipulation et vérifier sa faisabilité avant de l'exécuter sur un environnement réel. Nombre d'entreprises ont ainsi commencé par mettre en œuvre des hyperviseurs dans leurs environnements de test et de développement. Le tout couplé à des interfaces permettant aux utilisateurs de ces environnements d'activer eux-mêmes les machines virtuelles dont ils ont besoin.

Rapidement les entreprises ont ainsi pu tester les promesses de la virtualisation et les hyperviseurs ont peu à peu acquis leur lettre de noblesse, jusqu'à être jugés mûrs pour faire face aux exigence des environnements de production. C'est ainsi qu'en 2007, on a vu apparaître en France chez de nombreux grands comptes les premiers grands projets de virtualisation dans les datacenters.

La virtualisation, moteur de la consolidation de serveurs

La virtualisation au service des applications fossiles

Dans certains cas, la virtualisation est un outil de préservation utile pour des applications anciennes que l'on souhaite mettre en sécurité. C'est ainsi qu'en 2006, l'équipementier automobile Lisi Automotive, a utilisé VMware pour mettre en sécurité des vieilles applications NT4 tournant sur des serveurs vieillissants et qui ne pouvaient plus évoluer ou pour lesquels les prestations de maintenance s'éteignaient.

"Cela nous a permis d'assurer la disponibilité de ces applications avec même quelques bénéfices en terme de performances" expliquait alors Ghislain Gauthier le responsable infrastructure de l'équipementier. Depuis, nombreux sont ceux qui ont suivi son exemple...

La principale motivation pour l'adoption de la virtualisation reste la réduction des coûts liée à la consolidation de serveurs. C'est d'ailleurs avec cet objectif en tête que la plupart des grandes entreprises françaises ont lancé leurs projets de virtualisation. L'idée est relativement simple à comprendre. Un serveur x86 non virtualisé est en moyenne utilisé à 5 à 10% de ses capacités (ce qui, soit dit en passant, en dit aussi long sur les dérives des constructeurs et des entreprises en matière de conception et d'achat de serveurs). En virtualisant, une quinzaine de ces serveurs sur une machine de nouvelle génération, on peut espérer atteindre un taux d'utilisation moyen de 60%, c'est-à-dire utiliser réellement la puissance que l'on a payée.

Quelques exemples permettent d'avoir une idée plus claire des impacts d'une telle consolidation. Chez France Télécom, les premières étapes du projet "Eco Center" ont abouti à des taux de consolidation pouvant atteindre 20 pour 1 (un serveur virtualisé moderne accueille 20 machines virtuelles et remplace vingt vieux serveurs de génération antérieure) en environnement VMware. À terme, l'opérateur espère éliminer environ 10 000 serveurs de son parc dans le cadre d'un vaste projet de rationalisation de ses 17 datacenters en 2 megadatacenters dont un situé à Val de Reuil près de Rouen. Chez Bouygues Construction, 150 serveurs biprocesseurs ont été remplacés par 6 machines quadri-processeurs virtualisées sous Hyper-V, soit une réduction de 96% du nombre de serveurs sur le périmètre impacté.

Un projet de consolidation de serveurs est une opération qui peut-être assez rapide. Un administrateur formé et opérant dans un cadre de migration bien défini (après une phase de pilote et maquettage de quelques mois) peut ainsi migrer une vingtaine machines physiques par jour. Lorsque cette opération de consolidation est réalisée de façon maîtrisée et avec les outils de migration adéquats, elle peut produire un retour sur investissement impressionnant. A la Poste, par exemple, 600 serveurs ont été remplacés par 50 serveurs virtualisés sous VMware, dégageant une économie allant de 30 à 50 % selon les cas.

Quand économies et écologie font bon ménage

Ces gains s'obtiennent à de multiples niveaux. La consolidation permet tout d'abord de réduire sensiblement les dépenses en matériel, mais aussi de réaliser de considérables économies en matière d'hébergement de machines et de consommation électrique. Prenons par exemple le cas d'un datacenter où 100 serveurs biprocesseurs de génération antérieure sont remplacés par 8 serveurs quadri-socket en lames. Cette consolidation va permettre de faire passer la consommation typique d'environ 30 KW/h à 6KW/h, tout en réduisant de façon drastique l'espace d'hébergement utilisé dans le datacenter. La configuration cible n'occupera en effet que 7 U dans un rack de 19 pouces, alors que la configuration d'origine occupait entre 1,5 et 2 racks (cas de serveurs lames) ou 3 racks pleins (cas de serveurs racks). Et c'est encore sans compter avec les bénéfices liés à la réduction de la connectique réseau et stockage générée par la consolidation de serveurs.

Si l'on accepte que dans un datacenter typique, non encore modernisé, la protection électrique et le refroidissement peuvent doubler la consommation, le passage du physique au virtuel de ces 100 serveurs générera une économie de près de 420 000 KW/h en année pleine, soit environ 30 000 € de réduction de la facture électrique (sur la base d'un KWh facturé à 7 centimes en moyenne). Autant dire que pour des grands comptes, la virtualisation de 1000 ou 5000 serveurs peut rapidement générer des gains palpables.

Des scénarios qui dépassent la simple consolidation de serveurs

Mais les bénéfices de la virtualisation ne s'arrêtent pas à la seule consolidation. La technologie, bien utilisée, promet aussi une plus grande flexibilité de déploiement, la simplification de l'administration ainsi que des améliorations sensibles en matière de disponibilité, de continuité de service ou de reprises d'activité. Autant d'éléments qui participent de la création de ce que nombre d'analystes appellent le Datacenter dynamique. Cette transition vers plus de flexibilité requiert toutefois des investissements coûteux en matière de logiciels d'administration. Car si la consolidation ne requière guère plus de choses que la mise en œuvre des fonctions de base des hyperviseurs (et un usage judicieux d'outils de gestion de capacité), l'usage des fonctions avancées requiert en général l'activation de coûteuses options de licence, la mise en œuvre de logiciels additionnels (Lab Manager, module de Disaster Recovery,…). Sans compter la mise en œuvre de fonctions avancées dans les serveurs (telle la virtualisation des entrées/sorties réseaux ou stockage) et la mise en œuvre de configurations réseau et stockage avancées.

Les promesses fonctionnelles sont en revanche séduisantes. Tous les grands fournisseurs proposent ainsi des fonctions de provisionning automatique d'environnements virtuels, afin d'accélérer le déploiement de nouvelles applications ou plus simplement d'ajouter rapidement de nouvelles capacités à des applications dont la qualité de service commence à se dégrader. Chez France Télécom, Loic Renaudon, le directeur du programme Eco Center explique ainsi que la virtualisation permet de répondre à une demande de déploiement d'un nouveau serveur virtuel en quelques heures, contre près de quatre semaines pour un serveur physique.

Tous les grands de la virtualisation proposent aussi des fonctions de haute disponibilité. Les versions avancées de leurs hyperviseurs et de leurs outils de management sont ainsi capables de redémarrer automatiquement sur un nouveau serveur une machine virtuelle victime d'une panne matérielle sur un autre serveur). Dans la dernière mouture de vSphere, VMware va même jusqu'à intégrer la tolérance aux pannes. Citrix ne le propose qu'en option grâce à un partenariat avec Marathon – Stratus le propose aussi, mais dans sa propre version OEM du code de XenServer. Toujours chez VMware, l'outil SRM promet le redémarrage rapide de l'infrastructure virtualisée sur un site de secours en cas de défaillance de l'infrastructure primaire, une opération que l'outil réalise de concert avec les outils de réplication de données des grands fabricants de baies de stockage tels qu'EMC, HP, IBM, NetApp, 3Par, Compellent…

La virtualisation : un défi pour les hommes et les organisations

Tous ces nouveaux outils représentent un défi pour les administrateurs. Car pour tirer parti des fonctions les plus prometteuses des hyperviseurs, il faut mettre en place des architectures complexes, mettant en œuvre plusieurs niveaux d'abstraction et que l'humain a de plus en plus de mal à gérer sans l'assistance d'outils d'automatisation et d'administration avancés. D'autant que les frontières traditionnelles entre les différents composants de l'infrastructure informatique (serveurs, réseau et stockage) ont une fâcheuse tendance à s'estomper avec la virtualisation.

Les éditeurs l'ont d'ailleurs bien compris et multiplient les annonces de nouveaux outils d'administration, avec une attention toute particulière à des domaines comme le provisionning et le déploiement d'environnements virtuels (notamment les outils de LabManagement), les outils de gestion de capacité, les outils d'administration de performance… Derniers outils en date, les outils de refacturation (chargeback) ont commencé à faire leur apparition tant chez Citrix que chez VMware.

Ce dernier point est d'ailleurs révélateur de l'impact qu'à la virtualisation sur l'organisation des services IT. Car qui dit virtualisation dit mutualisation de capacités serveurs qui autrefois étaient dédiés à telle ou telle application ou service métier. Et qui dit mutualisation, dit nécessité de définir une forme de métrique pour pouvoir refacturer l'usage réel aux services métiers.

Reste que cette question de la refacturation est vue par certains comme la porte ouverte à plus d'externalisation. Car à terme avec l'avènement des architectures virtualisées en nuage, les services métiers vont pouvoir benchmarker bien plus facilement le coût de leurs services informatiques internes avec les prestations de tiers. La virtualisation de serveurs ouvrirait-elle la porte à celles des informaticiens ?

La chasse à ESX Server est ouverte. L'hyperviseur qui a ouvert le marché de la virtualisation et s'accapare aujourd'hui près de 90% des déploiements est aujourd'hui la cible de ses grands concurrents dont les offres arrivent à maturité. Jusqu'alors, VMware pouvait se targuer de jouir d'une considérable avance technologique sur ses concurrents, tant au niveau de l'hyperviseur de base qu'au niveau des outils d'administration liés à l'hyperviseur. Cette avance se réduit.

Les hyperviseurs concurrents de vSphere ESX arrivent à maturité

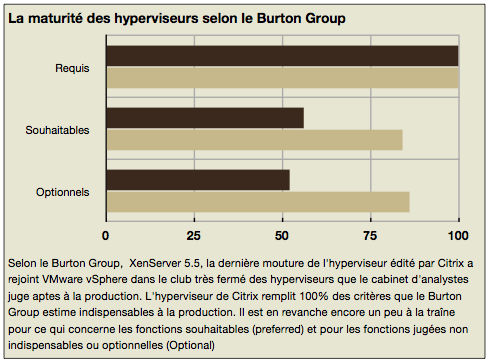

Pour la première fois le Burton Group a ainsi admis que XenServer 5.5 remplissait 100% des critères éxigés par le cabinet d'analyse pour un hyperviseur adapté à la production. Il est à ce jour le second hyperviseur à obtenir ce statut, après ESX Server. Certes, le cabinet d'analyse indique que l'offre d'outils d'administration et les capacités étendues de XenServer ne sont pas encore au niveau de l'offre de VMware, mais dans la plupart des cas, il admet implicitement que XenServer est parfaitement adapté à un usage quotidien en production. Les hyperviseurs de Microsoft et Oracle n'ont pas encore atteint l'ensemble des critères définis par le cabinet d'analyse, mais ils progressent rapidement. Oracle devrait ainsi lancer la version 2.2 d'Oracle VM à l'automne et fourbit la version 3.0 pour le printemps 2010, une version qui alliera le meilleur des développements maisons ainsi que les apports technologiques de Virtual Iron et de Sun. Microsoft de son côté a achevé le développement d'Hyper-V 2 qui sera disponible dans le futur Windows Server 2008 R2 dès le mois d'août pour les clients entreprises disposant d'un contrat de licence en volume et en Octobre dans les bacs des revendeurs. Tous ces hyperviseurs incluent des dispositifs comme le backup consolidé, le déplacement en temps réel de machines virtuelles ou la haute disponibilité, de quoi satisfaire les besoins de la plupart des entreprises.

La différence se fait encore sur les fonctions avancées des hyperviseurs (allocation granulaire de mémoire, tolérance aux pannes, performances en entrées/sorties), mais surtout sur l'offre d'outils d'administration et d'automatisation disponible autour des hyperviseurs. A ce jeu, VMware garde une longueur d'avance. La firme enrichit régulièrement sa propre offre d'outils autour de l'hyperviseur ESX (offre vCenter) et elle a aussi encouragé le développement d'un écosystème de partenaires dynamiques, attirés, il est vrai, par la large base installée ESX.

En face pourtant, l'offre s'organise. Citrix est sans doute celui qui est le plus en pointe avec le développement de son offre "Essentials" qui apporte à XenServer et à Hyper-V des composants précieux en matière de Lab Management, d'administration du stockage et de gestion de la haute disponibilité. Microsoft, de son côté s'est pour l'instant largement concentré sur la gestion des machines virtuelles avec System Center VMM, mais il a aussi travaillé sur l'aspect protection avec System Center DataProtection Manager qui a été optimisé pour supporter les environnements Hyper-V.

Les clients tentés par la concurrence

Cette arrivée à maturité des concurrents de VMware n'est pas passée inaperçue chez les clients. France Télécom, dont 90% des 20000 serveurs sont des machines x86, a ainsi décidé d'évaluer Citrix XenServer en parallèle de VMware ESX afin de disposer de deux fournisseurs de technologies. En France, des clients comme Bouygues Construction (ex Structis) et Generali, ont quant à eux décidé de mettre en œuvre Hyper-V. Renault ne cache pas qu'il utilise à la fois VMware et les technologies de virtualisation Xen de Novell...

Reste que VMware garde pour l'instant la haute main sur les grands déploiements au cœur des datacenters, quand ses concurrents sont pour l'instant plutôt utilisés à l'échelle départementale. Cette situation devrait logiquement évoluer avec le temps, du fait sans doute d'un rééquilibrage naturel des parts de marché de chacun. Certains comptes ne cachent pas non plus leur agacement vis à vis de la politique tarifaire, jugée excessive, de VMware. A l'occasion du lancement de vSphere ce dernier a peut-être été un peu gourmand en créant un nouveau programme de licence au-dessus de son programme Entreprise, le programme Entreprise Plus qui est le seul à apporter les innovations les plus marquantes de vSphere et notamment le commutateur réseau virtuel distribué ainsi que le support des machines virtuelles SMP à 8 cœurs. Une nouvelle licence qui fait grincer des dents intégrateurs et utilisateurs, en ces temps de crise, d'autant que ceux qui payaient une licence entreprise et pensaient bénéficier des nouvelles fonctions avancées doivent aujourd'hui payer une rallonge s'ils veulent en bénéficier.

VMware a officiellement débuté la commercialisation de vSphere au mois de mai après avoir largement dévoilé les caractéristiques de son offre de virtualisation de nouvelle génération lors des VMworld de Las Vegas et de Cannes. vSphere est présentée à la fois comme la nouvelle génération de produits d'infrastructure de VMware et donc comme le digne successeur de l'offre VMware Infrastructure, mais aussi comme la première étape d’une initiative lancée par VMware en septembre dernier à Las Vegas pour créer ce qu’il appelle un OS virtuel pour centres de calcul.

Pour le CEO de l'éditeur, Paul Maritz, vSphere veut d’abord répondre à un besoin, celui « d’une nouvelle interface vers l’infrastructure. » vSphere peut ainsi être perçu comme un millefeuille d’abstraction intercalé entre équipements serveurs et applications. Parmi les couches du millefeuille figurent notamment vCompute pour la virtualisation du matériel, vStorage pour la gestion du stockage, vNetwork pour la gestion du réseau et encore vSafe pour sécurité. Tous ces services d'abstraction de l'infrastructure doivent permettre aux entreprises de mieux exploiter leurs datacenters mais surtout de gérer avec une souplesse jusqu'alors inconnue le fonctionnement de leur informatique.

Virtualiser, de la PME au Cloud

Vsphere ne se limite pas aux datacenters. Il doit jouer un rôle de la PME aux grandes infrastructures en nuage . Pour les PME, VMware met en avant le concept de « always-on IT in a box ». Il s'agit d'offrir aux PME les moyens de bâtir simplement une infrastructure virtualisée résiliente. Bref une version moderne de l'AS/400 mais sur une base ouverte et standard: « vous pouvez prendre une configuration relativement modeste, avec quelques serveurs, et un contrat de maintenance périodique. En cas de panne d'un élément, votre infrastructure continuera de fonctionner, du fait de la résilience de vSphere. Lors de l’intervention de maintenance programmée, vous n’aurez qu’à faire remplacer le composant défectueux. » Ticket d’entrée : 3000 € pour trois serveurs bi-processeurs pour l'offre vSphere Essentials Plus (qui inclut la haute disponibilité, mais pas le vMotion) .

A l'autre bout de la chaîne informatique, vSphere doit aussi répondre aux besoins des grands opérateurs d'infrastructures en nuage. Selon Paul Maritz, plus de 400 partenaires « vont supporter vSphere au sein de leurs clouds », parmi lesquels des géants tels qu'AT&T, Savvis, Terramark, Verizon, ou plus proche de nos contrées, BT, Orange ou T-Systems… Ce support de vSphere dans les grandes infrastructures d'hébergeurs doit offrir plusieurs garanties aux entreprises clientes. La première – et pas la moindre – étant l’assurance d’une continuité dans le respect des politiques – de sécurité comme de configuration – appliquées à des serveurs ou des applications virtuels. Au final, pour Paul Maritz, le métier d’hébergeur ne consistera plus à louer des serveurs mais à vendre un package de capacités.

Plus de puissance mais aussi une meilleure gestion de l'ensemble des composants de l'infrastructure

Bien sûr pour parvenir à satisfaire les besoins les plus exigeants, VMware a du doper les capacités de son hyperviseur. ESX Server 4.0, c’est ainsi plus de puissance et une capacité de consolidation en hausse de près de 30% selon l'éditeur, avec notamment la possibilité d’agréger au sein d’un unique pool de ressources jusqu’à 32 serveurs physiques et 2 048 cœurs ; 1 280 machines virtuelles, 32 To de mémoire vive, 16 péta-octets de stockage et 8 000 ports réseau. Chaque serveur virtuel pourra se voir allouer, d’ici la fin 2009, jusqu’à 8 processeurs virtuels et 256 Go de mémoire vive et un même serveur physique pourra disposer d'une bande passante réseau effective de 40 Gbps.

Les nouveautés de vSphere ne se limitent toutefois pas à cette seule course au gigantisme. Il y a tout d'abord une bien meilleure gestion du réseau avec la notion de commutateur distribué (uniquement dans la version entreprise plus), permettant à un pool de serveur d'oeuvrer au sein d'un même domaine de commutation, mais surtout la possibilité d'étendre les capacités du produit avec des commutateur virtuel tiers comme le Nexus 1000V de Cisco, revendu par VMware et exploité par la couche vNetwork de virtualisation des interfaces réseau. La couche vCompute offre aussi de nouvelles fonctions pour optimiser la gestion des entrées/sorties, mais aussi la consommation énergétique, avec la fonction Distributed Power Management, qui permet d'optimiser la consommation à l'échelle d'une ferme de serveurs, par exemple en optimisant le placement des machines virtuelles, mais aussi en exploitant les capacités des dernières puces d'Intel et AMD. La couche vStorage, enfin, s’enrichit de fonctions d'allocation granulaire et dynamique de capacité (Thin Provisionning) et peut adapter, à la demande, la taille des volumes logiques. Le tout est complété par le support de la migration en temps réel des machines virtuelles et de leurs unités de stockage.

Cet ensemble de fonctions est d’ailleurs astucieusement exploité par VMware pour son option Fault Tolerance (licences Advanced, Entreprise et Entreprise plus) : activable en un clic de souris, elle permet la création d’un clone d’une machine virtuelle sur un autre serveur physique; l’état des deux machines virtuelles est synchronisé en continu. De quoi garantir la continuité de service pour les applications concernées en cas de défaillance physique. La sécurité n'est pas oubliée : avec vShield Zones, les machines virtuelles sont isolées par zones, avec des pare-feu virtuels ; l’isolation est maintenue selon les mêmes règles même lorsque l’on déplace les machines virtuelles avec vMotion.

La suite vSphere 4 affiche des tarifs alléchants en entrée de gamme, mais au prix d'une sérieuse amputation de ses fonctions. A l'inverse, en haut de gamme, les licences de la version entreprise plus affichent des tarifs salés, à environ 3500 € par processeur pour une version avec un an de support 24x7. Pour ceux que l'usage de la calculatrice répugne, cela veut dire 14000 € pour un serveur quadri socket, et encore sans intégrer le coût de la licence de la console d'administration vCenter, facturée en sus. La découverte de ces tarifs a d'autant plus fait grincer des dents certains clients, que la version entreprise plus est une nouveauté de vSphere 4. Les entreprises qui disposaient de licence Entreprise d'ESX 3.5 avec contrat de maintenance doivent donc remettre au pot si elles veulent bénéficier des fonctions avancées apportées par la nouvelle mouture. Bref, VMware fait payer cher son avance technologique, une stratégie risquée à l'heure où ses concurrents font preuve d'une bien plus grande modération tarifaire et où les budgets IT dédiés à l'infrastructure sont en forte baisse.

Profitant de sa conférence Synergy 2009, Citrix a annoncé le 6 mai dernier le lancement de XenServer 5.5, la dernière mouture de son environnement de virtualisation pour serveurs. 100% gratuit depuis la fin du mois de mars (y compris pour les fonctions avancées comme le déplacement en temps réel de machines virtuelles), XenServer a semble-t-il vu son rythme d'adoption s'accélérer avec le passage en mode gratuit. Lors d'un entretien avec LeMagIT, John Humphreys, le directeur du marketing produit pour les logiciels de virtualisation et d'administration de Citrix, nous a ainsi expliqué que près de 20 000 licences XenServer gratuites avait été activées au cours du seul mois d'avril. Si ce rythme se maintient, explique Humphreys, XenServer devrait contrôler environ 15% du marché de la virtualisation de serveur d'ici la fin de l'année.

Pas de révolution, mais des évolutions demandées par les utilisateurs

Alors que VMware vient de lancer la version 4.0 d'ESX Server et que Microsoft met la dernière main à la version 2.0 d'Hyper-V, Citrix n'a pas apporté d'évolution radicale à un produit qui avait déjà bien évolué avec sa version 5.0. L'éditeur s'est plutôt efforcé de répondre aux principales demandes d'améliorations exprimées par ses utilisateurs. La version 5.5 apporte ainsi une fonction de backup consolidé, qui permet aux outils de sauvegarde des éditeurs tiers de s'interfacer avec XenServer pour fournir des services de backup des VM mais aussi des environnements qu'elles contiennent. Autre nouveauté, il est désormais possible désormais d'exécuter des snapshot des VM directement depuis l'interface graphique d'administration XenCenter, même lorsque le stockage est local. Toutefois, la restauration de ces snapshots nécessitera de passer par l'interface en mode ligne de commande.

Citrix a également amélioré XenConvert, son outil de conversion de machines virtuelles, pour simplifier la migration des VM au format VMDK de VMware vers le format VHD utilisé par Hyper-V et XenServer. XenConvert supporte aussi les formats OVF (open virtualization format), OVA (open virtual appliance) et XVA (XenServer virtual appliance). Une dernière nouveauté mise en avant par Citrix est l'intégration entre XenCenter et Active Directory qui permet désormais aux administrateurs de faire hériter les environnements XenServer de droits Active Directory.

Pas (encore) de support pour la virtualisation d'entrées/sorties

Citrix est plus discret sur l'absence du support dans cette nouvelle mouture des fonctions de virtualisation d'entrées/sorties dans les nouveaux serveurs à base de Xeon 5500. A ce jour, seul VMware supporte ces fonctions avec ESX 4.0 (quoique sur un nombre très limité de cartes I/O et avec un support expérimental). Lors d'un entretien avec LeMagIT, Ian Pratt, le père de Xen, aujourd'hui vice-président du groupe Produits Avancés de Citrix, nous a confié que cette absence est un choix de conception de la part de l'éditeur. Le support de la virtualisation d'I/O est en effet présent dans le moteur open source Xen 3.3, mais Citrix a fait le choix de ne pas la supporter dans XenServer. Pratt estime qu'en l'état, la virtualisation d'I/O pose plusieurs problèmes.

Tout d'abord, si ouvrir un chemin direct entre une VM et un périphérique améliore les performances, cela contraint aussi à installer les pilotes adaptés dans les VM et nuit donc à leur mobilité - ainsi l'usage de VMdirectPath dans VMware ESX bloque toute possibilité de VMotion, l'hyperviseur ne contrôlant pas l'état des périphériques. Citrix travaille sur un schéma de pilote hybride, qui permettra de résoudre ce problème dans une future mouture, en faisant en sorte que la VM bascule sur un pilote générique si elle est déplacée vers un serveur qui ne dispose pas de la même carte réseau ou du même HBA Fibre Channel que le serveur source. Un autre problème pointé du doigt par Pratt est l'immaturité des premières cartes d'entrées/sorties supportant le standard de virtualisation d'I/O SR-IOV. La virtualisation d'entrées-sorties ne donc devrait arriver qu'avec la prochaine version majeure de XenServer, sans doute en 2010, ce qui permettra à Citrix de supporter aussi bien les implémentations d'Intel que celles d'AMD. Cette mouture devrait logiquement être basée sur la version 3.4 de Xen, une version que prévoit aussi d'utiliser Oracle pour OracleVM 3.0.

Des tarifs attractifs face à VMware

XenServer 5.5 est disponible immédiatement en téléchargement sur les serveurs de Citrix. Cette mouture est appuyée par une nouvelle offre d'administration payante, Citrix Essentials, qui apporte à XenServer des fonctions de provisionning de machines virtuelles (via Citrix Provisionning Server), de nouvelles fonctions d'orchestration et d'équilibrage de charge de machines virtuelles , ainsi qu'une intégration accrue avec les solutions de stockage et de gestion du stockage de près de 20 constructeurs. Essentials ajoute aussi à l'hyperviseur des fonctions de haute disponibilité. Une version dite Platinum de l'outil d'administration de Citrix fournit en outre des outils de Stage Management et de Lab Management, ainsi que le provisionning des machines virtuelles et des serveurs physiques. Citrix Essentials est vendu 2750 $ pour un serveur tandis que l'édition Platinum coûte 5500 $, des prix qui incluent un an de maintenance et auxquels il convient d'ajouter 1500 $ par serveur pour un support en heures ouvrées et 3000 $ pour un support 24x7 A titre de comparaison le package vSphere 4 Enterprise coûte environ 7000$ par serveur bi-processeur avec support en jours ouvrés. Il faut ajouter environ 3000$ par serveur bi-processeur pour Lab Manager. Ces prix doivent être doublés chez VMware pour des serveurs quadri-socket…

Avec Windows Server 2008 R2, l'offre de virtualisation de Microsoft devrait enfin arriver à maturité. Hyper-V 2.0 supportera notamment la mobilité en live des VM et permettra une meilleure gestion de l'allocation des ressources aux VM. Le nouvel hyperviseur devrait aussi simplifier l'usage des fonctions de haute disponibilité et exploiter les fonctions de virtualisation avancées des derniers processeurs AMD et Intel. Cerise sur le gâteau, il supportera officiellement l'exécution des principales distributions Linux, dont celles de Red Hat, en mode optimisé grâce à la fourniture en standard de pilotes paravirtualisés. Jusqu'alors, Microsoft ne supportait officiellement que les distributions de son allié, Novell.

Reste que Microsoft continue à se tirer des balles dans le pied pour ce qui concerne le support de Linux : Les composants d'intégration Linux d'Hyper-V, actuellement en RC2, fonctionnent bien comme promis avec Suse Linux (v10 et 11) et avec Red Hat (v5.x). Mais il ne supportent qu'un CPU virtuel par VM Linux et n'intègrent pas le support de la souris (sic) - ce support nécessite l'installation des pilotes "Satori" développés par Citrix, NDLR.

Reste qu'Hyper-V n'a pas été développé en priorité pour virtualiser des environnements Linux, mais pour devenir l'hyperviseur de référence dans les environnements Windows. Un univers où il entend éclipser l'hyperviseur de VMware en jouant notamment sur la carte des coûts et de l'intégration.

La migration en temps réel de VM grâce aux services de cluster

La nouveauté qui fait couler le plus d'encre pour cette version 2 d'Hyper-V est bien sûr le support de la migration en temps réel d'une machine virtuelle entre deux serveurs, une fonction proposée depuis déjà plusieurs années par les hyperviseurs Xen et par VMware et qui jusqu'alors échappait à Microsoft. Pour parvenir à ce résultat, Microsoft a adopté une approche technique qui s'appuie sur les services de clustering de Windows Server 2008 R2.

Pour déplacer une machine virtuelle entre deux serveurs, il faudra en effet que ceux-ci partagent un même volume de stockage au travers du système de volumes partagés en cluster (CSV, Cluster Shared Volumes). La migration ne sera possible qu'entre les noeuds d'un même cluster (16 noeuds maximum) et qu'à la condition express que les .VHD, qui stockent les machines virtuelles, soit situés sur le volume partagé.

L'utilisation des CSV permet à Microsoft d'offrir des fonctionnalités assez similaires à celle de VMFS de VMware : chaque noeud du cluster peut accéder de façon simultanée à un même LUN (logical unit number) comme s'il disposait d'un accès exclusif. L'usage des clustered services de Windows permet, en plus de la migration de VM, de disposer de services additionnels de haute disponibilité qui protègent les VM contre la chute d'un noeud mais aussi de liens réseaux. Les cluster Services assurent en effet la redirection dynamique des entrées sorties (SAN et LAN) en cas de défaillance d'un lien.

Un support amélioré de l'assistance à la virtualisation des puces AMD et Intel

Parmi les autres nouveautés d'Hyper-V 2.0, on note aussi le support de 32 processeurs logiques par noeud (soit deux fois plus qu'Hyper-V 1.0), la possibilité d'ajouter et de retirer dynamiquement des disques à une VM, et une bien meilleure gestion de la mémoire avec notamment le support des technologies de gestion de pages mémoire d'Intel et AMD (EPT et NPT) et l'allocation dynamique de mémoire aux VM en fonction de leur consommation réelle (une forme de Thin provisionning de la mémoire). Notons enfin le support des fonctions de TCP Offload Engine des cartes Ethernet pour iSCSI et le support de l'agrégation de liens Ethernet et le support des technologies de virtualisation d'I/O qui devrait simplifier la virtualisation des cartes HBA Fire Channel.

Comme avec la version actuelle d'Hyper-V, cette seconde mouture du logiciel sera fournie gratuitement avec Windows Server 2008 R2, mais aussi disponible sous la forme d'un hyperviseur autonome gratuit, Hyper-V Server 2.0. Les limitations de licence restent inchangées et il est fortement recommandé d'opter pour Windows Server Datacenter Edition pour bénéficier d'un nombre illimité de machines virtuelles Windows par serveur physique. A défaut, l'édition entreprise permet d'héberger jusqu'à 4 VM sous Windows par serveur… Notons pour terminer que la sortie d'Hyper-V 2.0 sera suivi de peu par celle d'une nouvelle mouture de System Center Virtual Machine Manager, l'outil de gestion de machines virtuelles de Microsoft et que Citrix proposera aussi une édition mise à jour de son outil d'automatisation et d'administration de stockage Citrix Essentials pour Hyper-V lors de la sortie du produit.

Avant de se lancer dans un projet de virtualisation, il est bien sûr nécessaire de définir les objectifs que l'on souhaite atteindre. S'agit-il de réduire le nombre de serveurs dans l'entreprise (consolidation), de maximiser la disponibilité des applications (haute disponibilité, tolérance de pannes, Plan de reprise après désastre), de rendre plus agile et plus flexible le système d'information (provisionning plus rapide de serveur, déplacement de capacité d'un datacenter à un autre…). Ces objectifs conditionneront le choix des technologies à mettre en œuvre mais aussi les points de l'infrastructure à faire évoluer. Ce n'est toutefois pas sur ces aspects que cet article souhaite s'appesantir, mais plutôt sur les points douloureux auxquels ont été confrontés nombre de projets de virtualisation au cours des deux dernières années, notamment la gestion des capacités, la gestion des performances, la cohabitation des équipes d'administration et le support logiciel.

Capacity Management : connaître son environnement pour bien le virtualiser…

L'une des conditions de la réussite d'un projet de virtualisation est de bien connaître les caractéristiques de son environnement avant de le virtualiser. Aucun projet ne devrait se lancer formellement sans une analyse détaillée des métriques d'utilisation des serveurs physiques en place et notamment celles touchant à la consommation CPU, à l'usage de la mémoire ainsi qu'à la gestion des entrées/sorties (I/O réseau et stockage).

Ces quatre métriques essentielles permettent de caractériser les environnements à virtualiser. On peut ainsi déterminer en connaissance de cause les bons candidats à la virtualisation et les applications qui devront continuer à tourner sur des serveurs physiques. On peut aussi construire des profils types d'environnements compatibles entre eux . Il est par exemple préférable d'éviter de consolider sur un même serveur des VM faisant un usage intensif de la mémoire et des I/O disques. De la même façon, on évitera de mixer des environnements ayant un comportement régulier avec des environnements ayant un comportement ératique. Idéalement, il est nécessaire de collecter les différentes métriques durant une période assez longue (quelques mois) afin d'avoir un aperçu des variations en fonction des périodes et des plages horaires, mais aussi d'avoir une idée de l'évolution de la charge des différents serveurs (on évitera par exemple de mettre sur un serveur virtualisé déjà bien occupé, une VM ayant un profil de consommation en forte croissance).

Ce travail peut être fait de façon plus ou moins manuelle pour un petit projet mais il devient rapidement ingérable dans le cas d'un grand projet sans l'appui d'un logiciel adéquat. Quelques éditeurs se sont fait une spécialité du capacity management et du capacity planning à des fins de virtualisation, comme Novell avec PlateSpin Recon, Systar avec Omnivision, ou Uptime Software. Notons aussi l'outil gratuit MAP (Microsoft Assessment and Planning développé par Microsoft pour Windows) et qui peut s'avérer très pratique pour un exercice de capacity planning initial.

…Et continuer à le suivre pour éviter les soucis

Imaginer pouvoir se satisfaire d'un exercice de capacity planning initial est en revanche suicidaire dans le cadre de déploiement importants impliquant plus d'une cinquantaine de machines virtuelles. Comme dans le monde physique, les machines virtuelles évoluent et peuvent voir leur profil de consommation évoluer dans le temps. Une VM qui initialement semblait ne pas poser de problème sur un serveur, peut rapidement perturber le fonctionnement de ses voisines en s'accaparant trop de ressources par rapport à ce qui était prévu. Il faudra alors envisager de la déplacer. Poru cela il faudra établir son nouveau profil, mais surtout disposer d'une analyse des capacités disponibles sur les autres serveurs afin de la déplacer sur la machine adéquate. Bref, vous l'aurez compris, en environnement virtuel, la gestion des capacités doit être un exercice récurrent (voire permanent) si l'on veut éviter les déconvenues en matière de service rendu aux utilisateurs.

Organisation : mettre en place des équipes transversales

L'un des impacts souvent inattendu des hyperviseurs est qu'ils rendent très floues les frontières traditionnelles entre les couches réseaux, calcul et stockage. DU fait de la fluidité des environnements virtualisés, il est donc préférable d'anticiper et de mettre en place des équipes pluridisciplinaires impliquant équipés réseaux, administrateurs systèmes et administrateurs stockage sous peine de voir un jour se déclencher une guerre larvée entre ces différents métiers. Dans un environnement virtuel il est en effet facile pour un administrateur système de s'accaparer certaines ressources habituellement gérées par les équipes réseau de même que l'intégration de systèmes de fichiers en clusters dans la plupart des hyperviseurs (VMware vSphere ESX, Microsoft Hyper V2, Oracle VM) a tendance à casser les schémas traditionnels d'administration du stockage, ce qui peut perturber les relations entre administrateurs systèmes et stockage.L'idéal est d'envoyer ces équipes se former ensemble et de les faire s'asseoir autour d'une table pour définir leurs règles de cohabitation en environnements virtualisés. D'autant qu'à l'avenir les frontières entre composants d'infrastructures devraient continuer à s'estomper…

Définir un modèle de coût afin de facturer les utilisateurs

Dans un modèle de production informatique traditionnel, chaque service métier se voit allouer ses propres ressources dédiées et est donc refacturé en conséquence. Mais dans un monde virtualisé, les ressources sont pour l'essentiel mutualisée et il est donc nécessaire de définir un modèle de coût afin de pouvoir refacturer de façon pertinente les utilisateurs mais aussi afin d'éviter certaines dérives. Certaines entreprises qui se lançaient dans la virtualisation ont ainsi été confrontées à une inflation galopante du nombre de leurs machines virtuelles faute d'avoir mis un coût sur ces machines. En affichant clairement et dès le départ, un prix (et accessoirement un temps minimum de provisionning de quelques heures, plutôt que de quelques minutes) on limite les risques d'abus. Afficher aussi une grille tarifaire est aussi un moyen pour un service informatique de se benchmarker face à ses concurrents extérieurs (notamment les outsourcers) mais aussi de définir des règles de recours (ou non) aux services de prestataires tiers comme les opérateurs d'infrastructures en nuage.

S'assurer du support de ses fournisseurs de logiciels

Un point souvent sous-estimé dans les projets de virtualisation touche aux aspects de support logiciel. Ce domaine reste un vrai champ de mines, aucun éditeur n'ayant adopté une politique homogène en matière de support technique sur les grands hyperviseurs du marché. Longtemps des éditeurs comme SAP ou Oracle ont refusé de supporter leurs clients faisant fonctionner leurs logiciels sur une couche de virtualisation. C'est un problème réglé chez SAP mais toujours saillant chez Oracle, qui n'assure un support total de ses solutions que sur son propre hyperviseur, OracleVM. Chez de nombreux petits éditeurs, les hyperviseurs sont aussi non grata, même si leurs solutions fonctionnent en général sans problèmes au-dessus d'une couche de virtualisation. Un autre problème persistant est celui des licences logicielles. Certains éditeurs facturent ainsi leurs outils au socket processeur, mais ne reconnaissent pas les capacités de découpage des hyperviseurs. Ainsi une machine virtuelle à laquelle on a alloué 2 CPU virtuels sur une machine à 4 CPU pourra se voir réclamer une licence pour 4 CPU chez certains éditeurs. Pire, certains éditeurs et pas des moindres, n'admettent pas que leur logiciel puisse être déplacé d'un serveur à un autre avec une technologie de migration en live (cela a par exemple été longtemps le cas de Microsoft, qui exigeait que ses logiciels ne changent pas de serveur avant un délai minimum de 90 jours après leur dernier déplacement) . Autant dire qu'il est prudent de se renseigner sur ce que son éditeur considère comme légitime avant d'imaginer virtualiser un logiciel…

La première vague de virtualisation est en train de s'achever chez les grands comptes français. Quelle leçon en tirez-vous ?

On voit une évolution du marché : de plus en plus d'entreprises ont acquis une forme de maturité. La première étape a été une étape de consolidation parfois grossière avec des taux de consolidation de 5, 10 et parfois 20 machines virtuelles par serveur physique. Mais cette vague s'est accompagnée d'un certain nombre de problèmes en matière d'analyse des ressources systèmes utilisées sur les serveurs et de gestion des capacités afin d'accroître le taux d'utilisation des serveurs.

Pour un éditeur d'outil de monitoring comme Systar, quelles évolutions a entraîné cette adoption de la virtualisation?

Nous sommes confrontés à des entreprises qui, de plus en plu,s expriment un besoin d'optimisation de la gestion de leurs ressources. On a fait évoluer nos offres dans ce sens-là avec un axe de développement sur ce que les Américains appellent le capacity management. Ça se traduit par de nouvelles capacités de reporting pour notre outil Omnivision. Nous pouvons désormais dire quels sont les clusters de serveurs virtualisés bien utilisés et bien densifiés. Ensuite, on a ajouté des outils permettant de définir quels profils de VM, on peut ajouter à un cluster sans impact négatif sur les machines déjà installées. Il s'agit notamment d'éviter ce que certains administrateurs ont appelé le vMotion sickness (la maladie du déplacement de machines virtuelles, du nom de la technologie de déplacement vMotion de VMware, NDLR)

Aux Etats-Unis, on a vu émerger un nouveau métier avec la virtualisation, celui de "Capacity Manager". Voyez-vous la même évolution en France ?

Les équipes Unix et Windows/Linux ne sont souvent pas les mêmes, mais on voit des équipes de ressource management unifiées émerger chez certains de nos grands clients, comme France Télécom, la Poste ou EDF. Ces équipes attendent d'Omnivision une vue normalisée de l'ensemble de leurs ressources. Ce qui n'empêche pas d'avoir des rapports particuliers pour les équipes dédiées.

Pour approfondir sur Green IT

-

![]()

VMware travaille avec Nvidia pour supporter la virtualisation de GPU dans Horizon View

-

![]()

Citrix dévoile la version 6.1 de son hyperviseur XenServer

-

![]()

Virtualisation en 2012 : vers un affrontement relancé entre VMware et Microsoft

-

![]()

Avec XenServer 6.0, Citrix veut concurrencer VMware sur le marché du cloud